MiniCPM-V4.0: 매우 효율적인 대규모 엔드투엔드 모델

1. 튜토리얼 소개

MiniCPM-V 4.0은 칭화대학교 자연어 처리 연구실과 Mianbi Intelligence가 2025년 8월 오픈소스로 공개한 매우 효율적인 대규모 엔드사이드 모델입니다. MiniCPM-V 4.0은 SigLIP2-400M과 MiniCPM4-3B를 기반으로 하며, 총 매개변수 수는 4.1B입니다. MiniCPM-V 2.6의 강력한 단일 이미지, 다중 이미지 및 비디오 이해 성능을 계승하여 효율성을 크게 향상시킵니다. Mianbi Intelligence는 iPhone 및 iPad용 iOS 애플리케이션도 동시에 오픈소스로 제공했습니다. OpenCompass 평가에서 MiniCPM-V 4.0의 이미지 이해 성능은 GPT-4.1-mini-20250414, Qwen2.5-VL-3B-Instruct, InternVL2.5-8B를 능가했습니다. 관련 논문 결과는 다음과 같습니다.MiniCPM-V: 휴대폰에서 사용하는 GPT-4V 레벨 MLLM".

이 튜토리얼에서는 단일 RTX 4090 그래픽 카드를 컴퓨팅 리소스로 사용합니다. 테스트를 위해 단일 또는 여러 이미지 채팅, 비디오 채팅, 그리고 소수의 사진으로 채팅의 세 가지 예시가 제공됩니다.

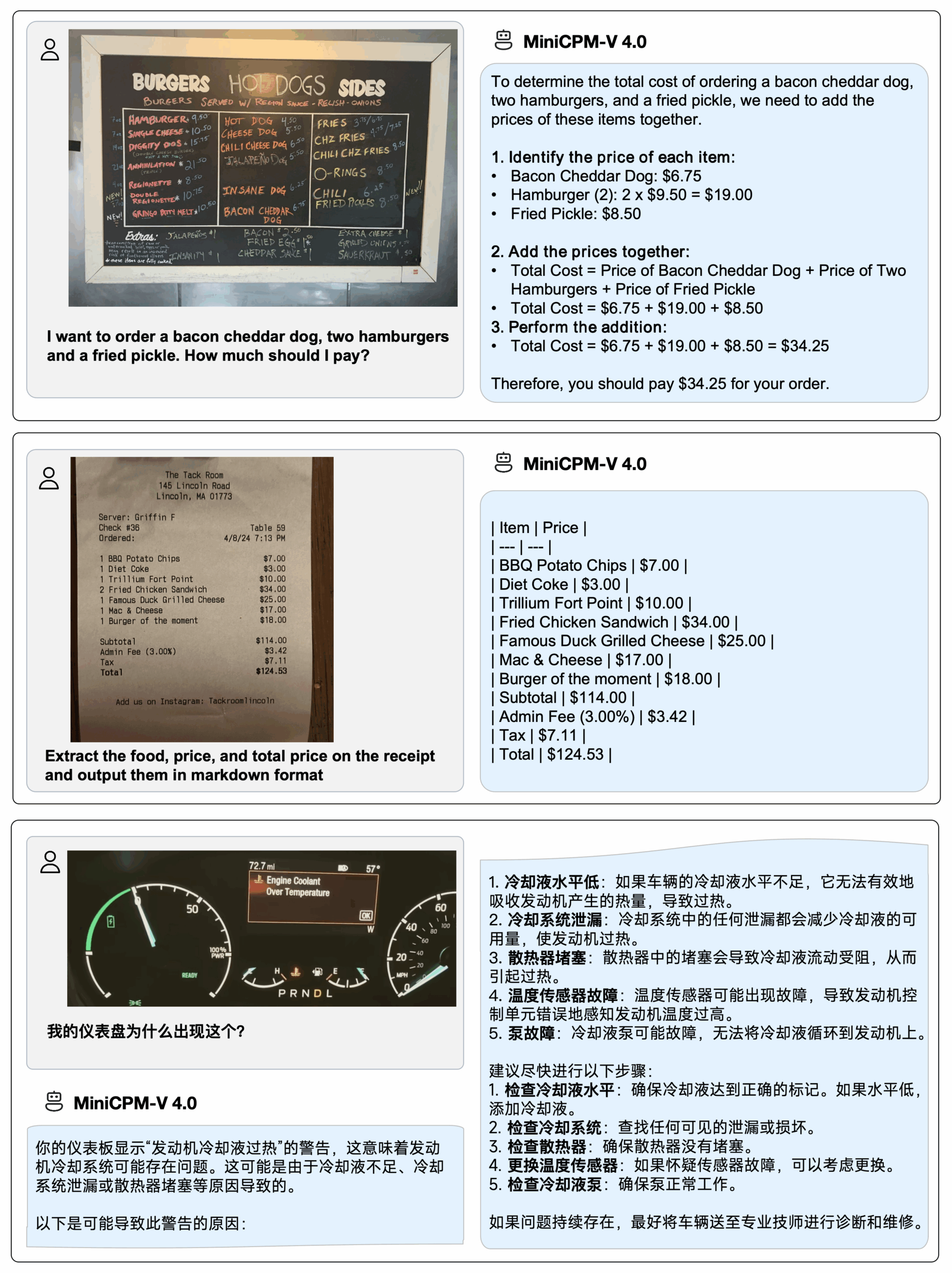

2. 효과 표시

iPhone 16 Pro Max에 MiniCPM-V 4.0을 배포하세요.iOS 데모데모 영상은 편집되지 않은 원시 화면 녹화 영상입니다.

3. 작업 단계

1. 컨테이너를 시작하세요

2. 사용 단계

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 약 2~3분 정도 기다리신 후 페이지를 새로고침해 주시기 바랍니다.

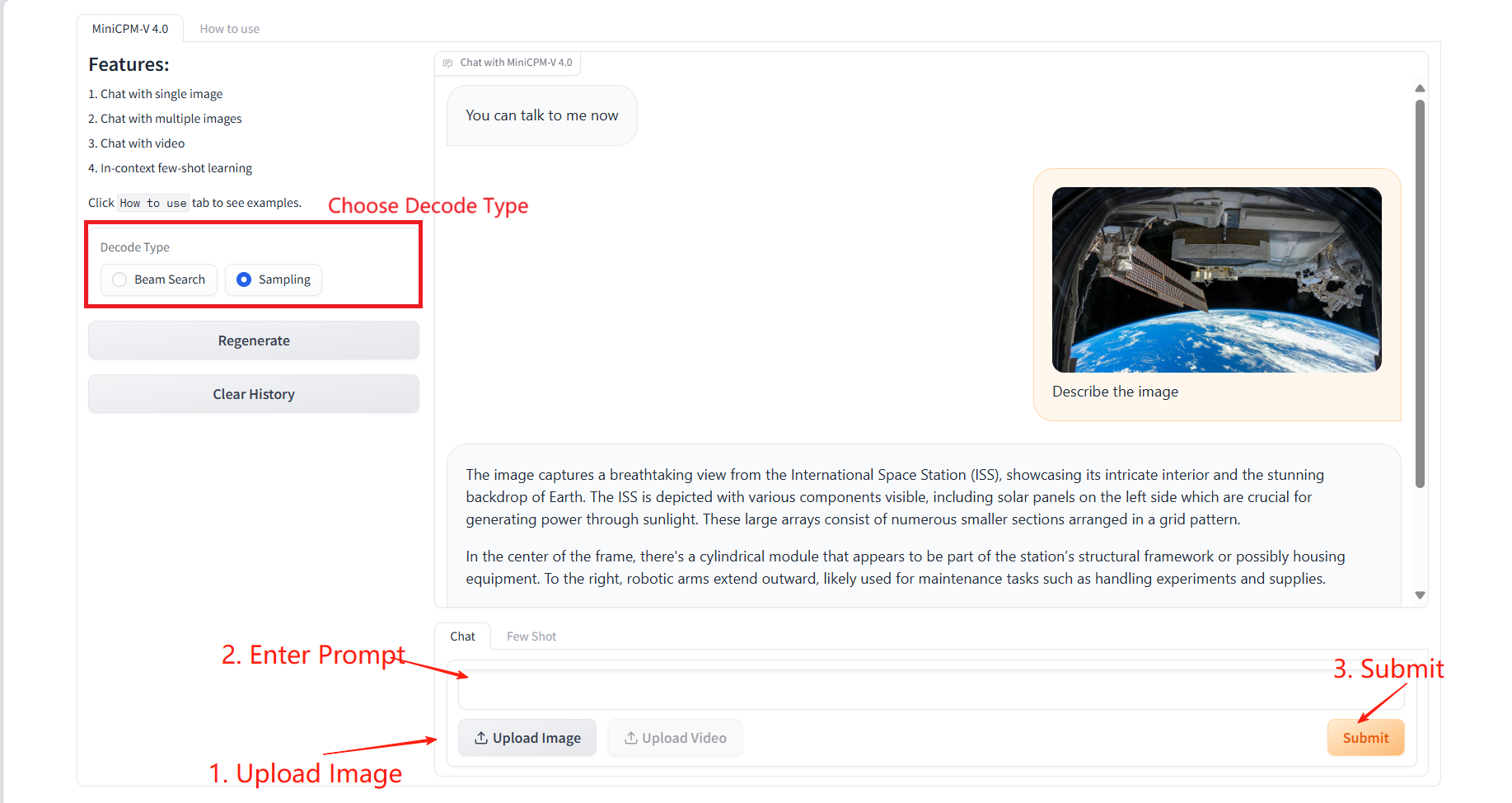

사용 방법"을 클릭하면 사용 가이드를 볼 수 있습니다.

1. 단일 또는 여러 이미지로 채팅

구체적인 매개변수:

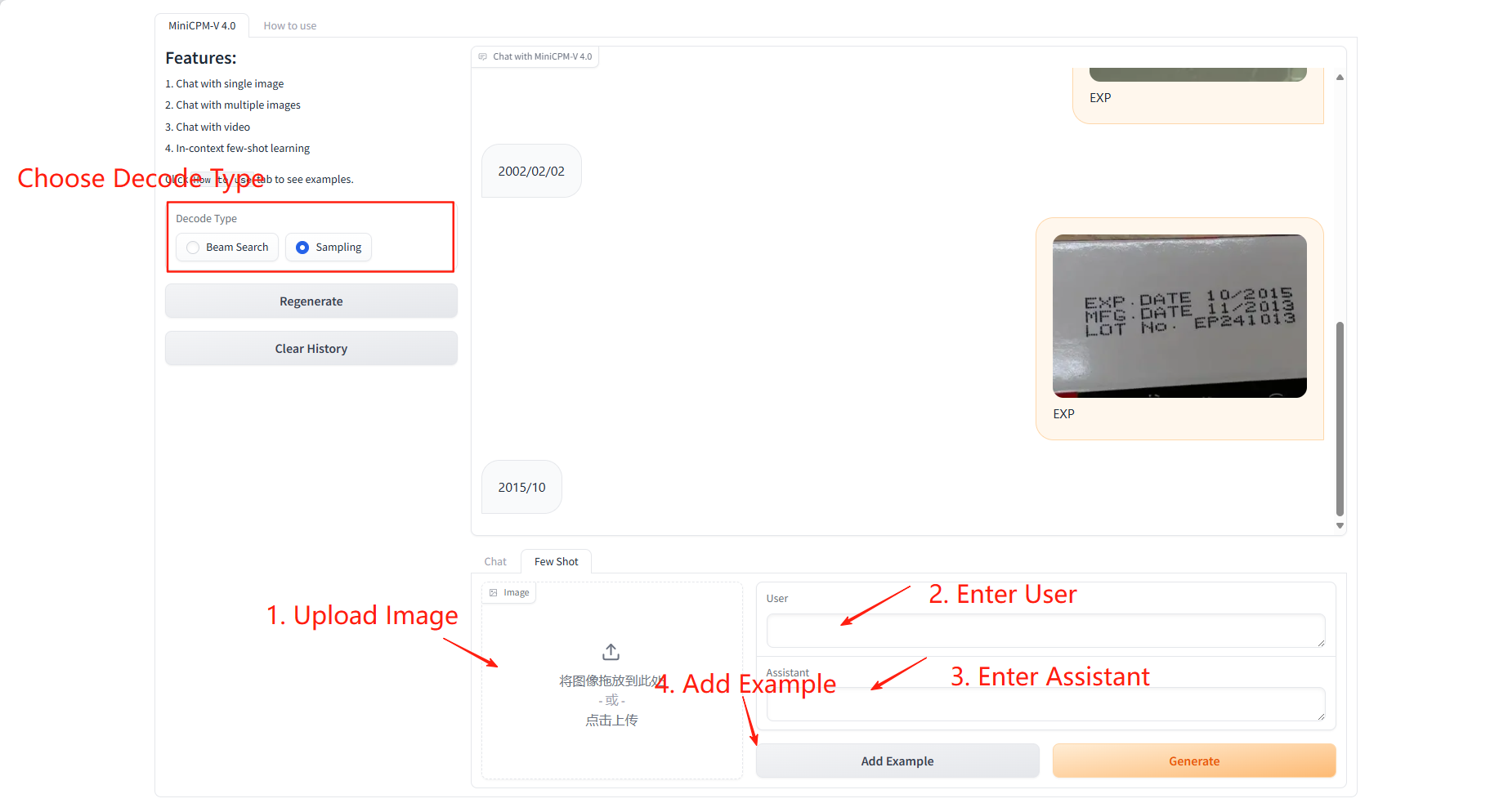

- 디코딩 유형:

- 빔 검색: 가장 가능성이 높은 후보 시퀀스를 보존하는 매우 결정론적인 디코딩 방법입니다. 정확하고 일관된 출력이 필요한 상황에 더 적합합니다.

- 샘플링: 확률 분포에 따라 다음 단어를 무작위로 샘플링하는 방식입니다. 출력 결과는 더 창의적이지만 불안정할 수 있습니다.

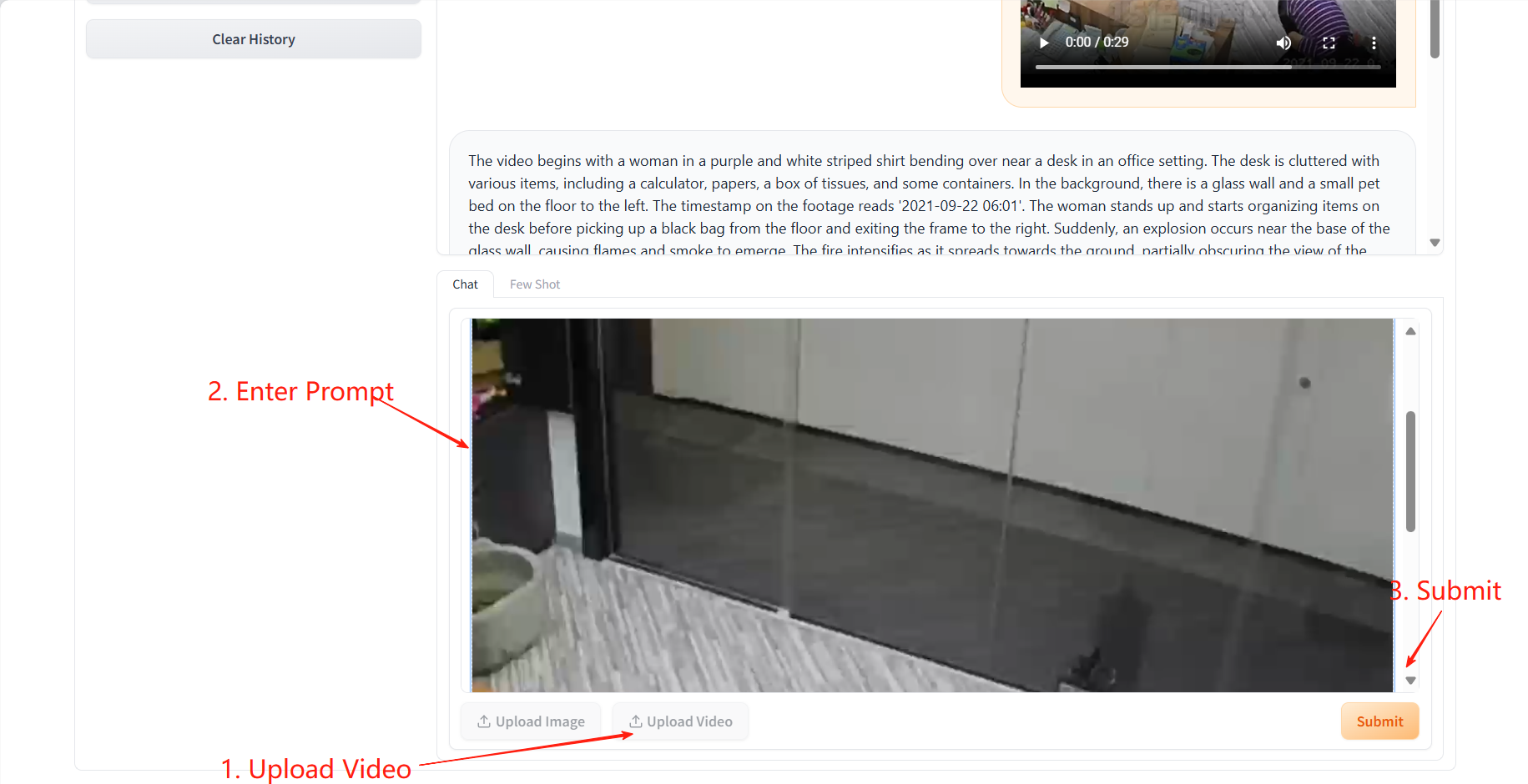

2. 영상 채팅

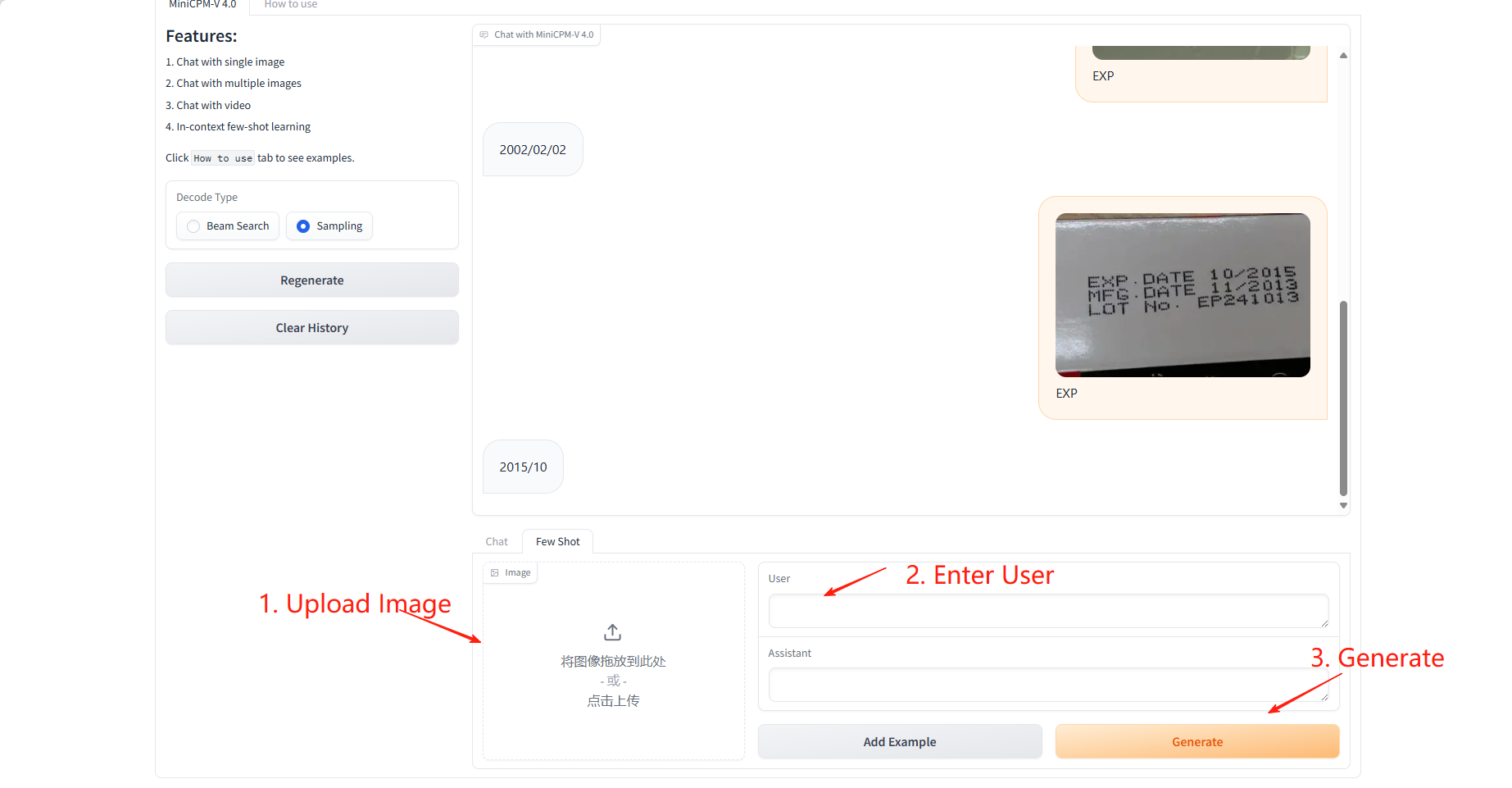

3. 몇 발의 총

샘플 학습

구체적인 매개변수:

- 사용자: 이 샘플에 대해 예측하거나 학습할 필드를 입력하세요.

- 도우미: 이 샘플에 대해 학습할 필드에 해당하는 값을 입력하세요.

결과 예측

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={Nat Commun 16, 5509 (2025)},

year={2025}

}

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}