Command Palette

Search for a command to run...

자체 강제 실시간 비디오 생성

1. 튜토리얼 소개

자가강제(Self-Forcing)는 2025년 6월 9일 Xun Huang 팀에 의해 제안되었습니다. 이는 자기회귀 비디오 확산 모델을 위한 새로운 학습 패러다임입니다. 이는 실제 맥락에서 학습된 모델이 추론 과정에서 자체적으로 불완전한 출력을 기반으로 시퀀스를 생성해야 하는, 오랜 노출 편향 문제를 해결합니다. 실제 맥락 프레임을 기반으로 미래 프레임의 노이즈를 제거하는 기존 방식과 달리, 자가강제(Self-Forcing)는 학습 과정에서 키-값(KV) 캐시를 사용하여 자기회귀 롤아웃을 수행함으로써 이전에 자체 생성된 출력을 기반으로 각 프레임의 생성을 조절합니다. 이 전략은 기존의 프레임별 목적 함수에만 의존하는 대신, 생성된 전체 시퀀스의 품질을 직접 평가하는 비디오 수준의 전체론적 손실 함수를 통해 감독을 구현합니다. 학습 효율성을 보장하기 위해 몇 단계 확산 모델과 확률적 기울기 절단 전략을 채택하여 계산 비용과 성능의 균형을 효과적으로 맞춥니다. 효율적인 자기회귀 비디오 외삽을 달성하기 위해 롤링 키-값 캐시 메커니즘이 추가로 도입되었습니다. 광범위한 실험을 통해 이 방법이 단일 GPU에서 1초 미만의 지연 시간으로 실시간 스트리밍 비디오를 생성할 수 있으며, 현저히 느리고 비인과적 확산 모델의 생성 품질을 달성하거나 심지어 능가할 수 있음을 보여줍니다. 관련 논문 결과는 다음과 같습니다.자기 강제: 자기 회귀 비디오 확산에서 학습-테스트 격차 해소".

이 튜토리얼에서는 단일 RTX 4090 카드에 대한 리소스를 사용합니다.

2. 프로젝트 예시

3. 작업 단계

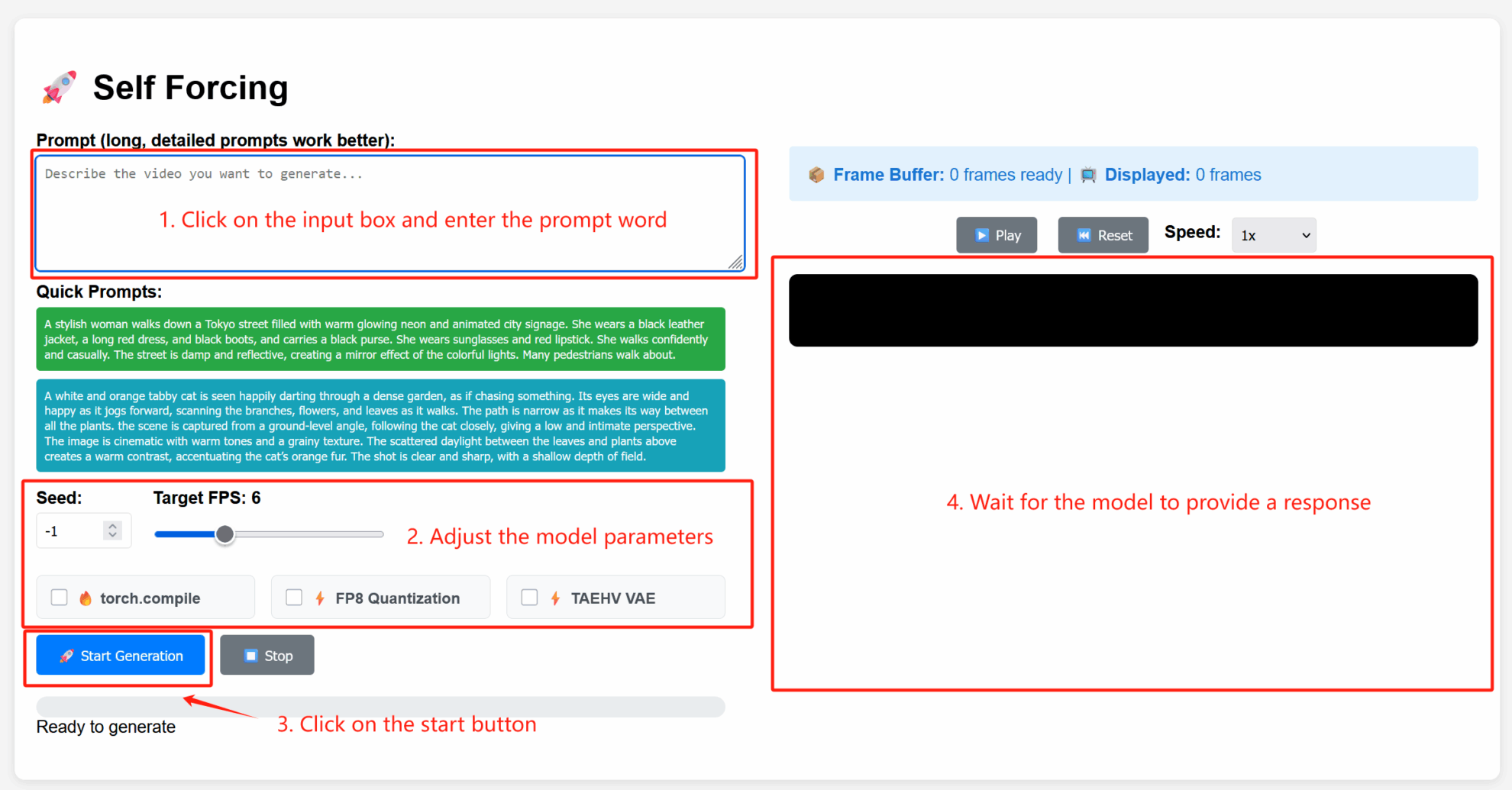

1. 컨테이너 시작 후 API 주소를 클릭하여 웹 인터페이스로 진입합니다.

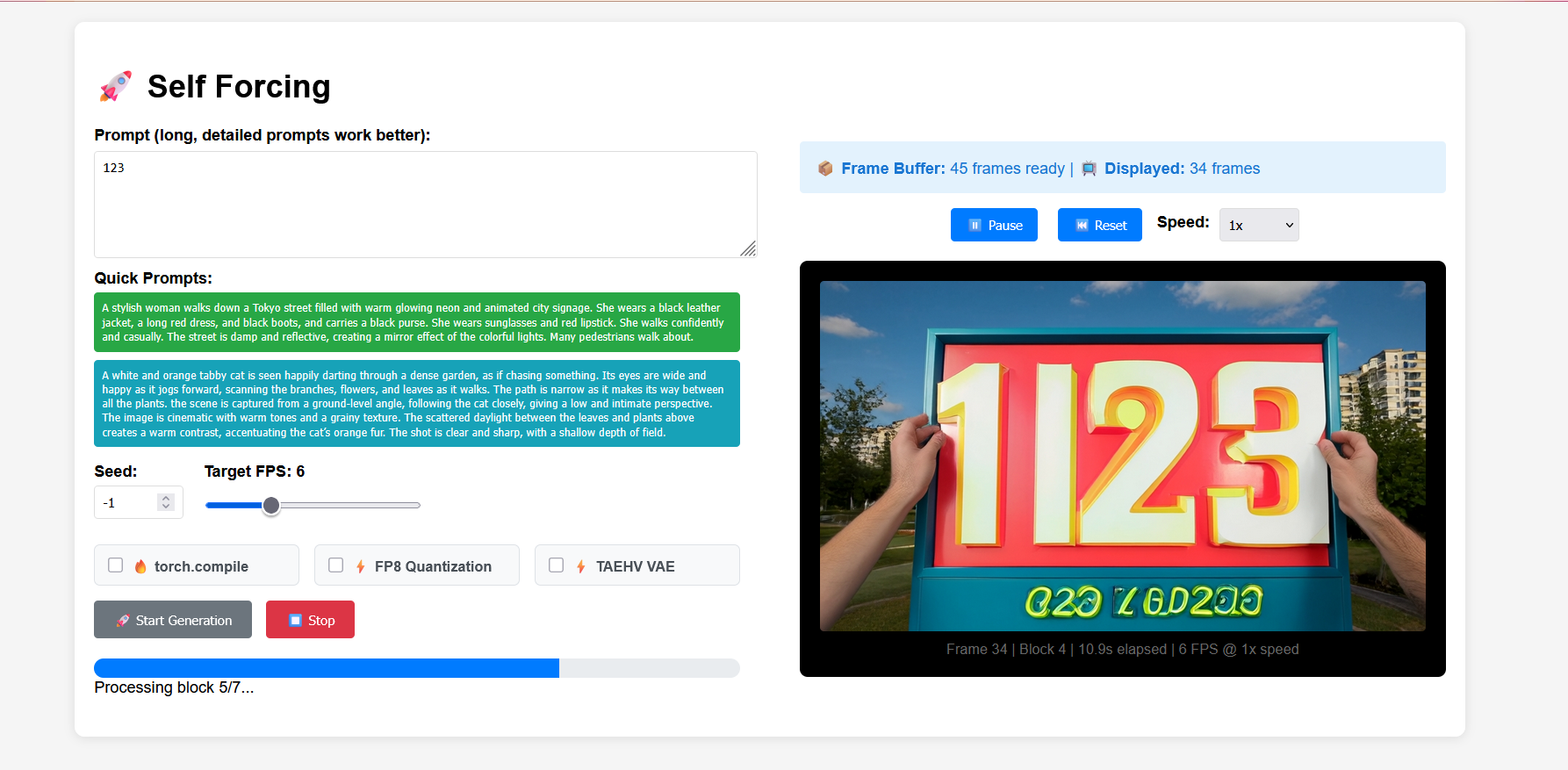

2. 사용 단계

매개변수 설명

- 고급 설정:

- 시드: 생성 과정의 무작위성을 제어하는 난수 시드 값입니다. 고정된 시드는 동일한 결과를 재현할 수 있으며, -1은 난수 시드를 나타냅니다.

- 목표 FPS: 목표 프레임 속도입니다. 기본값은 6이며, 이는 생성된 비디오가 초당 6프레임이라는 것을 의미합니다.

- torch.compile: PyTorch 컴파일 최적화를 활성화하여 모델 추론을 가속화합니다(환경 지원 필요).

- FP8 양자화: 8비트 부동 소수점 양자화를 활성화하여 계산 정밀도를 낮추고 생성 속도를 높입니다(품질에 약간 영향을 미칠 수 있음).

- TAEHV VAE: 생성된 세부 정보나 스타일에 영향을 줄 수 있는, 사용되는 VAE(변형 자동 인코더) 모델의 유형을 지정합니다.

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@article{huang2025selfforcing,

title={Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion},

author={Huang, Xun and Li, Zhengqi and He, Guande and Zhou, Mingyuan and Shechtman, Eli},

journal={arXiv preprint arXiv:2506.08009},

year={2025}

}