Command Palette

Search for a command to run...

Flow-GRPO 흐름 매칭 텍스트 그래프 모델 데모

1. 튜토리얼 소개

Flow-GRPO는 홍콩중문대학교 멀티미디어 연구실, 칭화대학교, 그리고 콰이쇼우 켈링 팀이 2025년 5월 13일에 출시한 플로우 매칭 모델입니다. 이 모델은 온라인 강화 학습 프레임워크와 플로우 매칭 이론의 통합을 선도했으며, GenEval 2025 벤치마크 테스트에서 획기적인 성과를 달성했습니다. SD 3.5 Medium 모델의 통합 생성 정확도는 벤치마크 값인 63%에서 95%로 향상되었고, 생성 품질 평가 지수는 GPT-4o를 처음으로 넘어섰습니다. 관련 논문 결과는 다음과 같습니다.Flow-GRPO: 온라인 RL을 통한 Flow 매칭 모델 학습".

이 튜토리얼에서는 리소스로 단일 RTX 4090 카드를 사용하고, 이미지 생성 프롬프트는 영어만 지원합니다.

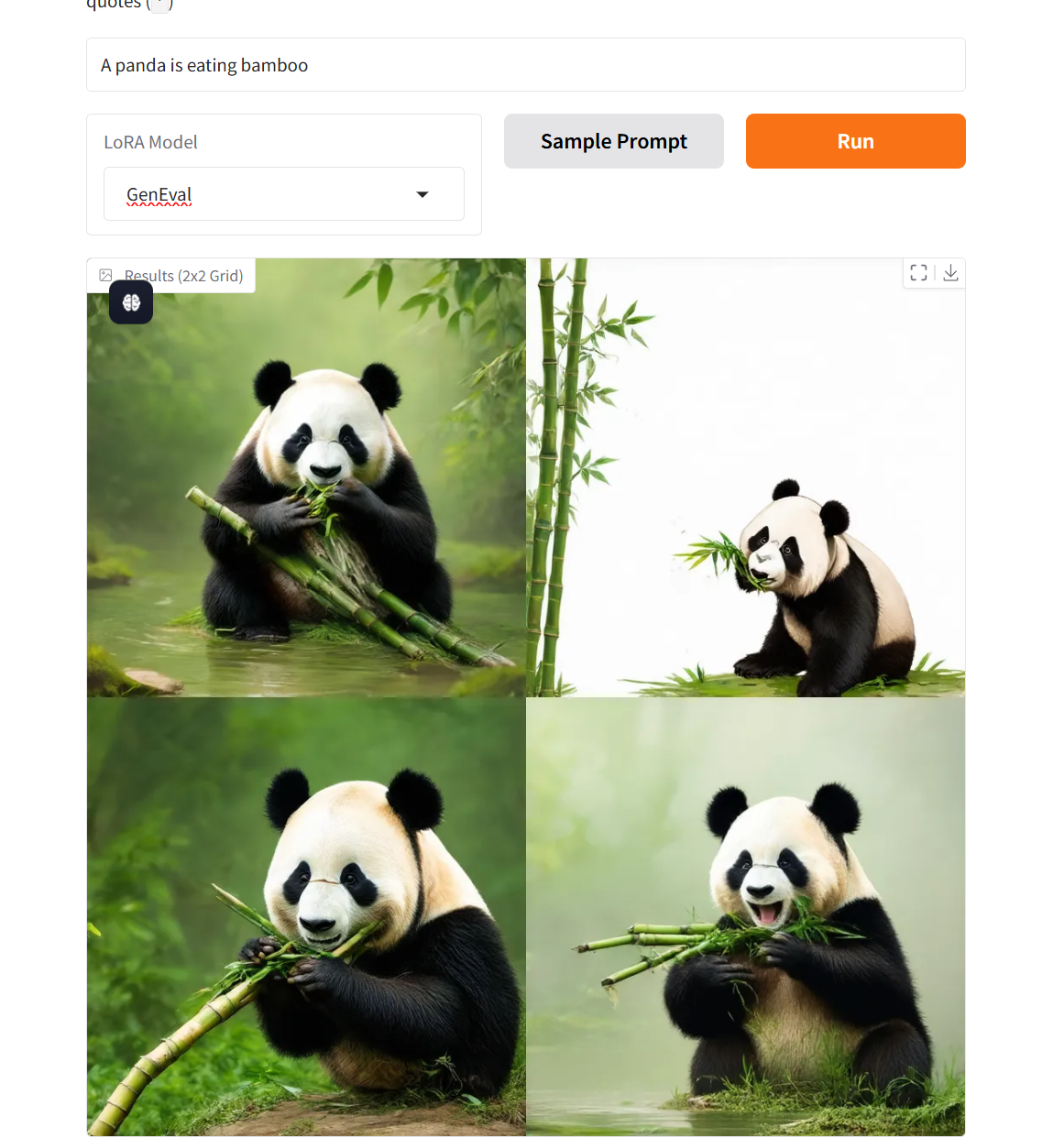

2. 프로젝트 예시

3. 작업 단계

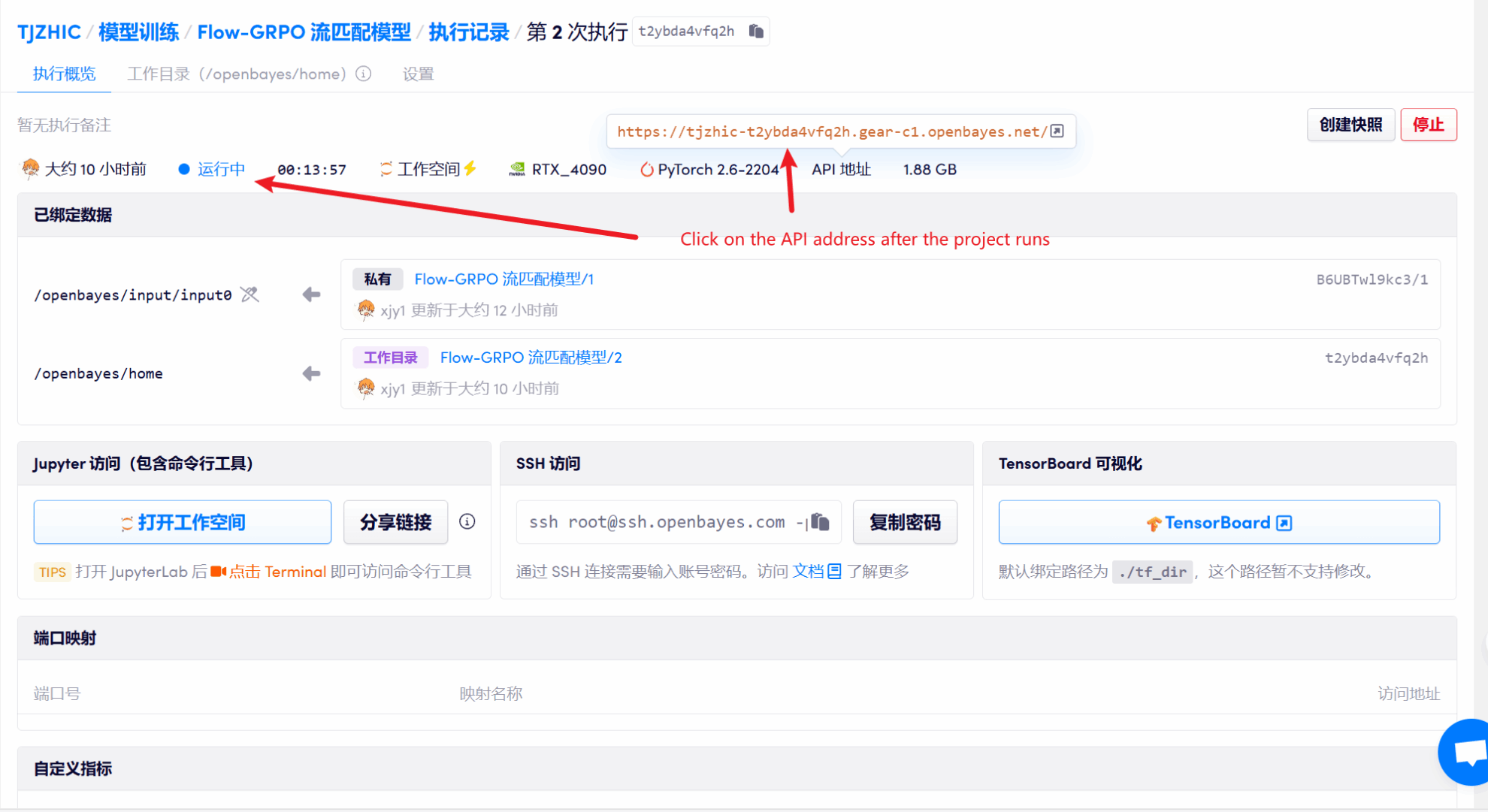

1. 컨테이너 시작 후 API 주소를 클릭하여 웹 인터페이스로 진입합니다.

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 1~2분 정도 기다리신 후 페이지를 새로고침해 주세요.

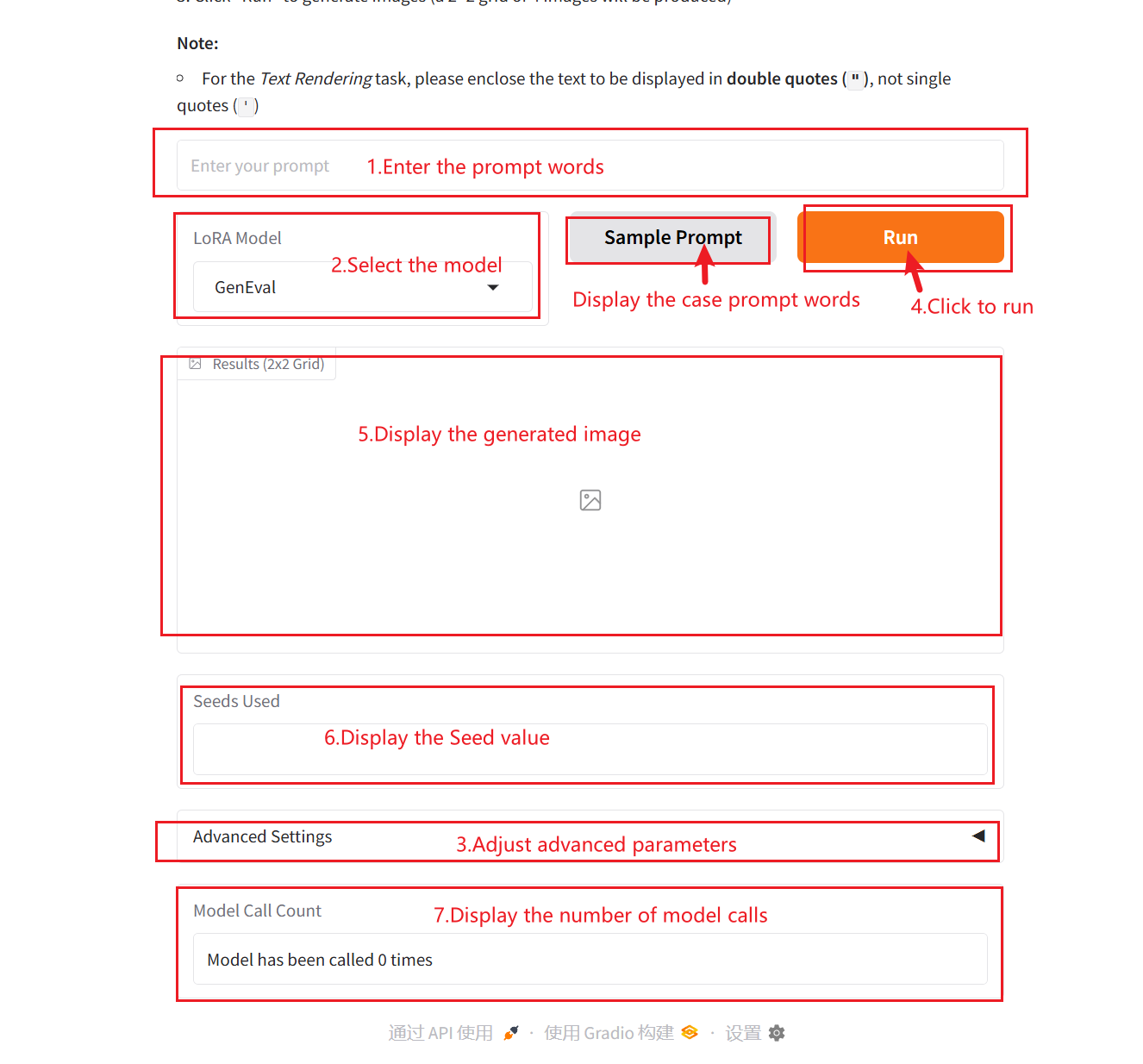

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

사용 방법

매개변수 설명:

- LoRA 모델:

- 없음: 기본 모델은 네이티브로 호출되며 최적화 전략은 도입되지 않습니다.

- 일반 평가: 복잡한 시나리오의 생성과 검증을 지원하기 위해 6차원 평가 시스템이 구축되었습니다.

- 텍스트 렌더링: 정확한 텍스트 시각화를 통해 그래픽과 텍스트 콘텐츠를 정확하게 매핑할 수 있습니다.

- 인간의 선호도 정렬: 미적 선호도의 정량적 정렬과 통합 PickScore 평가 프레임워크

- 시작 씨앗: 생성 과정의 무작위성을 제어하는 데 사용되는 난수 시드입니다. 동일한 Seed 값은 동일한 결과를 생성할 수 있습니다(다른 매개변수가 동일하다는 전제 하에). 이는 결과를 재현하는 데 매우 중요합니다.

- 너비: 생성된 이미지의 너비를 제어하는 데 사용됩니다.

- 키: 생성된 이미지의 높이를 제어하는 데 사용됩니다.

- 지침 척도: 생성 모델에서 조건부 입력(예: 텍스트나 이미지)이 생성된 결과에 미치는 영향의 정도를 제어하는 데 사용됩니다. 높은 지침 값을 사용하면 생성된 결과가 입력 조건과 더 일치하게 되지만, 낮은 값을 사용하면 더 많은 무작위성이 유지됩니다.

- 추론 단계 수: 모델의 반복 횟수 또는 추론 과정의 단계 수를 나타내며, 모델이 결과를 생성하는 데 사용하는 최적화 단계 수를 나타냅니다. 일반적으로 단계 수가 많을수록 더 정교한 결과가 나오지만 계산 시간은 늘어날 수 있습니다.

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

Github 사용자에게 감사드립니다 xxxjjjyyy1 이 튜토리얼의 배포. 이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@misc{liu2025flowgrpo,

title={Flow-GRPO: Training Flow Matching Models via Online RL},

author={Jie Liu and Gongye Liu and Jiajun Liang and Yangguang Li and Jiaheng Liu and Xintao Wang and Pengfei Wan and Di Zhang and Wanli Ouyang},

year={2025},

eprint={2505.05470},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2505.05470},

}