Command Palette

Search for a command to run...

vLLM+Open WebUI 배포 KernelLLM-8B

1. 튜토리얼 소개

이 튜토리얼에서 사용된 컴퓨팅 리소스는 RTX 4090 카드 1개입니다.

KernelLLM은 Meta AI에서 출시한 GPU 커널 개발을 위해 설계된 대규모 언어 모델입니다. PyTorch 모듈을 효율적인 Triton 커널 코드로 자동 변환하여 고성능 GPU 프로그래밍 프로세스를 간소화하고 가속화하는 것을 목표로 합니다. 이 모델은 Llama 3.1 Instruct 아키텍처를 기반으로 하며, 80억 개의 매개변수를 포함하고 효율적인 Triton 커널 구현을 생성하는 데 중점을 둡니다.

2. 프로젝트 예시

3. 작업 단계

1. 컨테이너를 시작하세요

"모델"이 표시되지 않으면 모델이 초기화되고 있음을 의미합니다. 모델이 크기 때문에 약 2~3분 정도 기다리신 후 페이지를 새로고침해 주시기 바랍니다.

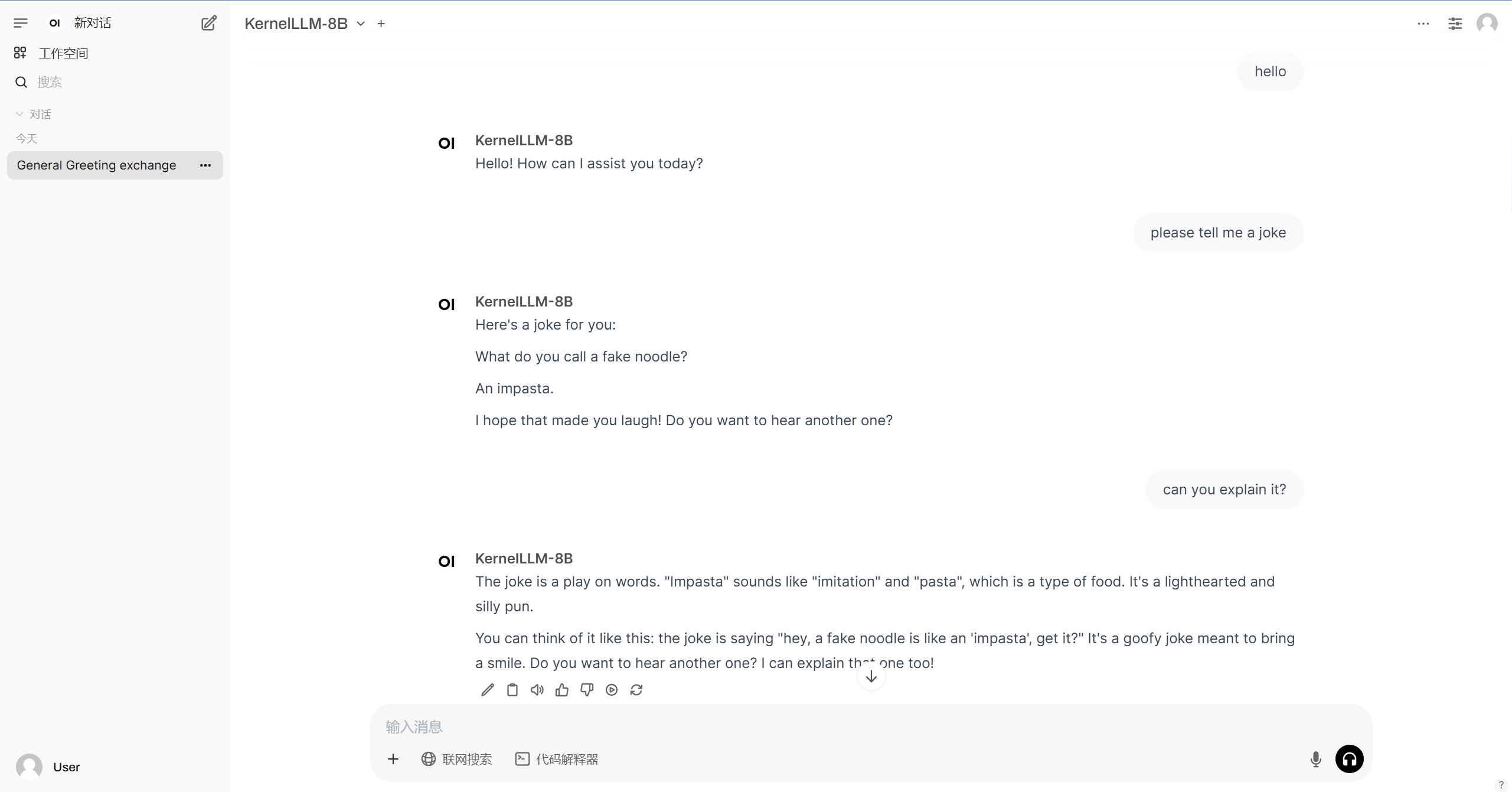

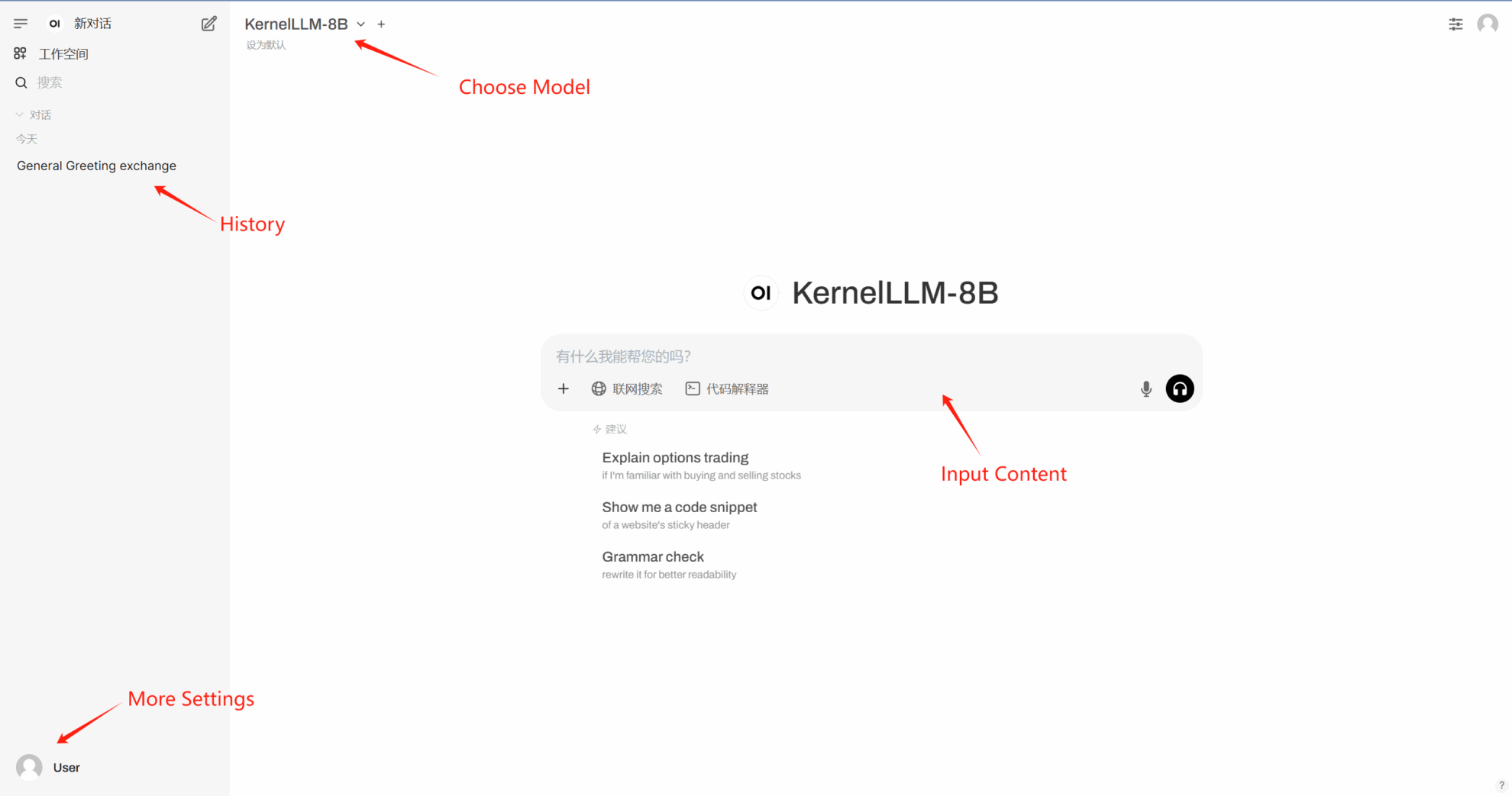

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓