Command Palette

Search for a command to run...

vLLM+Open WebUI 배포 MiniCPM4-8B

1. 튜토리얼 소개

MiniCPM 4.0은 OpenBMB가 2025년 6월 6일에 출시한 효율적인 엔드사이드 대용량 언어 모델(LLM)입니다. 희소 구조, 양자화 압축, 효율적인 추론 프레임워크와 같은 기술을 통해 낮은 컴퓨팅 비용으로 고성능 추론을 구현하며, 특히 장문 텍스트 처리, 개인정보 보호가 중요한 시나리오, 그리고 엣지 컴퓨팅 장치 구축에 적합합니다. MiniCPM4-8B는 긴 시퀀스 처리 시 Qwen3-8B보다 훨씬 빠른 처리 속도를 보여줍니다. 관련 논문 결과는 다음과 같습니다.MiniCPM4: 엔드 디바이스에서의 초고효율 LLM".

이 튜토리얼에서는 단일 RTX 4090 카드에 대한 리소스를 사용합니다.

2. 프로젝트 예시

3. 작업 단계

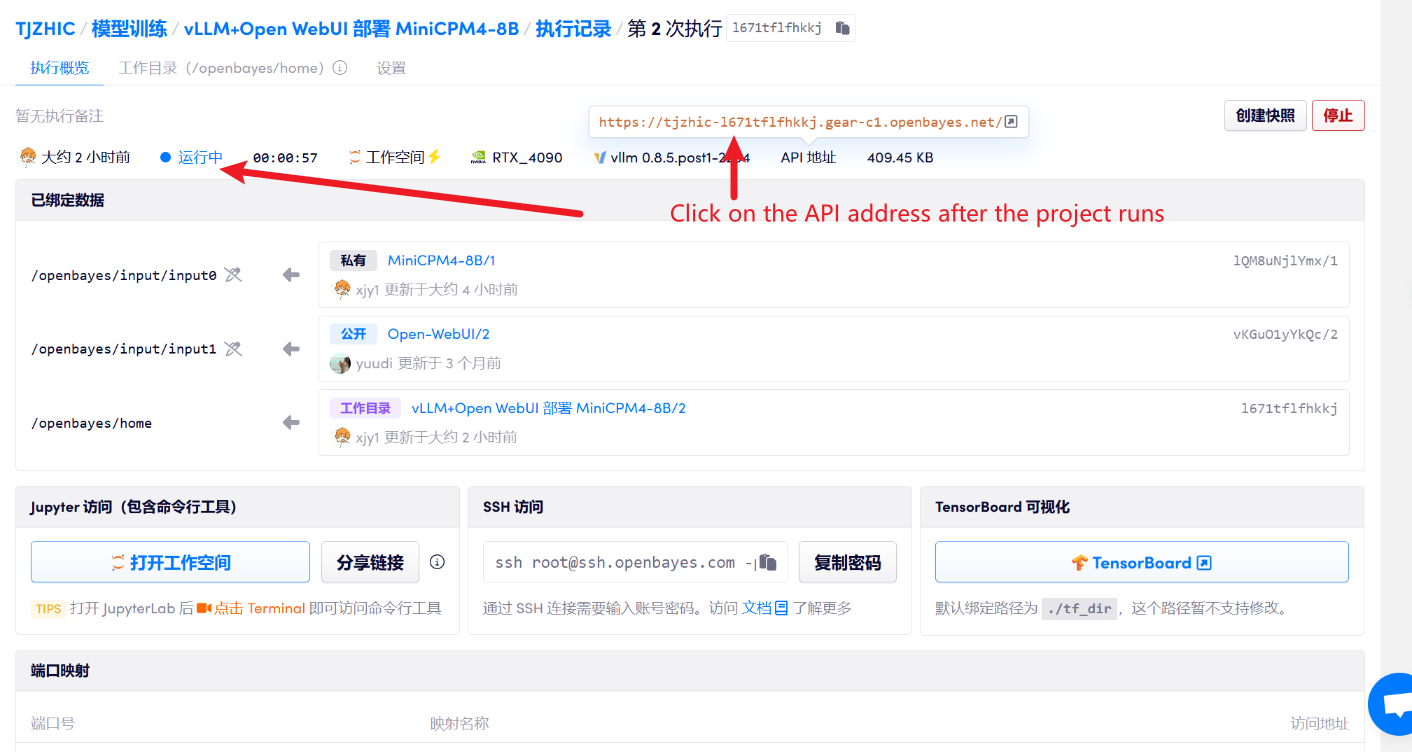

1. 컨테이너 시작 후 API 주소를 클릭하여 웹 인터페이스로 진입합니다.

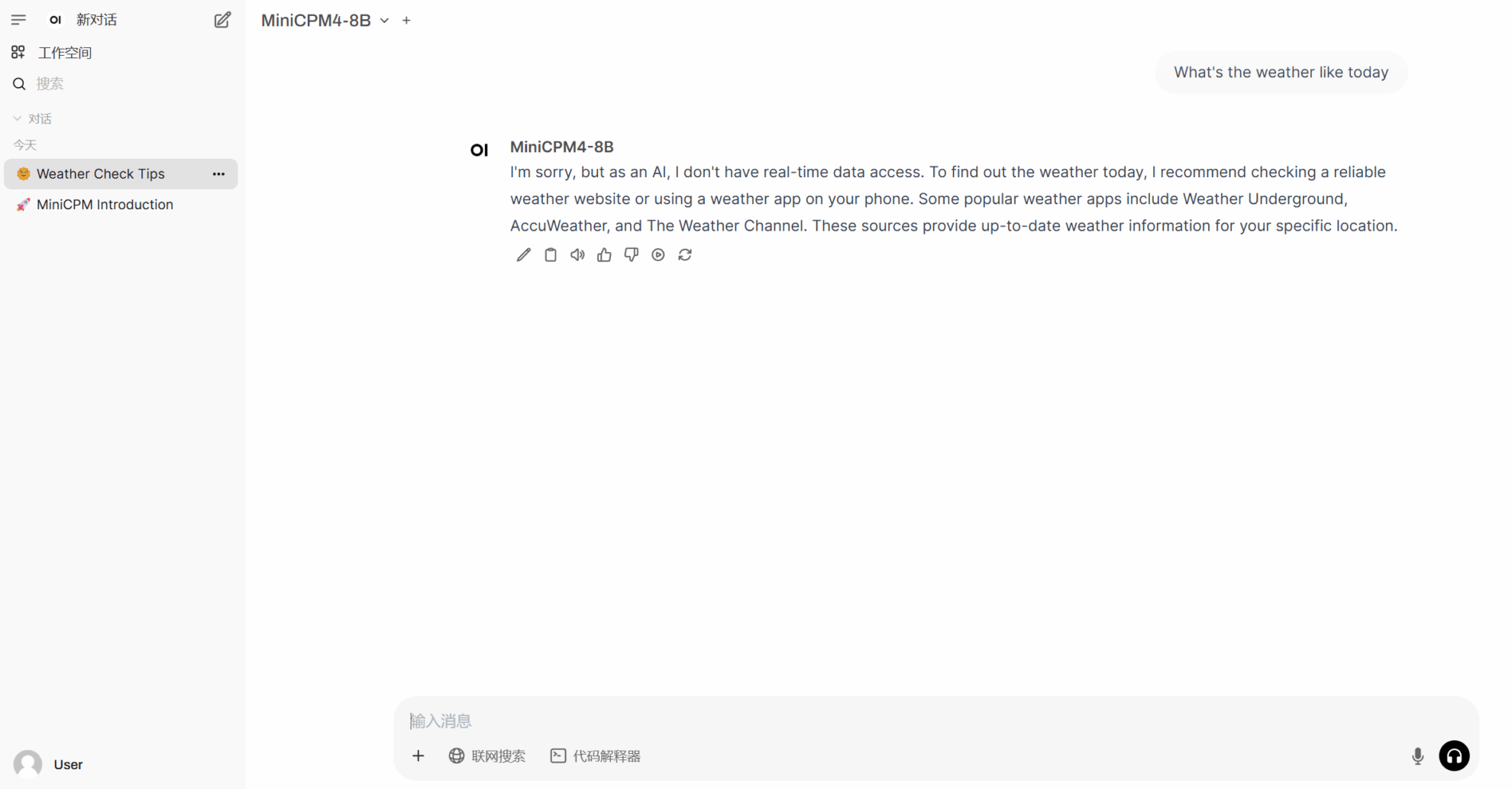

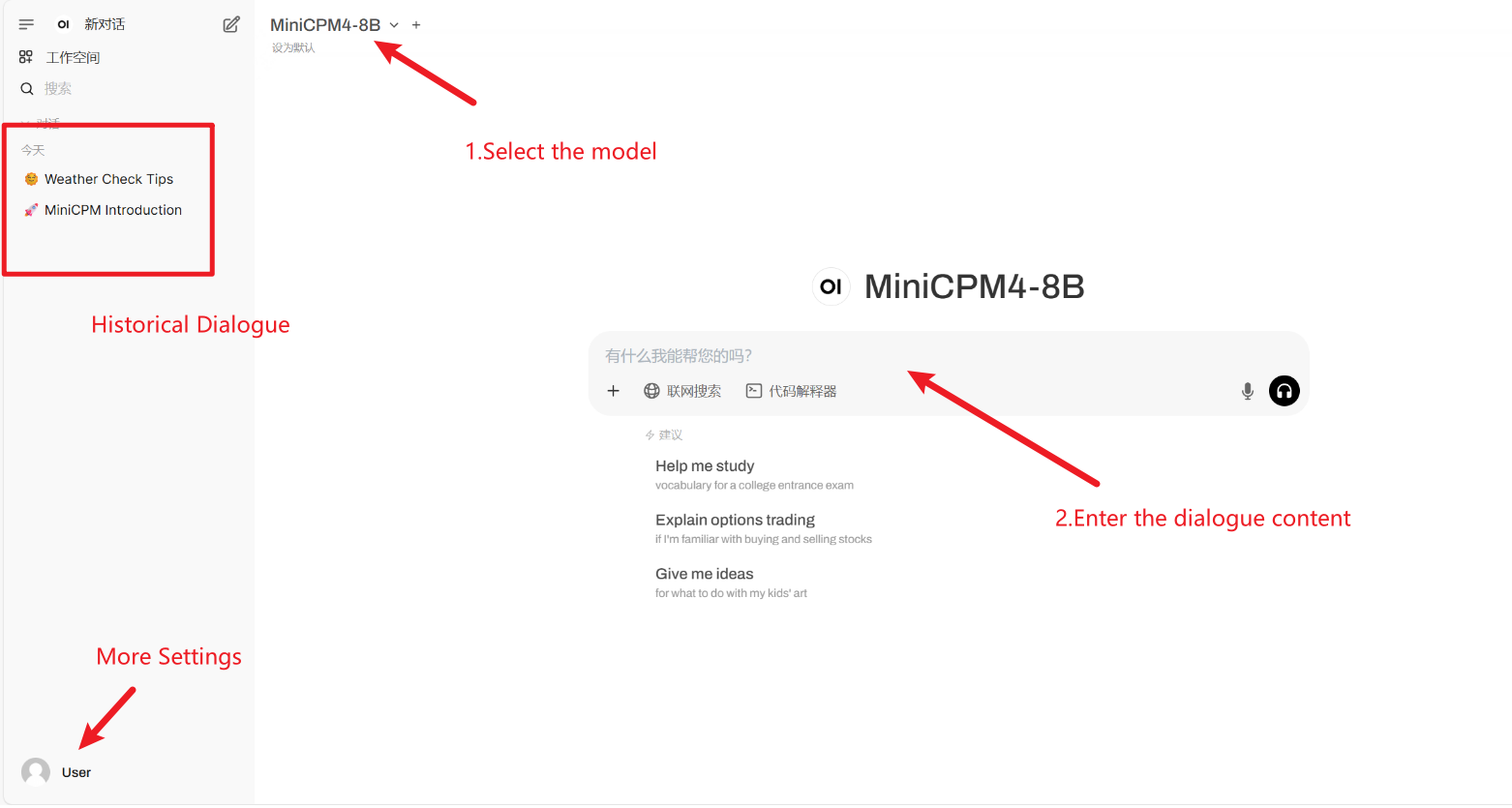

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

"모델"이 표시되지 않으면 모델이 초기화 중임을 의미합니다. 모델이 용량이 크므로 2~3분 정도 기다린 후 페이지를 새로고침해 주세요.

사용 방법

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

Github 사용자에게 감사드립니다 xxxjjjyyy1 이 튜토리얼의 배포. 이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@article{minicpm4,

title={MiniCPM4: Ultra-Efficient LLMs on End Devices},

author={MiniCPM Team},

year={2025}

}

@inproceedings{huminicpm,

title={MiniCPM: Unveiling the Potential of Small Language Models with Scalable Training Strategies},

author={Hu, Shengding and Tu, Yuge and Han, Xu and Cui, Ganqu and He, Chaoqun and Zhao, Weilin and Long, Xiang and Zheng, Zhi and Fang, Yewei and Huang, Yuxiang and others},

booktitle={First Conference on Language Modeling},

year={2024}

}