Command Palette

Search for a command to run...

MMaDA: 다중 모드 대규모 확산 언어 모델

1. 튜토리얼 소개

MMaDA-8B-Base는 프린스턴 대학교, 바이트댄스 시드 팀, 베이징 대학교, 칭화 대학교가 공동으로 개발하여 2025년 5월 23일에 출시한 다중 모드 확산 대규모 언어 모델입니다. 이 모델은 다중 모드 기본 패러다임의 통합 모델로서 확산 아키텍처를 최초로 체계적으로 탐구한 것으로, 텍스트 추론, 다중 모드 이해, 이미지 생성의 심층적인 통합을 통해 교차 모드 작업에 대한 일반 지능 기능을 구현하는 것을 목표로 합니다. 관련 논문 결과는 다음과 같습니다.MMaDA: 다중 모드 대규모 확산 언어 모델".

이 튜토리얼의 컴퓨팅 리소스는 단일 A6000 카드를 사용하며, 이 튜토리얼에 사용된 모델은 MMaDA-8B-Base입니다. 테스트를 위해 텍스트 생성, 다중 모드 이해, 텍스트-이미지 생성의 세 가지 예제가 제공됩니다.

2. 작업 단계

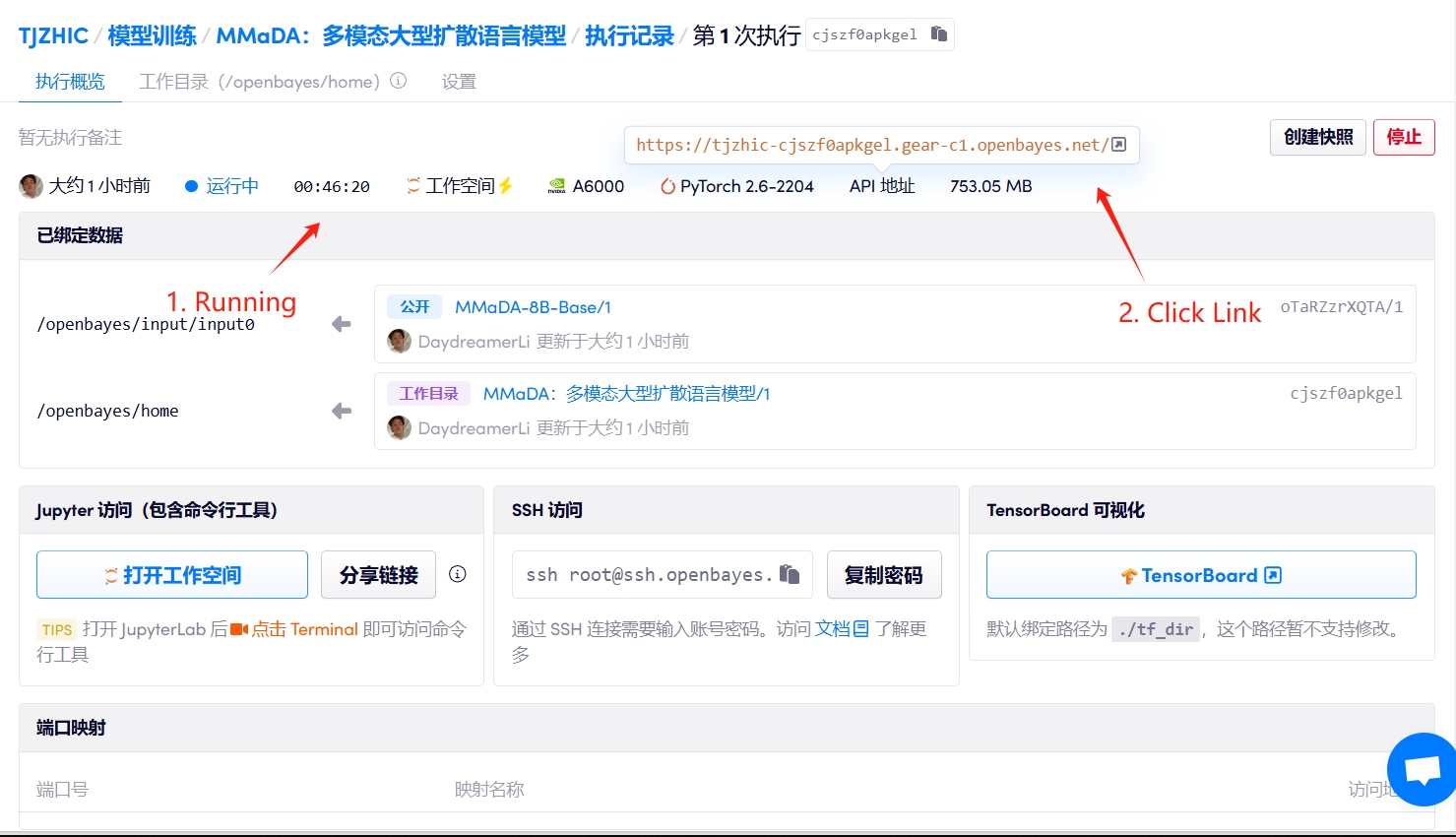

1. 컨테이너를 시작하세요

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 약 2~3분 정도 기다리신 후 페이지를 새로고침해 주시기 바랍니다.

2. 사용 단계

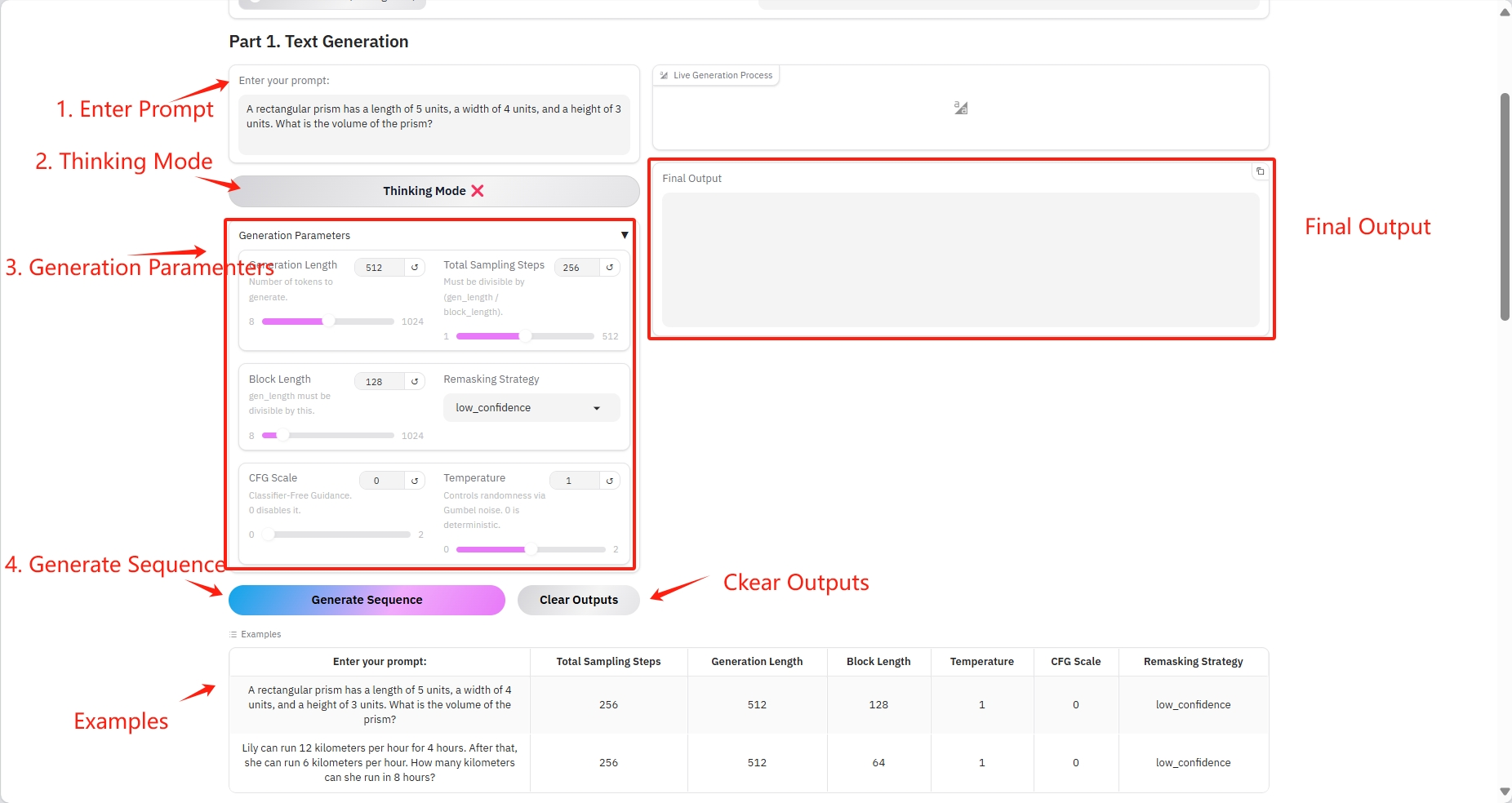

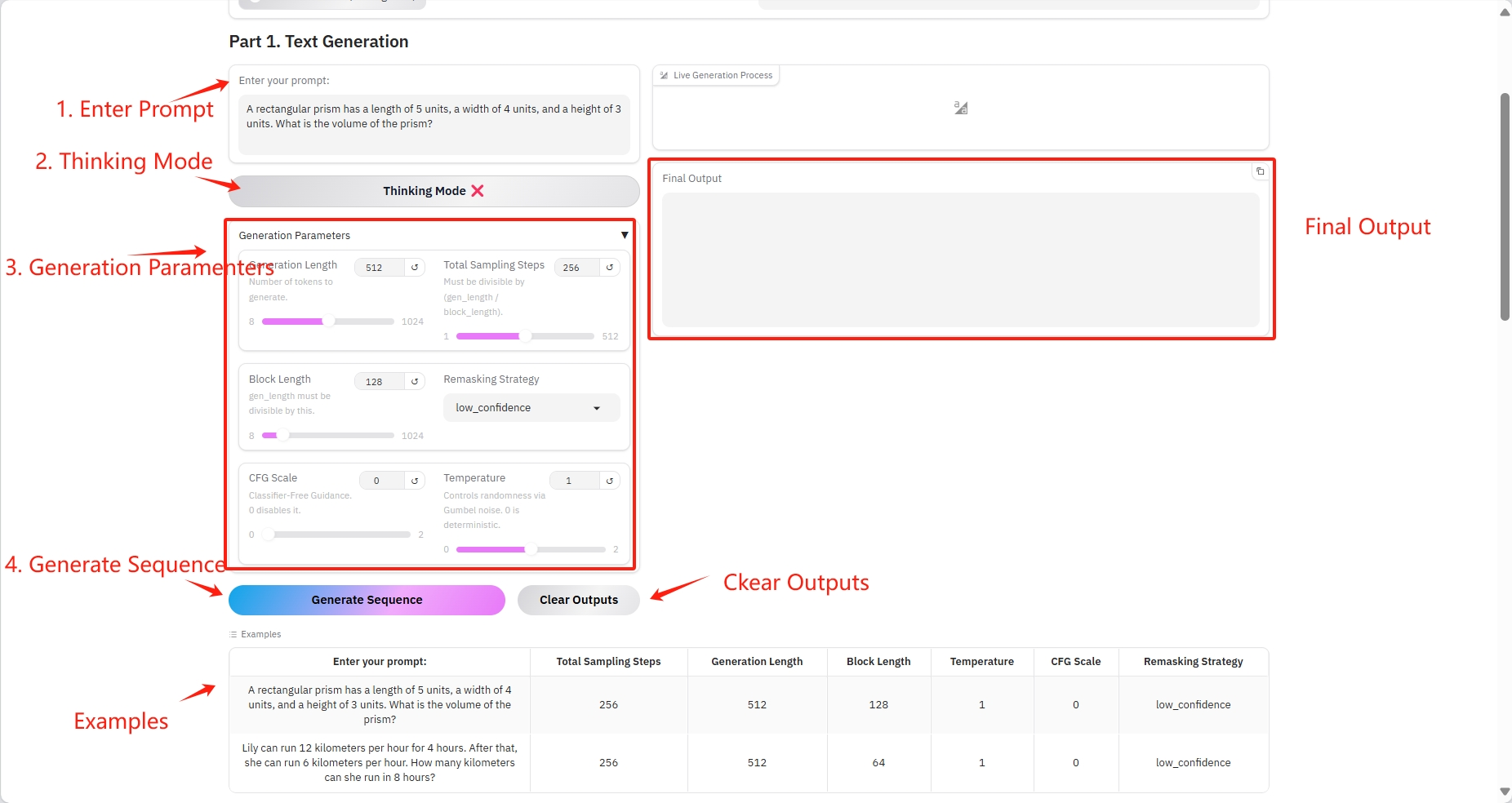

1. 텍스트 생성

구체적인 매개변수:

- 프롬프트: 여기에 텍스트를 입력할 수 있습니다.

- 생성 길이: 생성된 토큰의 수.

- 총 샘플링 단계: (gen_length / block_length)로 나누어야 합니다.

- 블록 길이: gen_length는 이 숫자로 나누어 떨어져야 합니다.

- 리마스킹 전략: 리마스킹 전략.

- CFG 척도: 분류 가이드가 없습니다. 0으로 설정하면 비활성화됩니다.

- 온도: Gumbel 노이즈를 통해 무작위성을 제어합니다. 0은 결정적입니다.

결과 출력

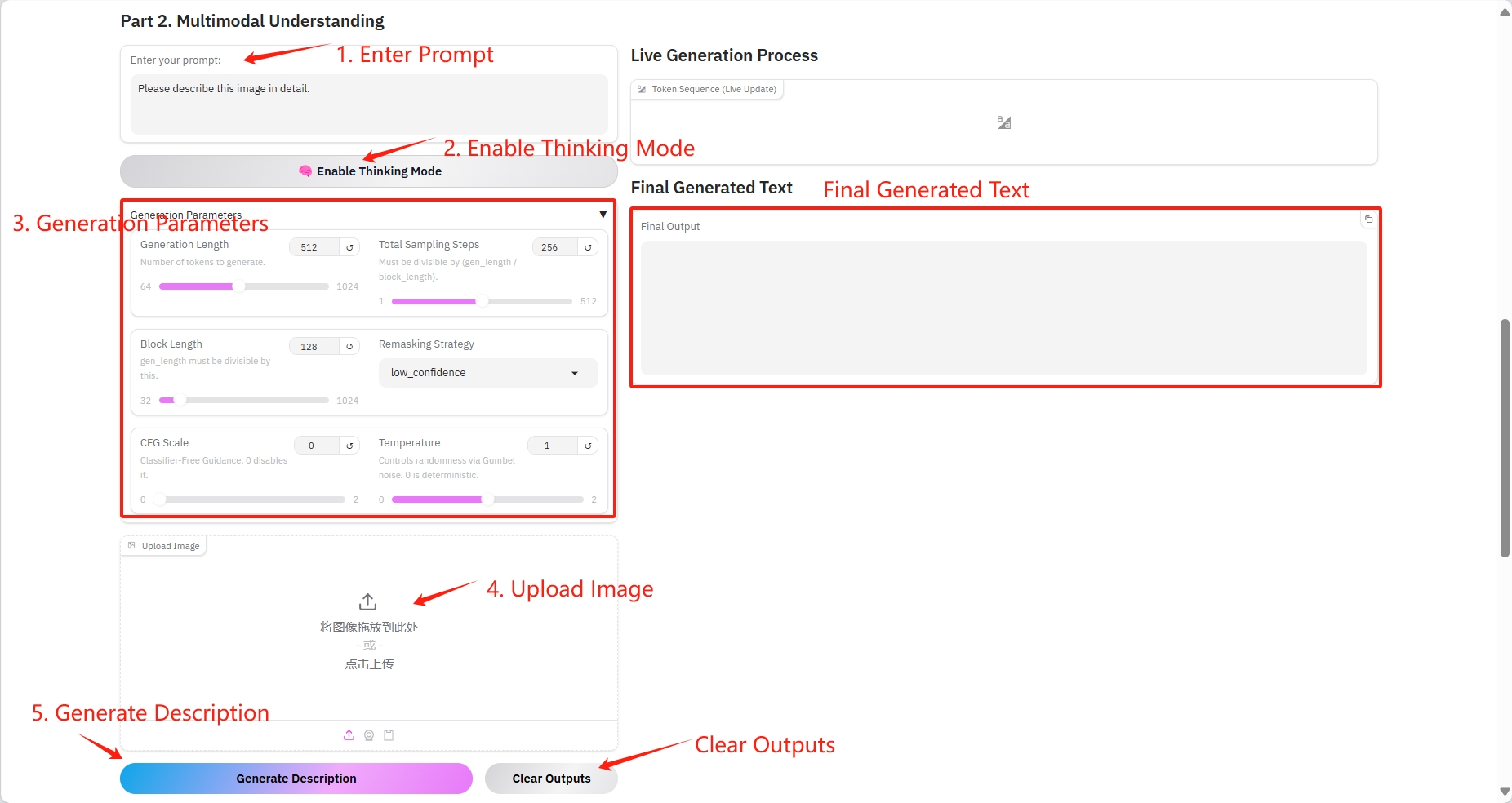

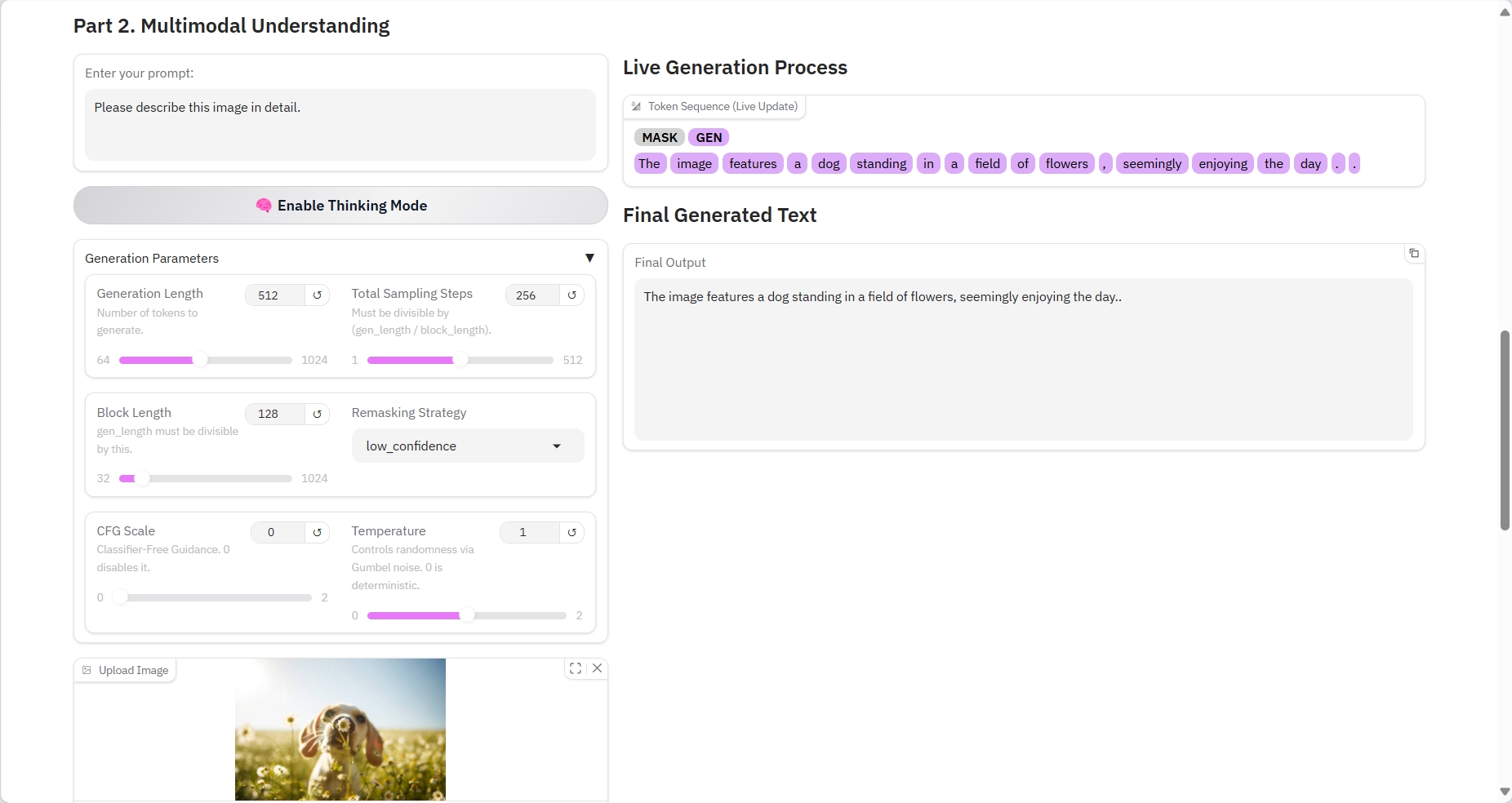

2. 다중 모드 이해

구체적인 매개변수:

- 프롬프트: 여기에 텍스트를 입력할 수 있습니다.

- 생성 길이: 생성된 토큰의 수.

- 총 샘플링 단계: (gen_length / block_length)로 나누어야 합니다.

- 블록 길이: gen_length는 이 숫자로 나누어 떨어져야 합니다.

- 리마스킹 전략: 리마스킹 전략.

- CFG 척도: 분류 가이드가 없습니다. 0으로 설정하면 비활성화됩니다.

- 온도: Gumbel 노이즈를 통해 무작위성을 제어합니다. 0은 결정적입니다.

- 이미지: 그림.

결과 출력

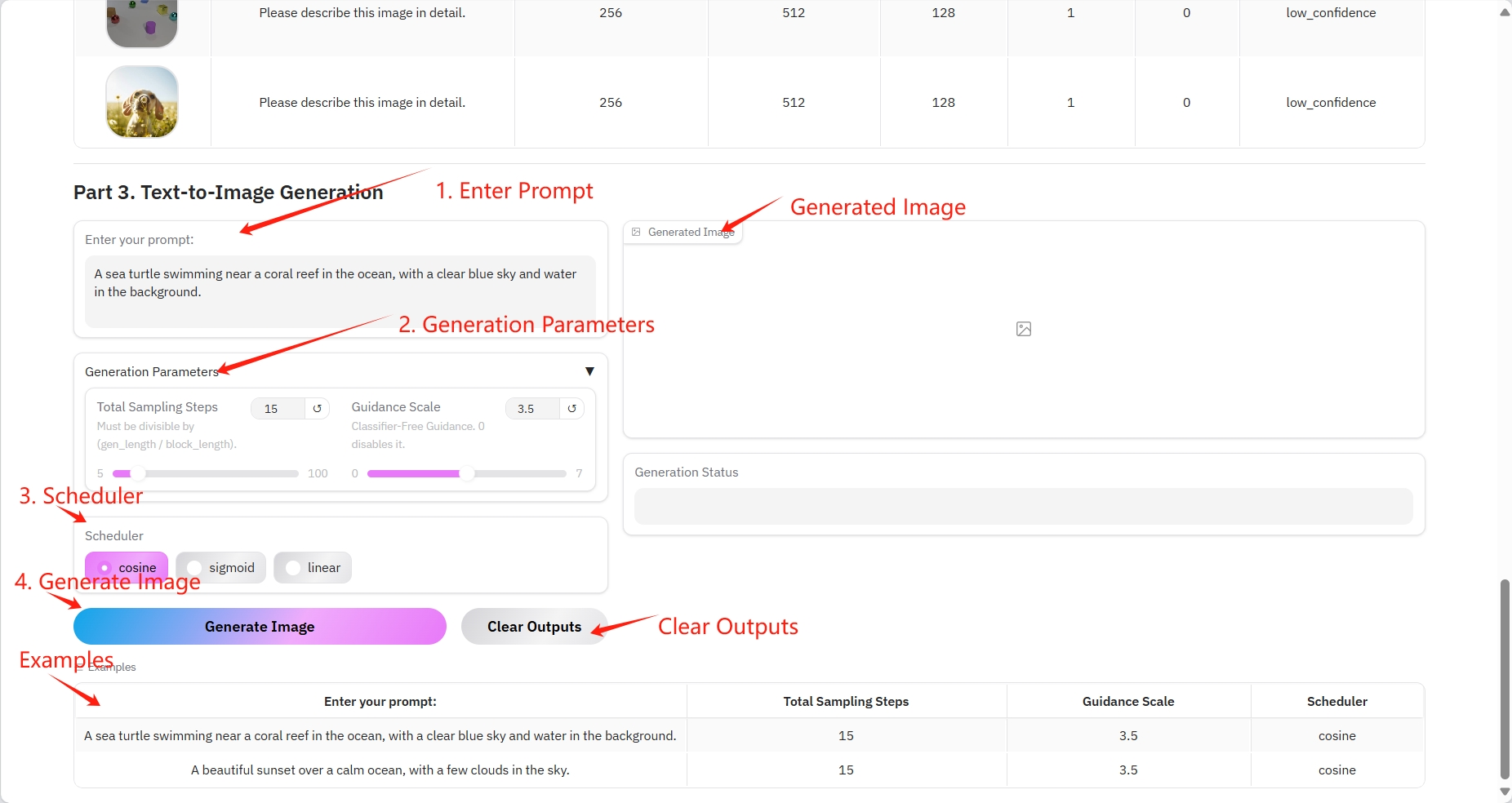

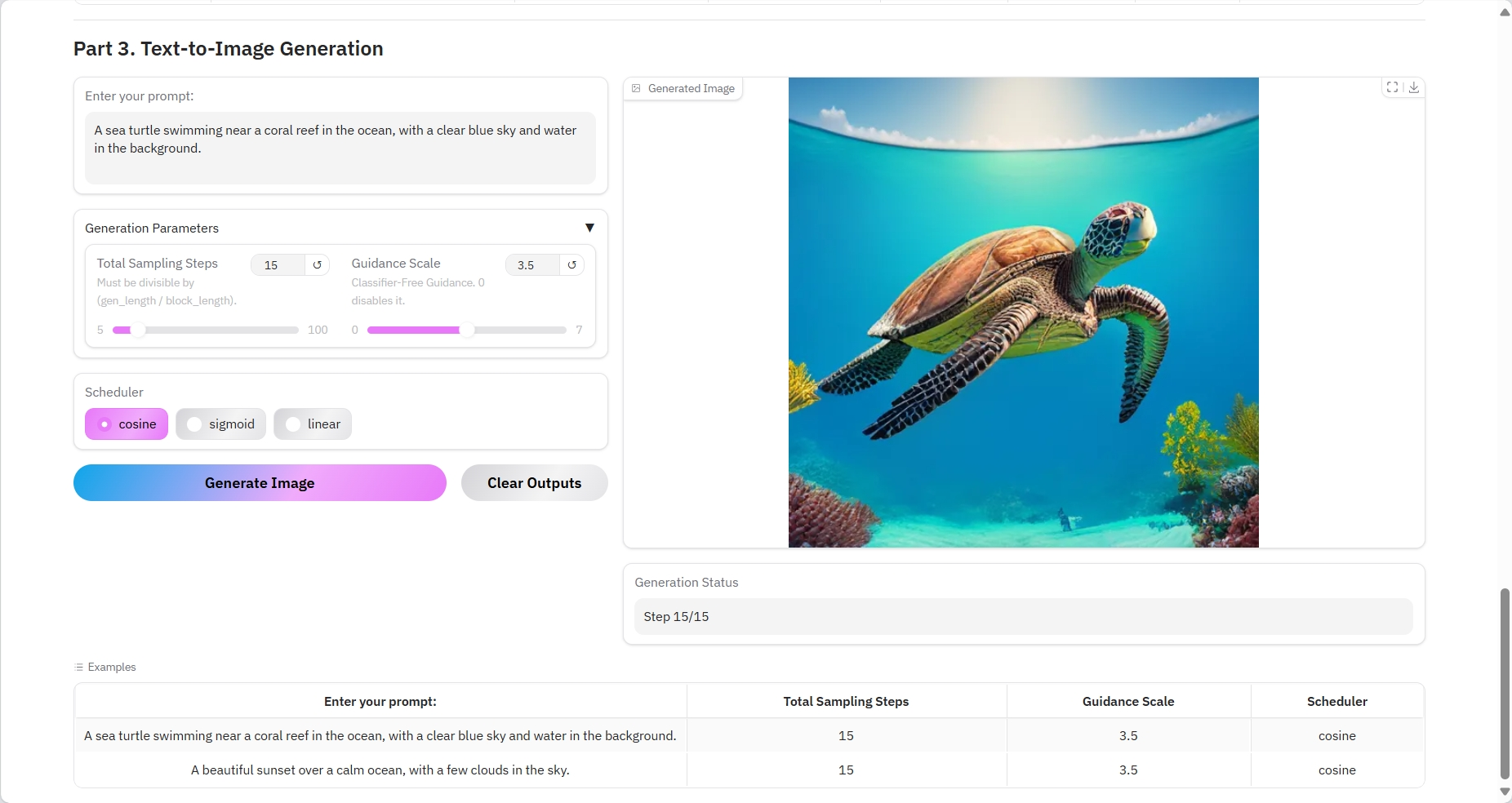

3. 텍스트-이미지 생성

구체적인 매개변수:

- 프롬프트: 여기에 텍스트를 입력할 수 있습니다.

- 총 샘플링 단계: (gen_length / block_length)로 나누어야 합니다.

- 지침 척도: 분류자 지침 없음. 0으로 설정하면 비활성화됨.

- 스케줄러:

- 코사인: 코사인 유사도는 문장 쌍의 유사도를 계산하고 임베딩 벡터를 최적화합니다.

- 시그모이드: 다중 레이블 분류.

- 선형: 선형 레이어는 주의 계산을 위해 이미지 패치 임베딩 벡터를 더 높은 차원으로 매핑합니다.

결과 출력

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

Github 사용자에게 감사드립니다 슈퍼양 이 튜토리얼의 배포. 이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@article{yang2025mmada,

title={MMaDA: Multimodal Large Diffusion Language Models},

author={Yang, Ling and Tian, Ye and Li, Bowen and Zhang, Xinchen and Shen, Ke and Tong, Yunhai and Wang, Mengdi},

journal={arXiv preprint arXiv:2505.15809},

year={2025}

}