Command Palette

Search for a command to run...

vLLM+Open-webUI를 사용하여 Qwen3-30B-A3B 배포

1. 튜토리얼 소개

Qwen3 프로젝트는 2025년 Ali Qwen 팀에 의해 출시되었습니다. 관련 기술 보고서는 다음과 같습니다. "Qwen3: 더 깊이 생각하고, 더 빠르게 행동하세요".

Qwen3는 Qwen 제품군의 최신 세대 대규모 언어 모델로, 포괄적인 고밀도 모델과 전문가 혼합(MoE) 모델을 제공합니다. Qwen3는 풍부한 교육 경험을 바탕으로 추론, 명령 준수, 에이전트 기능 및 다국어 지원 측면에서 획기적인 진전을 이루었습니다. Qwen3의 최신 버전은 다음과 같은 기능을 가지고 있습니다:

- 전체 크기의 고밀도 및 혼합 전문가 모델: 0.6B, 1.7B, 4B, 8B, 14B, 32B 및 30B-A3B, 235B-A22B

- 지원됨사고 패턴(복잡한 논리적 추론, 수학 및 코딩용) 및 비사고 모드(효율적인 일반 대화용)원활한 전환다양한 시나리오에서 최적의 성능을 보장합니다.

- 추론 능력이 크게 향상되어 수학, 코드 생성, 상식적 논리 추론 분야에서 이전의 QwQ(사고 모드) 및 Qwen2.5 교육 모델(비사고 모드)을 능가합니다.

- 인간의 선호도에 탁월하게 부합하며, 창의적 글쓰기, 롤플레잉, 멀티턴 대화, 명령 수행에 탁월하여 보다 자연스럽고 매력적이며 몰입감 넘치는 대화 경험을 제공합니다.

- 지능형 에이전트 기능에 탁월하고, 사고 모드와 비사고 모드 모두에서 외부 도구를 정확하게 통합할 수 있으며, 복잡한 에이전트 기반 작업에서 오픈 소스 모델을 선도합니다.

- 100개 이상의 언어와 방언을 지원하고, 강력한 다국어 이해, 추론, 명령 수행 및 생성 기능을 갖추고 있습니다.

이 튜토리얼에서는 듀얼 SIM A6000의 리소스를 사용합니다.

👉 이 프로젝트는 다음의 모델을 제공합니다.

- Qwen3-30B-A3B 모델

2. 작업 단계

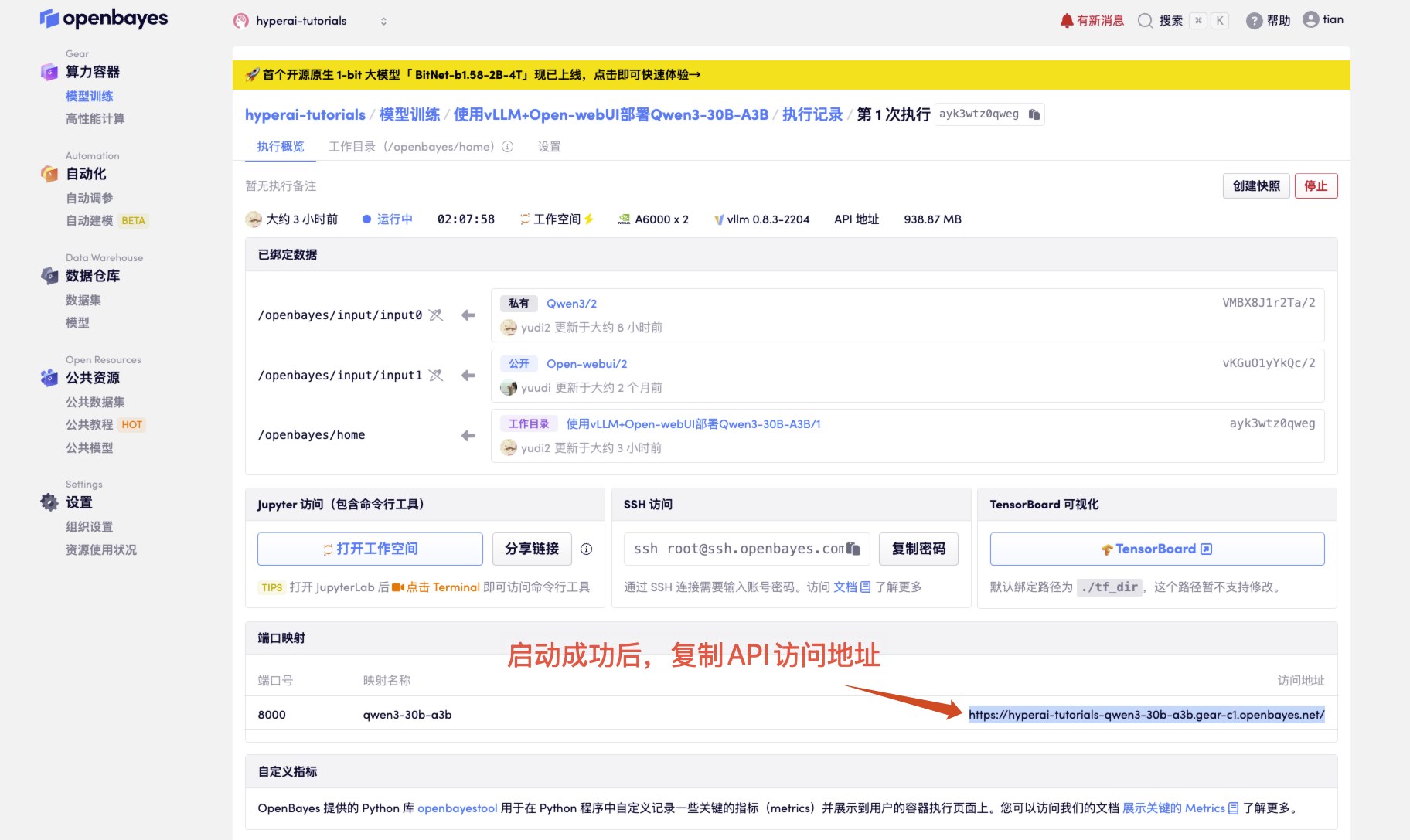

- 컨테이너를 시작한 후 API 주소를 클릭하여 웹 인터페이스로 들어갑니다.

"모델"이 표시되지 않으면 모델이 초기화되고 있음을 의미합니다. 모델이 크기 때문에 1~2분 정도 기다리신 후 페이지를 새로고침해 주세요.

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

사용 방법

3. OpenAI API 호출 가이드

다음은 API 호출 방법에 대한 최적화된 설명으로, 구조를 더 명확하게 하고 실제적인 세부 정보를 추가했습니다.

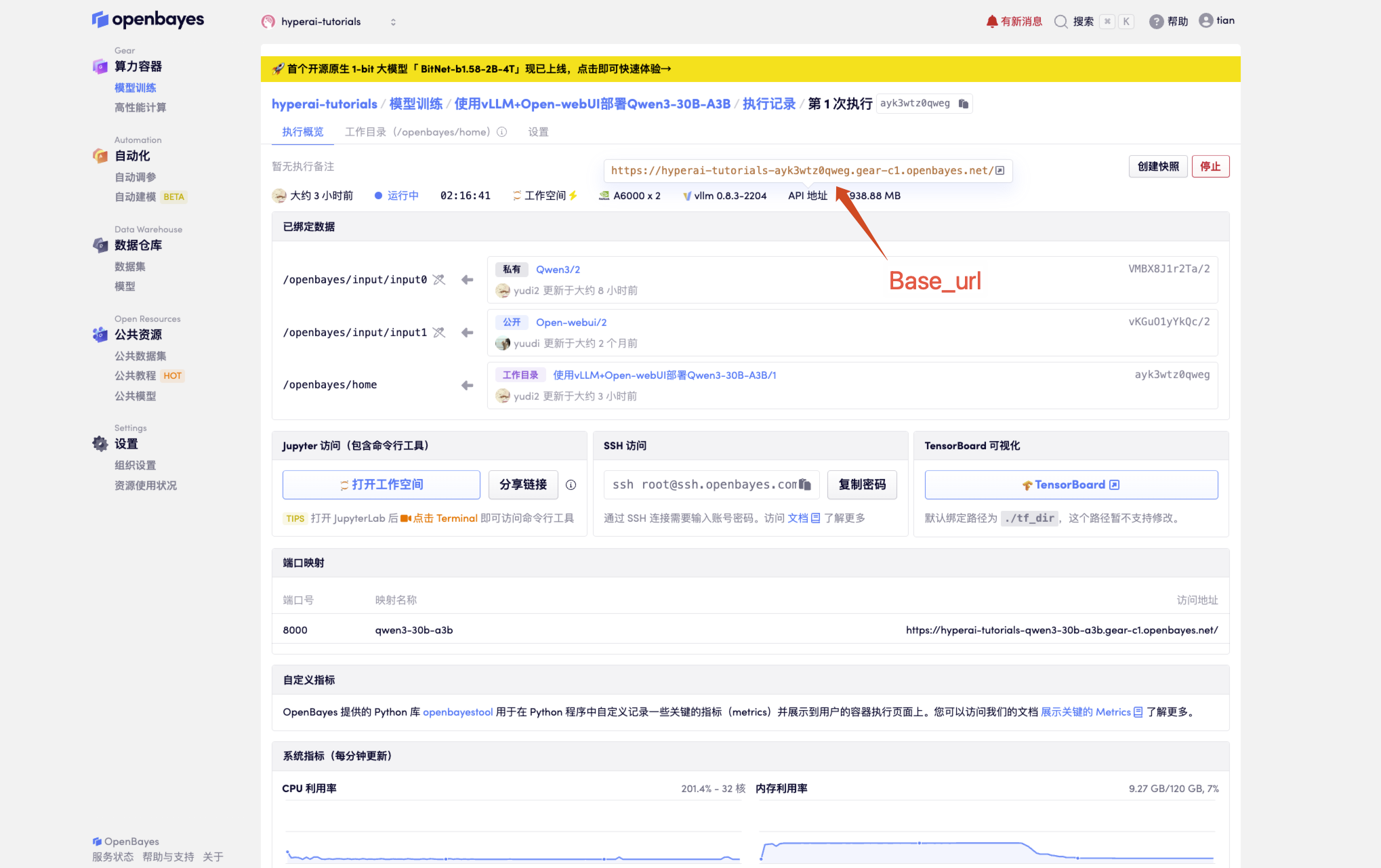

1. 기본 구성 가져오기

# 必要参数配置

BASE_URL = "<API 地址>/v1" # 生产环境

MODEL_NAME = "Qwen3-30B-A3B" # 默认模型名称

API_KEY = "Empty" # 未设置 API_KEY

API 주소를 받으세요

2. 다양한 호출 방법

2.1 네이티브 Python 호출

import openai

# 创建 OpenAI 客户端实例

client = openai.OpenAI(

api_key=API_KEY, # 请替换为你的实际 API Key

base_url=BASE_URL # 替换为你的实际 base_url

)

# 发送聊天消息

response = client.chat.completions.create(

model=MODEL_NAME,

messages=[

{"role": "user", "content": "你好!"}

],

temperature=0.7,

)

# 输出回复内容

print(response.choices[0].message.content)

# 方法 2:requests 库(更灵活)

import requests

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

data = {

"model": MODEL_NAME,

"messages": [{"role": "user", "content": "你好!"}]

}

response = requests.post(f"{BASE_URL}/chat/completions", headers=headers, json=data)

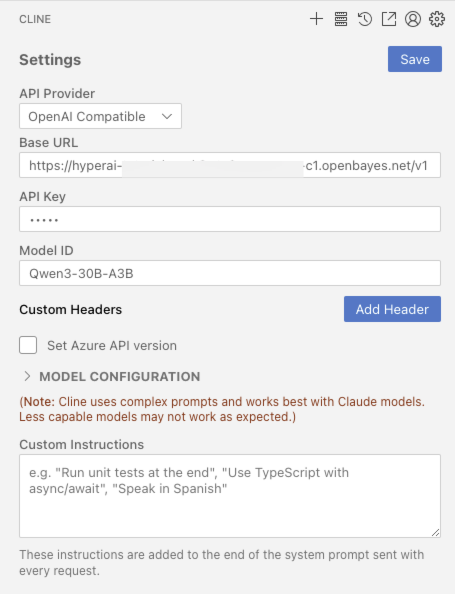

2.2 개발 도구 통합

VScode가 정식으로 설치되었다면 CLINE 플러그인

2.3 cURL 호출

curl <BASE_URL>/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": <MODEL_NAME>,

"messages": [{"role": "user", "content": "你好!"}]

}'

교류 및 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

고마워하는 ZV-류 이 튜토리얼 제작을 위한 프로젝트 참조 정보는 다음과 같습니다.

@misc{glm2024chatglm,

title={ChatGLM: A Family of Large Language Models from GLM-130B to GLM-4 All Tools},

author={Team GLM and Aohan Zeng and Bin Xu and Bowen Wang and Chenhui Zhang and Da Yin and Diego Rojas and Guanyu Feng and Hanlin Zhao and Hanyu Lai and Hao Yu and Hongning Wang and Jiadai Sun and Jiajie Zhang and Jiale Cheng and Jiayi Gui and Jie Tang and Jing Zhang and Juanzi Li and Lei Zhao and Lindong Wu and Lucen Zhong and Mingdao Liu and Minlie Huang and Peng Zhang and Qinkai Zheng and Rui Lu and Shuaiqi Duan and Shudan Zhang and Shulin Cao and Shuxun Yang and Weng Lam Tam and Wenyi Zhao and Xiao Liu and Xiao Xia and Xiaohan Zhang and Xiaotao Gu and Xin Lv and Xinghan Liu and Xinyi Liu and Xinyue Yang and Xixuan Song and Xunkai Zhang and Yifan An and Yifan Xu and Yilin Niu and Yuantao Yang and Yueyan Li and Yushi Bai and Yuxiao Dong and Zehan Qi and Zhaoyu Wang and Zhen Yang and Zhengxiao Du and Zhenyu Hou and Zihan Wang},

year={2024},

eprint={2406.12793},

archivePrefix={arXiv},

primaryClass={id='cs.CL' full_name='Computation and Language' is_active=True alt_name='cmp-lg' in_archive='cs' is_general=False description='Covers natural language processing. Roughly includes material in ACM Subject Class I.2.7. Note that work on artificial languages (programming languages, logics, formal systems) that does not explicitly address natural-language issues broadly construed (natural-language processing, computational linguistics, speech, text retrieval, etc.) is not appropriate for this area.'}

}