Command Palette

Search for a command to run...

PixelFlow: 픽셀 공간 이미지 생성 솔루션

1. 튜토리얼 소개

PixelFlow 프로젝트는 2025년 4월 홍콩대학교의 Adobe 팀이 발표한 AI 이미지 생성 모델입니다. 이는 주요 잠재 공간 모델과는 대조적으로 원래 픽셀 공간에서 직접 작동하는 일련의 이미지 생성 모델입니다. 관련 논문 결과는 다음과 같습니다.PixelFlow: 흐름을 활용한 픽셀 공간 생성 모델".

이 접근 방식은 사전 훈련된 변형 자동 인코더(VAE)의 필요성을 없애고 전체 모델을 종단 간 훈련 가능하게 만들어 이미지 생성 프로세스를 간소화합니다. PixelFlow는 효율적인 계단식 흐름 모델링을 통해 픽셀 공간에서 저렴한 계산 비용을 달성합니다. 256×256 ImageNet 클래스 조건부 이미지 생성 벤치마크에서 1.98의 FID를 달성했습니다. 텍스트-이미지 변환의 정성적 결과는 PixelFlow가 이미지 품질, 예술성, 의미 제어 측면에서 우수한 성능을 보인다는 것을 보여줍니다. 우리는 이 새로운 패러다임이 차세대 생성적 비전 모델에 영감을 주고 새로운 기회를 열어주기를 바랍니다.

이 튜토리얼에서는 단일 RTX 4090 카드에 대한 리소스를 사용합니다.

👉 이 프로젝트는 다음의 모델을 제공합니다.

- 클래스-이미지: 256×256 ImageNet 클래스 조건부 이미지 생성 벤치마크에서 1.98의 FID를 달성했습니다.

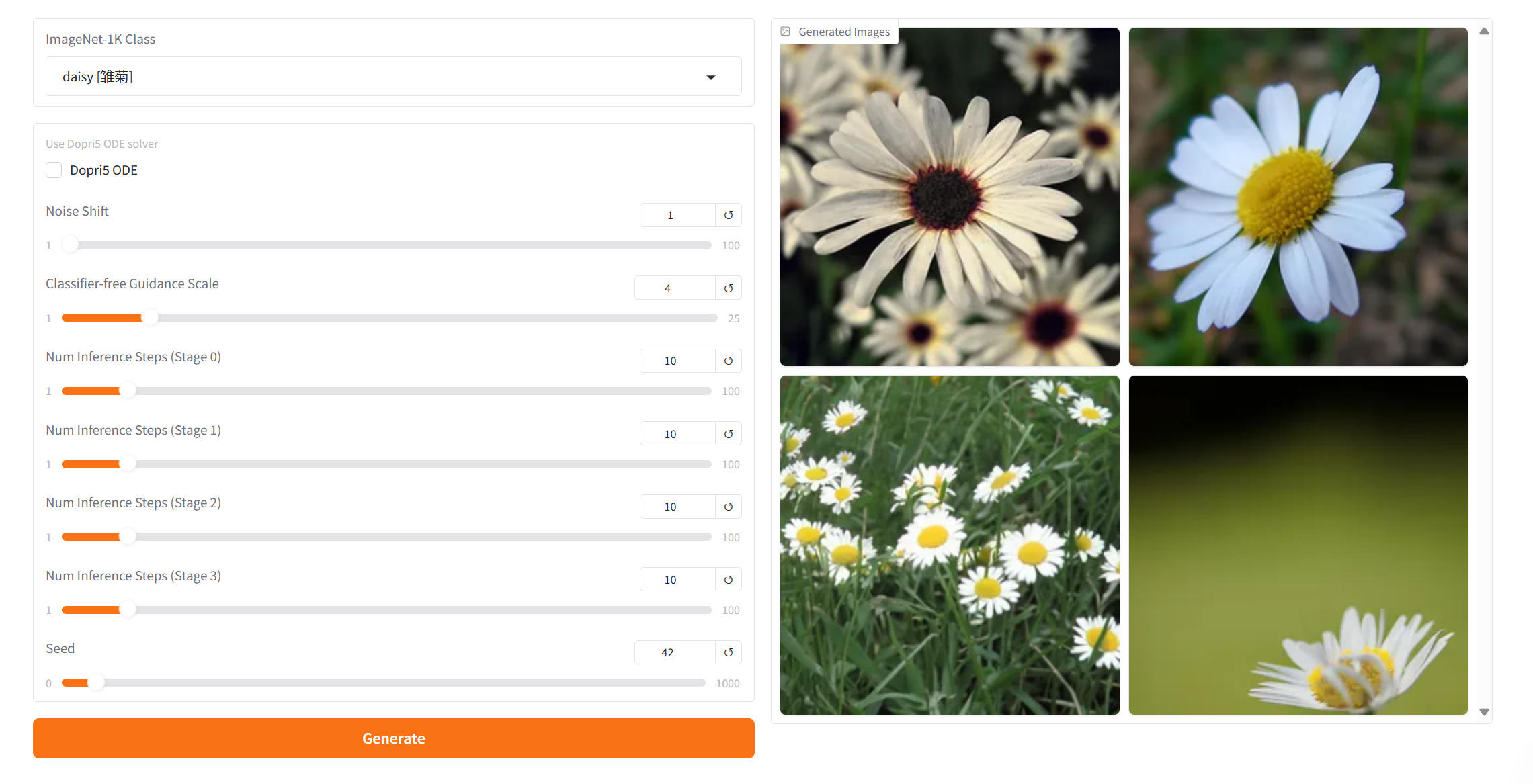

프로젝트 예시

2. 작업 단계

1. 컨테이너 시작 후 API 주소를 클릭하여 웹 인터페이스로 진입합니다.

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 1~2분 정도 기다리신 후 페이지를 새로고침해 주세요.

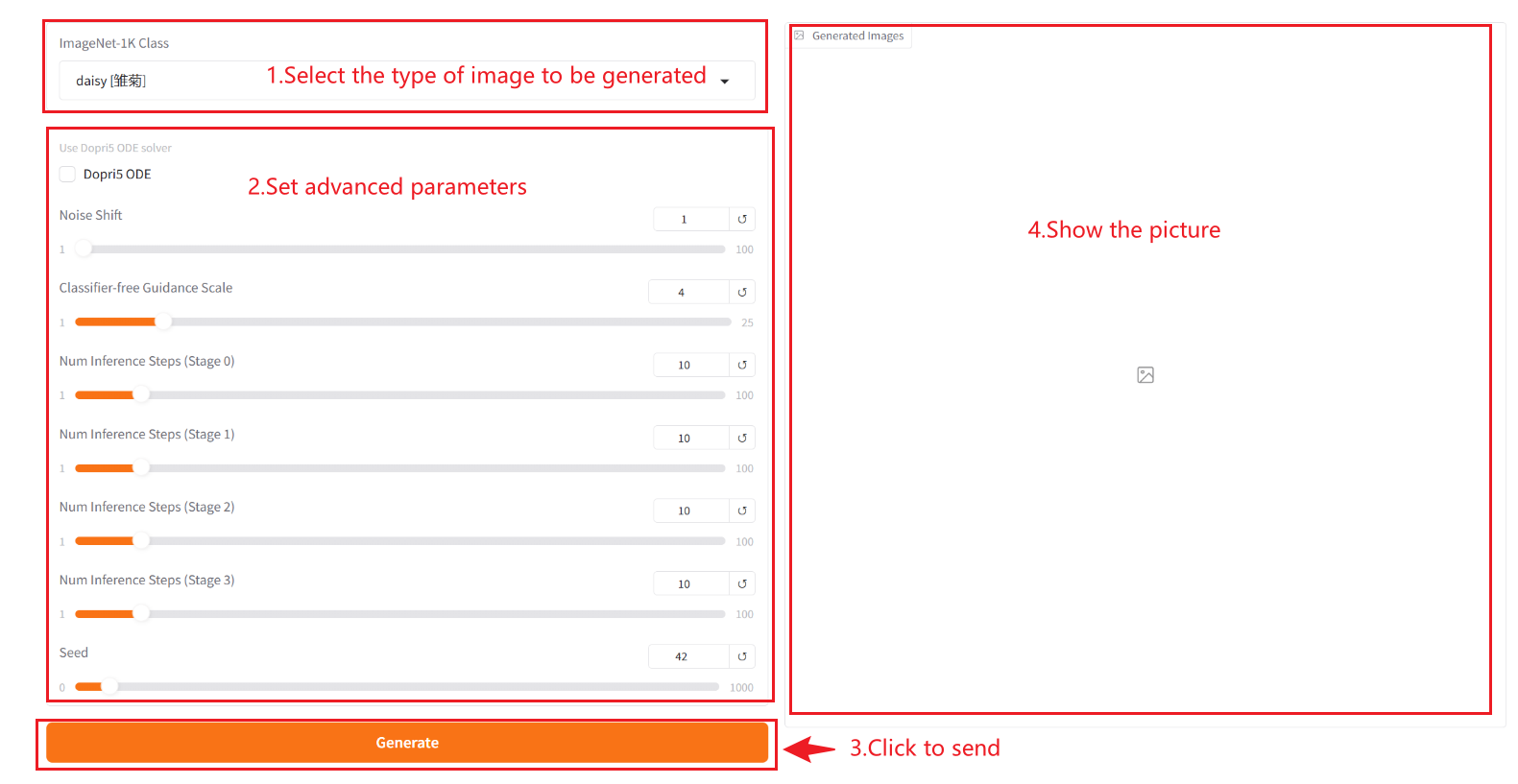

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

❗️중요 사용 팁:

- ImageNet-1k 클래스: 생성된 이미지는 드롭다운 상자에 제공된 카테고리만 선택할 수 있으며 사용자 정의가 불가능합니다.

- 도프리5 ODE: 이는 Dormand-Prince 5차 적응형 스텝 크기 ODE 솔버이며 고품질 생성이 필요할 때(예: 고화질 이미지 생성) 활성화됩니다.

- 노이즈 변화: 생성 과정에서 발생하는 노이즈의 오프셋을 제어합니다. 값이 클수록 노이즈의 강도가 높아져 생성되는 결과가 더 무작위적이고 다양해집니다. 값이 작을수록 노이즈의 간섭이 줄어들어 생성된 결과가 훈련 데이터의 분포에 더 가까워집니다(더 보수적임).

- 분류자 없는 지침 척도: 생성 모델에서 조건부 입력(예: 텍스트나 이미지)이 생성된 결과에 미치는 영향의 정도를 제어하는 데 사용됩니다. 높은 지침 값을 사용하면 생성된 결과가 입력 조건과 더 일치하게 되지만, 낮은 값을 사용하면 더 많은 무작위성이 유지됩니다.

- 숫자 추론 단계 [단계 0]: 모델의 반복 횟수 또는 추론 과정의 단계 수를 나타내며, 모델이 결과를 생성하는 데 사용하는 최적화 단계 수를 나타냅니다. 일반적으로 단계 수가 많을수록 더 정교한 결과가 나오지만 계산 시간은 늘어날 수 있습니다. [스테이지 0]은 생성된 이미지를 나타냅니다. 그 뒤의 숫자에 1을 더하면 장 번호를 나타냅니다. 총 4개의 이미지가 있습니다.

- 씨앗: 생성 과정의 무작위성을 제어하는 데 사용되는 난수 시드입니다. 동일한 Seed 값은 동일한 결과를 생성할 수 있습니다(다른 매개변수가 동일하다는 전제 하에). 이는 결과를 재현하는 데 매우 중요합니다.

사용 방법

교류 및 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

Github 사용자에게 감사드립니다 xxxjjjyyy1 이 튜토리얼 제작을 위한 프로젝트 참조 정보는 다음과 같습니다.

@article{chen2025pixelflow,

title={PixelFlow: Pixel-Space Generative Models with Flow},

author={Chen, Shoufa and Ge, Chongjian and Zhang, Shilong and Sun, Peize and Luo, Ping},

journal={arXiv preprint arXiv:2504.07963},

year={2025}

}