Command Palette

Search for a command to run...

DeepSeek-R1-70B의 원클릭 배포

1. 튜토리얼 소개

DeepSeek-R1-Distill-Llama-70B는 DeepSeek이 2025년에 출시한 오픈소스 대규모 언어 모델로, 매개변수 규모가 최대 700억에 달합니다. Llama3.3-70B-Instruct를 기반으로 학습되었으며, 강화 학습과 증류 기술을 사용하여 추론 성능을 향상시킵니다. 이 모델은 라마 시리즈 모델의 장점을 그대로 이어받았을 뿐만 아니라, 특히 수학, 코드, 논리적 추론 과제에서 이를 기반으로 추론 능력을 더욱 최적화했습니다. DeepSeek 시리즈의 고성능 버전으로, 다양한 벤치마크에서 좋은 성능을 보입니다. 또한, 이 모델은 DeepSeek AI가 제공하는 추론 강화 모델로, 모바일 기기 및 엣지 컴퓨팅, 온라인 추론 서비스 등 다양한 응용 시나리오를 지원하여 응답 속도를 높이고 운영 비용을 절감합니다. 매우 강력한 추론 능력과 의사결정 능력을 가지고 있습니다. 고급 AI 보조, 과학 연구 분석 등의 분야에서 매우 전문적이고 심층적인 분석 결과를 제공할 수 있습니다. 예를 들어, 의학 연구에서 버전 70B는 방대한 양의 의료 데이터를 분석하고 질병 연구에 귀중한 참고 자료를 제공할 수 있습니다.

本教程使用 Ollama + Open WebUI 部署 DeepSeek-R1-Distill-Qwen-70B 作为演示,算力资源采用「单卡 A6000」。

2. 작업 단계

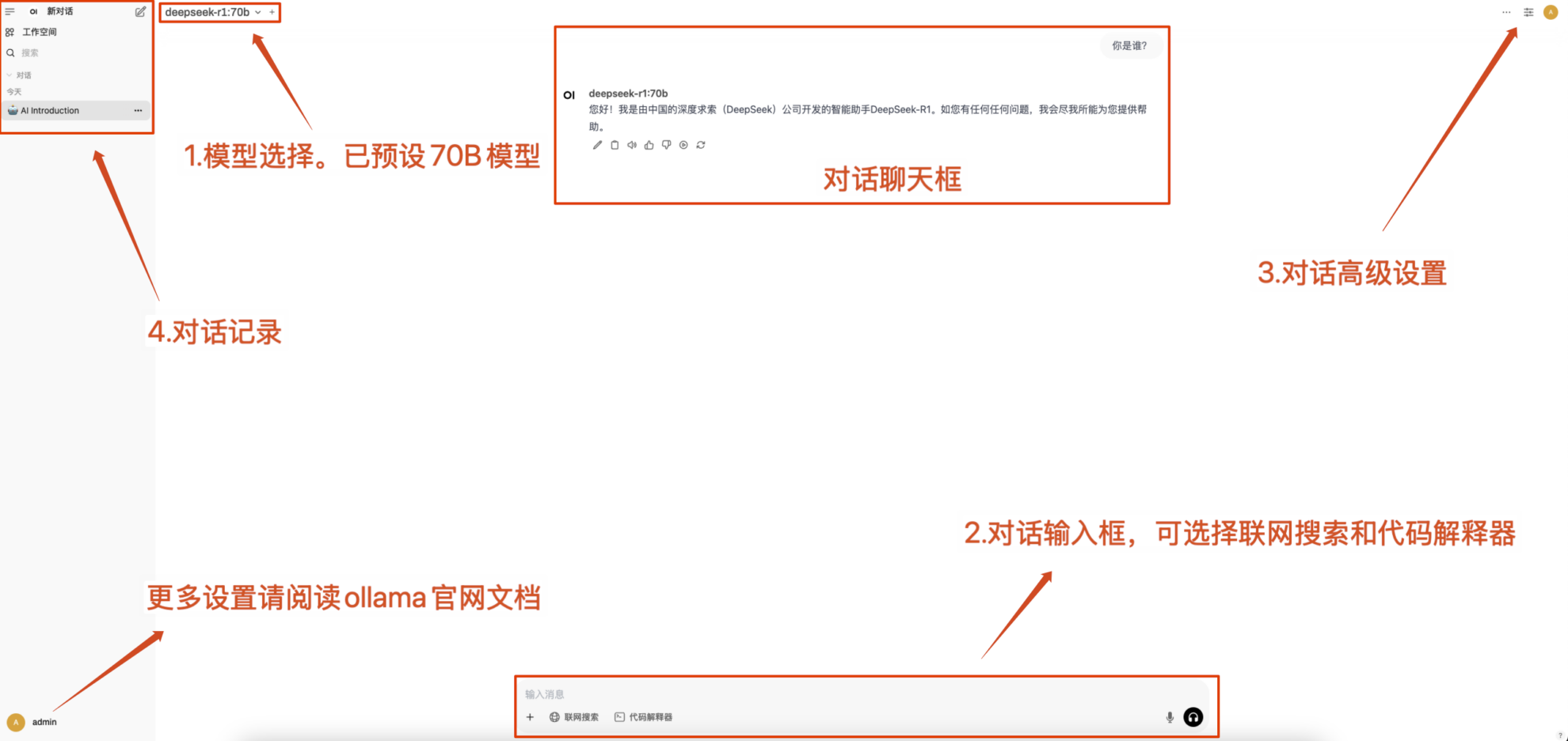

1. 컨테이너를 시작한 후 API 주소를 클릭하여 웹 인터페이스에 접속합니다. ("Bad Gateway"가 표시되면 모델이 초기화 중임을 의미합니다. 모델 용량이 크므로 약 5분 정도 기다린 후 다시 시도해 주세요.) 2. 웹 페이지에 접속하면 모델과 대화를 시작할 수 있습니다!

2. 웹페이지에 접속 후 모델과 대화를 시작할 수 있습니다.

일반적인 대화 설정

1. 온도

- 일반적으로 다음 범위 내에서 출력의 무작위성을 제어합니다. 0.0-2.0 사이.

- 낮은 값(예: 0.1): 더 확실하고, 흔한 단어에 편향되어 있습니다.

- 높은 값(예: 1.5): 더 무작위적이고 잠재적으로 더 창의적이지만 불규칙한 콘텐츠입니다.

2. Top-k 샘플링

- 오직에서 가장 높은 확률을 갖는 k 확률이 낮은 단어를 제외하고 단어 단위로 샘플링합니다.

- k는 작습니다(예: 10): 확실성은 더 크고 무작위성은 더 적습니다.

- k가 큽니다(예: 50): 다양성이 더 커지고 혁신도 더 커집니다.

3. Top-p 샘플링(핵 샘플링, Top-p 샘플링)

- 선택하다누적 확률이 p에 도달하는 단어 집합, k 값은 고정되어 있지 않습니다.

- 낮은 값(예: 0.3): 확실성은 더 크고 무작위성은 더 적습니다.

- 높은 값(예: 0.9): 다양성이 높아지고 유창성이 향상되었습니다.

4. 반복 페널티

- 일반적으로 텍스트 반복을 제어합니다. 1.0-2.0 사이.

- 높은 값(예: 1.5): 반복을 줄이고 가독성을 향상시킵니다.

- 낮은 값(예: 1.0): 페널티는 없지만, 모델이 단어와 문장을 반복할 수 있습니다.

5. 최대 토큰(최대 생성 길이)

- 제한 모델생성된 최대 토큰 수, 지나치게 긴 출력을 피하세요.

- 일반적인 범위:50-4096(특정 모델에 따라 다름).

교류 및 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓