Command Palette

Search for a command to run...

Puke 화학 대형 모델 ChemLLM-7B-chat 데모의 원클릭 배포

튜토리얼 소개

이 튜토리얼은 ChemLM-7B-Chat의 원클릭 배포 데모입니다. 컨테이너를 복제하고 시작하고, 생성된 API 주소를 직접 복사하기만 하면 모델의 추론을 경험할 수 있습니다.

ChemLLM-7B-Chat은 상하이 인공지능 연구소(Shanghai AI Laboratory)가 2024년에 오픈 소스로 공개한 화학 및 분자 과학을 위한 최초의 오픈 소스 대규모 언어 모델인 "Puke Chemistry(ChemLLM)"로, InternLM-2를 기반으로 구축되었습니다. 관련 논문 결과는 다음과 같습니다.ChemLM: 화학 대규모 언어 모델".

슈성·푸위 2.0 기반 모델의 우수한 다국어 기능을 바탕으로, 푸커화학은 전문적인 화학 지식 훈련을 거쳐 화학 분야에서 우수한 중국어-영어 번역 기능을 갖추고 있습니다. 이를 통해 화학 연구자들이 언어 장벽을 극복하고 화학 문헌의 특수 용어를 정확하게 번역하며 더 많은 화학 지식을 습득할 수 있습니다.

또한 연구팀은 또한 오픈소스화 ChemData700K 데이터 세트, ChemPref-10K 데이터 세트의 중국어 및 영어 버전, C-MHChem 데이터 세트그리고 ChemBench4K 화학 능력 평가 벤치마크 데이터 세트.

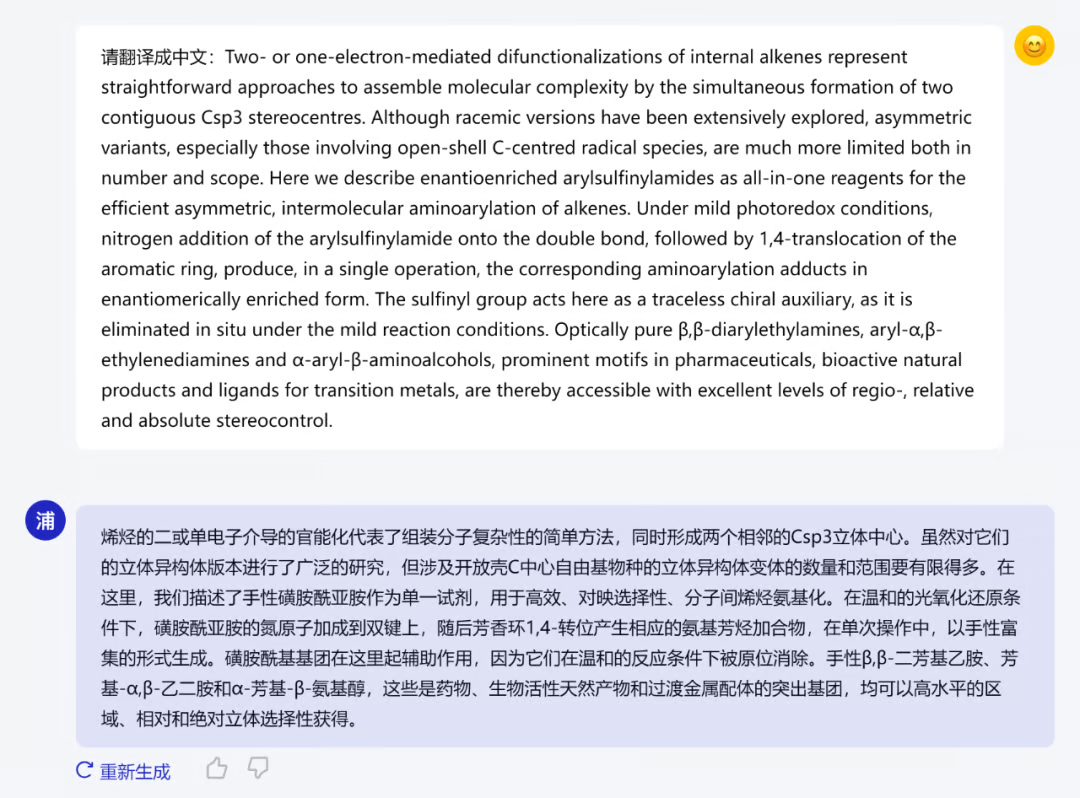

아래 그림은 Pu Ke Chemistry에서 번역하여 2024년 1월 16일 Nature Chemistry 저널에 게재한 논문의 초록을 보여줍니다.

푸케화학은 전문적인 화학 지식 교육 외에도 중고등학교 지식 학습도 실시합니다. 중학교와 고등학교 화학 문제에 답할 때, 답을 말할 뿐만 아니라 구체적인 설명도 할 수 있습니다. 다음 그림은 예를 보여줍니다.

추론 단계 배포

이 튜토리얼에서는 모델과 환경을 배포했습니다. 튜토리얼의 설명에 따라 추론 대화를 위해 대형 모델을 직접 사용할 수 있습니다. 구체적인 튜토리얼은 다음과 같습니다.

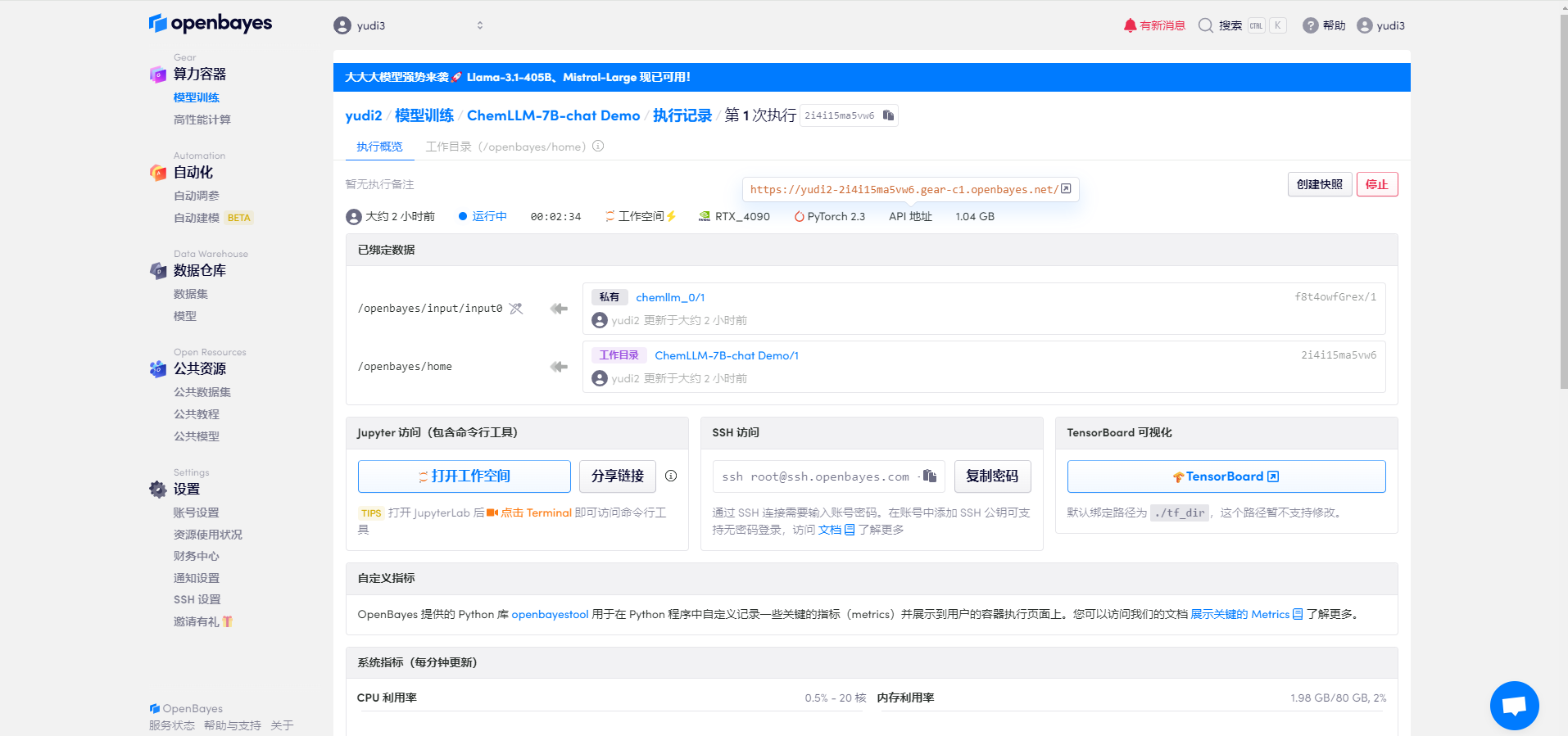

1. 모델 구성

리소스가 구성된 후 컨테이너를 시작하고 API 주소의 링크를 클릭하여 데모 인터페이스로 들어갑니다(컨테이너가 성공적으로 시작된 후 모델을 로드해야 하므로 웹 페이지를 여는 데 약 30초가 걸립니다)

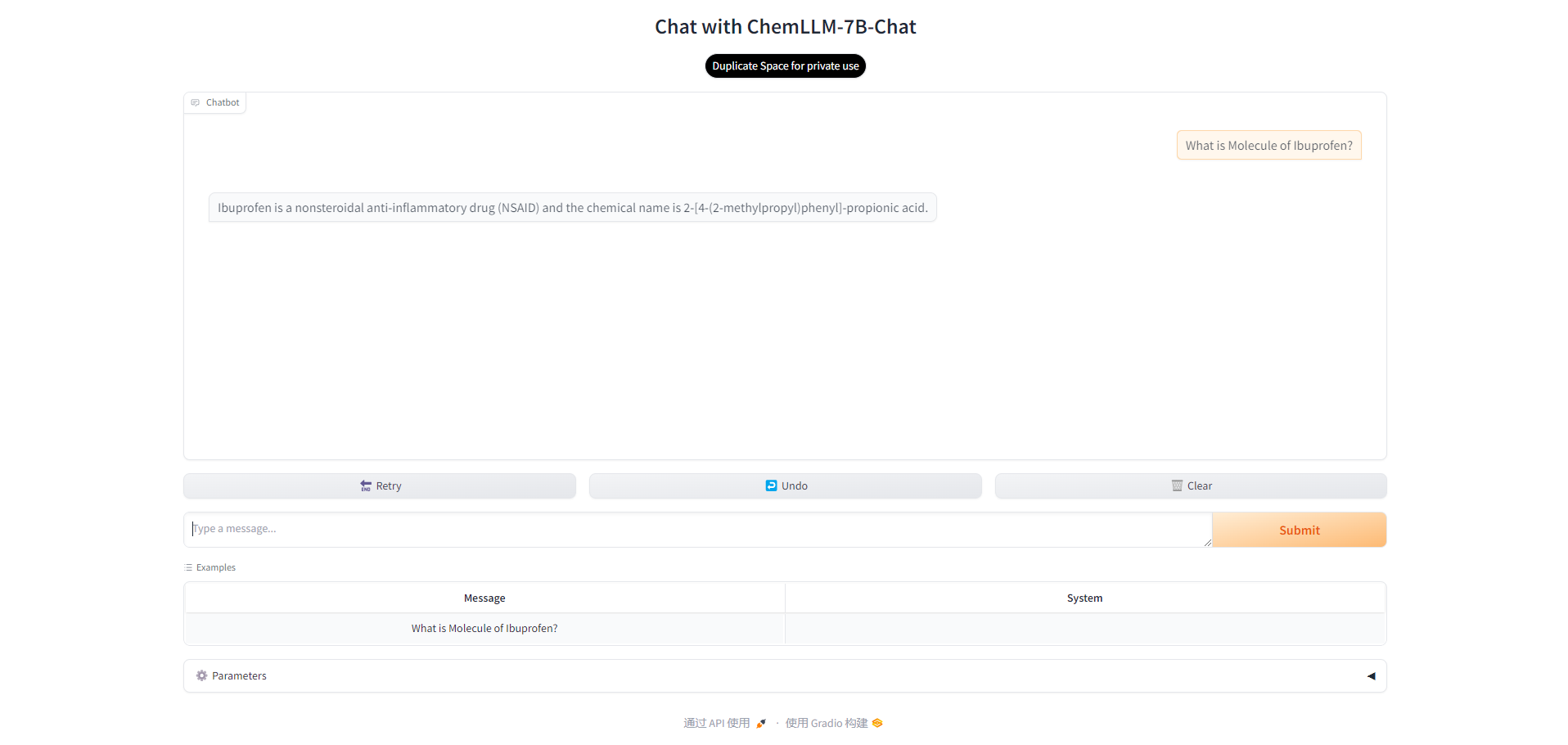

2. 인터페이스를 엽니다

잠시 기다린 후 모델 인터페이스를 보고 모델과 통신을 시작할 수 있습니다. 샘플 질문이나 직접 질문을 입력할 수 있습니다.

3. 파라미터 조정

모델에는 조정 가능한 매개변수가 여러 개 있습니다. 안에:

- 온도: 생성된 텍스트의 무작위성을 조정하는 데 사용됩니다. 값이 낮을수록 모델은 확률이 가장 높은 단어를 선택할 가능성이 높아지며, 결과적으로 더 예측 가능한 텍스트가 생성됩니다. 값이 높을수록 모델은 낮은 확률로 단어를 탐색할 가능성이 높아지며, 그 결과 텍스트는 더 다양해지지만 오류도 더 많아질 가능성이 있습니다.

- 최대 새 토큰: 모델이 텍스트를 생성할 때 생성할 수 있는 최대 단어 수를 지정합니다. 생성되는 단어의 수를 제한하면 출력 길이를 제어하고 너무 길거나 짧은 텍스트가 생성되는 것을 방지할 수 있습니다.

귀하의 요구 사항에 맞게 매개변수를 조정할 수 있습니다.