WALT: 타임랩스 영상에서 시각적으로 학습하는 2차원 비모달 표현

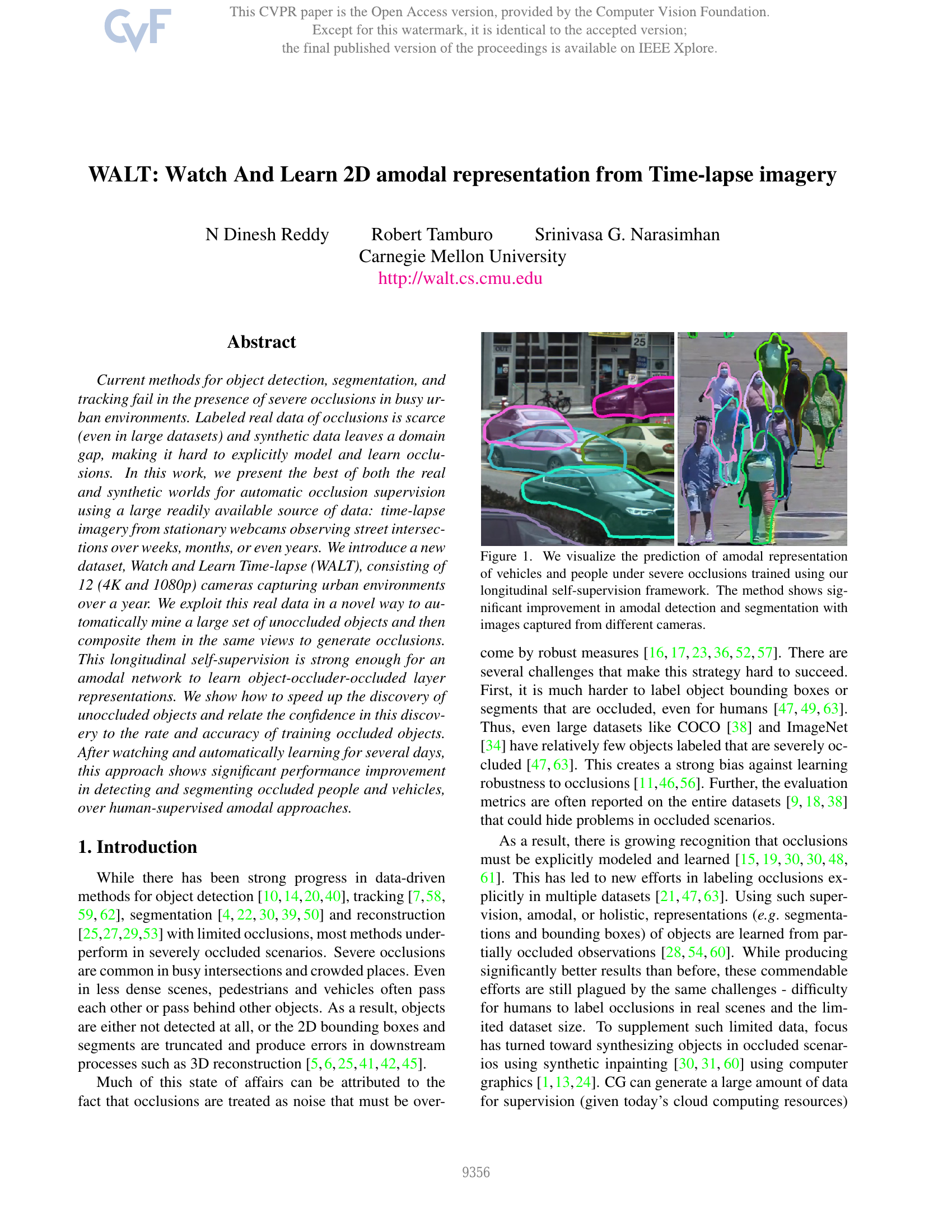

도시 환경에서 심각한 가림 현상이 발생할 경우, 기존의 객체 탐지, 분할 및 추적 기법은 성능이 크게 저하된다. 실제 가림 현상 데이터는 라벨이 부여된 경우가 매우 드물며, 대규모 데이터셋에서도 여전히 부족한 편이다. 반면 합성 데이터는 도메인 갭(domain gap) 문제를 야기하여, 가림 현상을 명시적으로 모델링하고 학습하는 데 어려움이 있다. 본 연구에서는 장기간 고정된 웹캠을 통해 도로 교차로를 수주, 수개월 또는 수년에 걸쳐 관측한 타임랩스 영상이라는 널리 이용 가능한 대량 데이터를 활용하여, 실제 데이터와 합성 데이터의 장점을 결합한 자동 가림 감시 기법을 제안한다. 우리는 12개의 카메라(4K 및 1080p 해상도)가 일 년 동안 도시 환경을 촬영한 새로운 데이터셋인 '관찰하고 학습하는 타임랩스(Watch and Learn Time-lapse, WALT)'를 소개한다. 이 실제 데이터를 혁신적인 방식으로 활용하여, 가림이 없는 객체를 자동으로 대량으로 탐색한 후, 동일한 시점에 복합(composite)하여 가림 현상을 생성한다. 이러한 장기적(self-supervised) 관측을 통해, 비모달 네트워크가 객체-장애물-가려진 객체의 계층적 표현을 학습할 수 있다. 또한, 가림이 없는 객체 탐지 속도를 높이는 방법을 제시하고, 이 탐지 신뢰도와 가림된 객체 학습의 속도 및 정확도 간의 관계를 규명한다. 이 방법은 수일간 자동으로 관측 및 학습을 수행한 후, 인간 라벨링 기반의 비모달 접근법에 비해 가려진 사람과 차량의 탐지 및 분할 성능에서 뚜렷한 향상을 보인다.