3달 전

Transform-Retrieve-Generate: 자연어 중심의 외부 지식을 활용한 시각 질문 응답

{Prem Natarajan, Ying Nian Wu, Aishwarya Reganti, Govind Thattai, Qing Ping, Feng Gao}

초록

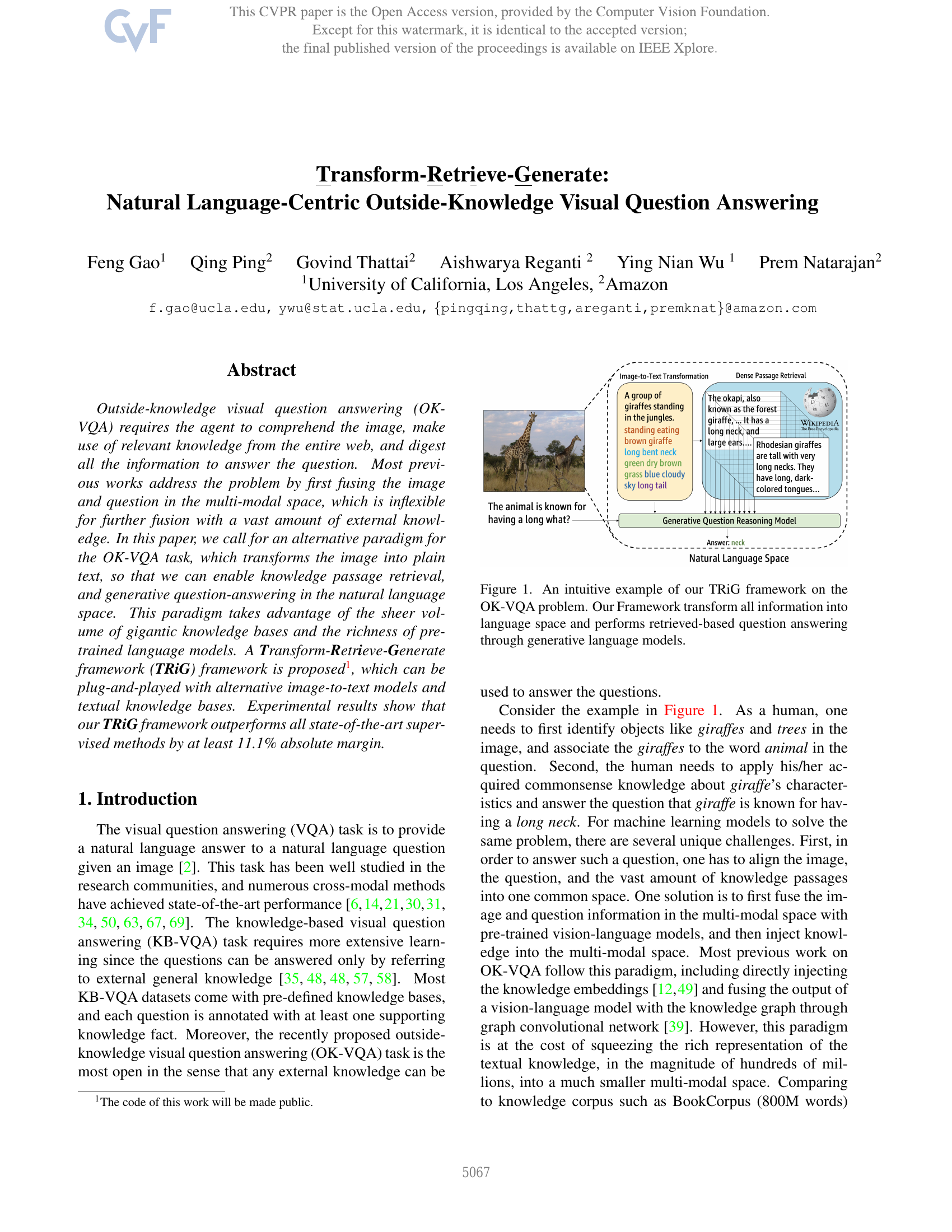

외부 지식을 활용한 시각 질문 응답(OK-VQA)은 에이전트가 이미지를 이해하고 전체 웹에서 관련 지식을 활용하며, 모든 정보를 종합하여 질문에 답해야 하는 과제를 요구한다. 기존의 대부분의 연구들은 먼저 다중 모달 공간에서 이미지와 질문을 융합하는 방식으로 문제를 해결해 왔으나, 이는 방대한 외부 지식과의 추가적인 융합에 있어서 유연성이 부족하다는 한계를 가지고 있다. 본 논문에서는 OK-VQA 과제를 위한 대안적 패러다임을 제안한다. 이 패러다임은 이미지를 일반 텍스트로 변환함으로써 자연어 공간에서 지식 문단 검색과 생성 기반 질문 응답을 가능하게 한다. 이러한 접근은 거대한 지식 기반의 방대한 양과 사전 훈련된 언어 모델의 풍부한 표현력을 적극적으로 활용할 수 있다. 제안된 Transform-Retrieve-Generate(이하 TRiG) 프레임워크는 다양한 이미지-텍스트 변환 모델과 텍스트 기반 지식 기반과의 플러그 앤 플레이(Plug-and-Play)가 가능하다. 실험 결과, TRiG 프레임워크는 모든 최첨단 지도 학습 방법보다 최소 11.1% 이상의 절대적인 성능 향상을 달성하였다.