노멀리티 기억하기: 비감독 이상 탐지를 위한 메모리 기반 지식 증류

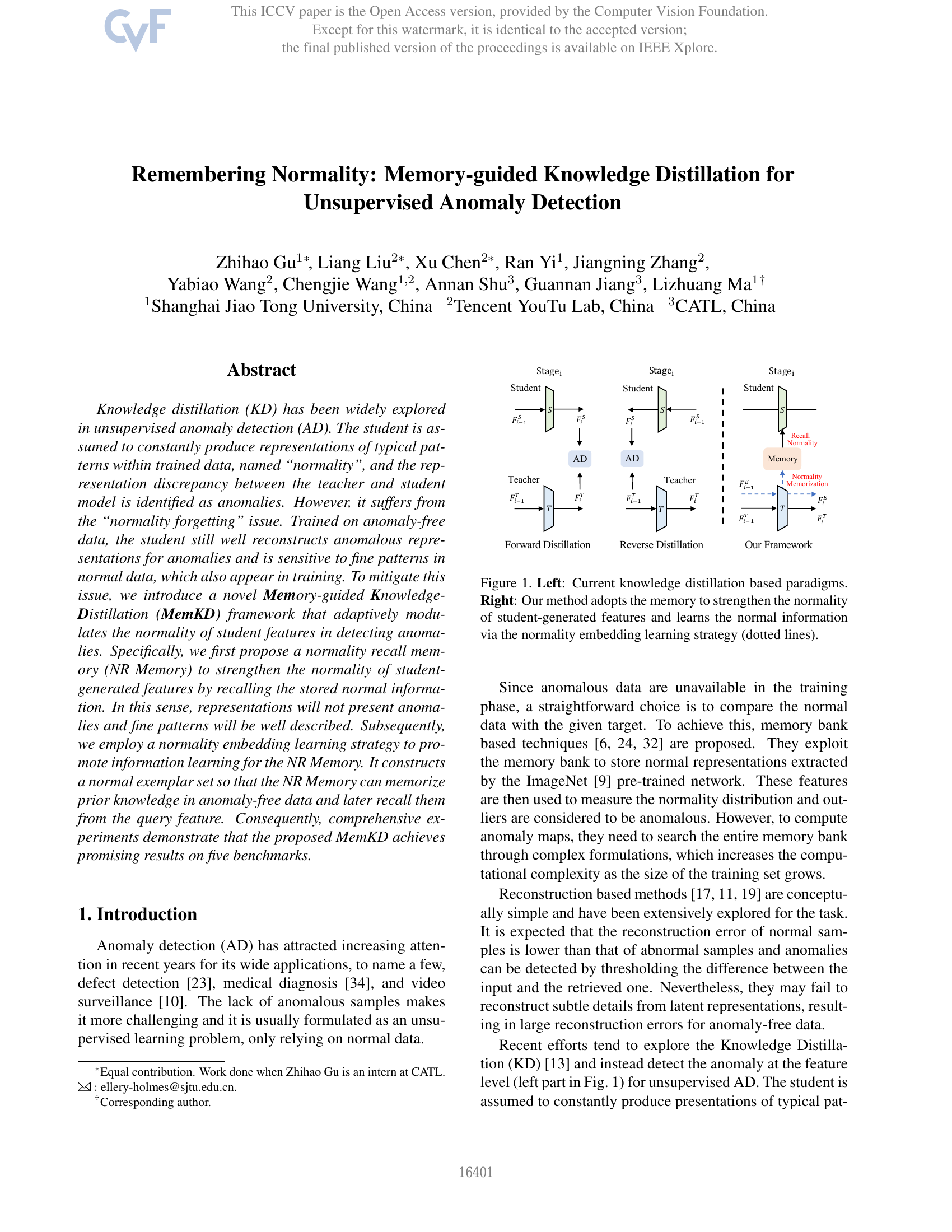

지식 증류(Knowledge Distillation, KD)는 비지도 이상 탐지(Anomaly Detection, AD) 분야에서 널리 연구되고 있다. 이 기법에서는 학습된 데이터 내 일반적인 패턴을 지속적으로 생성하는 학생 모델(student model)을 가정하며, 이러한 일반적인 패턴을 '정상성(normality)'이라 부른다. 또한, 교사 모델(teacher model)과 학생 모델 간의 표현 차이를 이상으로 식별한다. 그러나 이 방법은 '정상성 망각(normality forgetting)' 문제에 취약하다. 정상 데이터로만 학습된 학생 모델은 이상 데이터에 대해서도 잘 재구성할 수 있으며, 학습 데이터 내에 존재하는 미세한 정상 패턴에 과도하게 민감하게 반응한다. 이러한 문제를 완화하기 위해, 본 연구는 이상 탐지 시 학생 모델의 정상성 표현을 적응적으로 조절하는 새로운 메모리 기반 지식 증류(Memory-guided Knowledge Distillation, MemKD) 프레임워크를 제안한다. 구체적으로, 학생 모델이 생성한 특징의 정상성을 강화하기 위해 정상 정보를 저장하고 재활용하는 '정상성 재활성화 메모리(Normality Recall Memory, NR Memory)'를 제안한다. 이를 통해 표현이 이상으로 인식되지 않으며, 미세한 패턴도 잘 설명될 수 있다. 또한, NR 메모리의 정보 학습을 촉진하기 위해 정상 예시 집합(normal exemplar set)을 구성하는 정상성 임베딩 학습 전략을 도입한다. 이 전략을 통해 NR 메모리는 이상이 없는 데이터에서의 사전 지식을 기억하고, 이후 쿼리 특징에서 이를 재활용할 수 있다. 종합적인 실험을 통해 제안한 MemKD가 MVTec AD, VisA, MPDD, MVTec 3D-AD, Eyecandies 등 다섯 가지 벤치마크에서 뛰어난 성능을 보임을 입증하였다.