Command Palette

Search for a command to run...

{Xirong Li Bangxiang Lan Zijie Xin Ruixiang Zhao Kaibin Tian}

초록

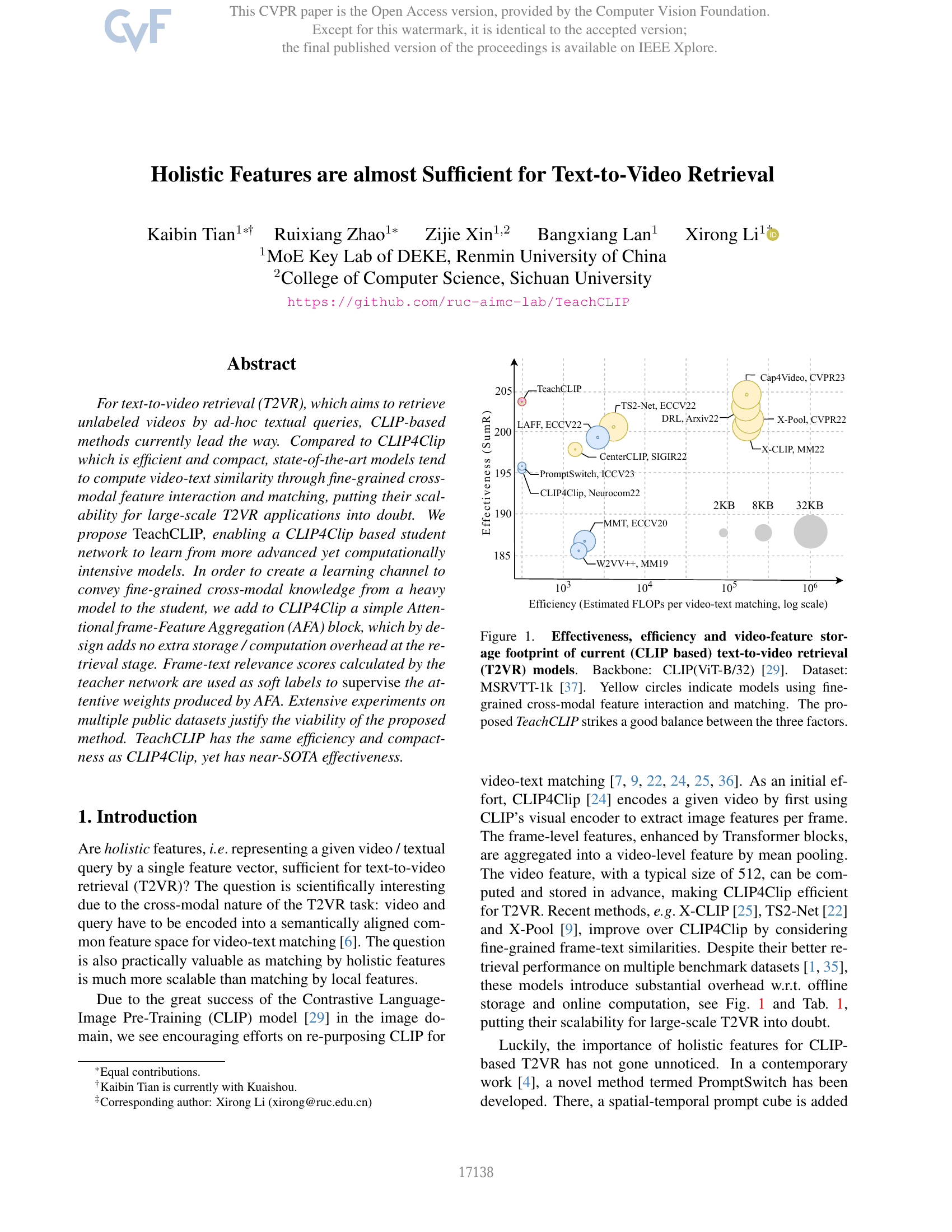

텍스트 기반 비디오 검색(Text-to-Video Retrieval, T2VR)은 즉각적인 텍스트 쿼리를 통해 레이블이 없는 비디오를 검색하는 것을 목표로 하며, 현재 CLIP 기반 방법이 주류를 이루고 있다. CLIP4Clip와 같은 효율적이고 컴팩트한 모델에 비해, 최신의 상태-최고(SOTA) 모델들은 세밀한 다모달 특성 간 상호작용과 매칭을 통해 비디오-텍스트 유사도를 계산하는 경향이 있는데, 이는 대규모 T2VR 응용에 대한 확장성에 의문을 제기한다. 본 연구에서는 더 고도화되었으나 계산 비용이 큰 모델로부터 학습할 수 있도록 CLIP4Clip 기반의 학습자 네트워크를 설계하는 TeachCLIP을 제안한다. 무거운 모델에서 학습자에게 세밀한 다모달 지식을 전달하기 위한 학습 채널을 구축하기 위해, CLIP4Clip에 단순한 Attentional frame-Feature Aggregation (AFA) 블록을 추가한다. AFA 블록은 설계상 검색 단계에서 추가적인 저장 공간 또는 계산 부담을 가하지 않으며, 교사 네트워크가 계산한 프레임-텍스트 관련성 점수를 소프트 레이블로 활용하여 AFA가 생성하는 주의 가중치를 지도한다. 다양한 공개 데이터셋에서 실시한 광범위한 실험을 통해 제안된 방법의 타당성을 입증하였다. TeachCLIP는 CLIP4Clip와 동일한 효율성과 컴팩트함을 유지하면서도 거의 SOTA 수준의 성능을 달성한다.

벤치마크

| 벤치마크 | 방법론 | 지표 |

|---|---|---|

| video-retrieval-on-msr-vtt-1ka | TeachCLIP (ViT-B/16) | text-to-video R@1: 48.0 text-to-video R@10: 83.5 text-to-video R@5: 75.9 |

| video-retrieval-on-msr-vtt-1ka | TeachCLIP | text-to-video R@1: 46.8 text-to-video R@10: 82.6 text-to-video R@5: 74.3 |

| video-retrieval-on-vatex | TeachCLIP | text-to-video R@1: 63.6 text-to-video R@10: 96.1 text-to-video R@5: 91.9 |