3달 전

CalBERT - BERT를 활용한 코드 믹스 적응형 언어 표현

{Ashwini M Joshi, Deeksha D, Aronya Baksy, Ansh Sarkar, Aditeya Baral}

초록

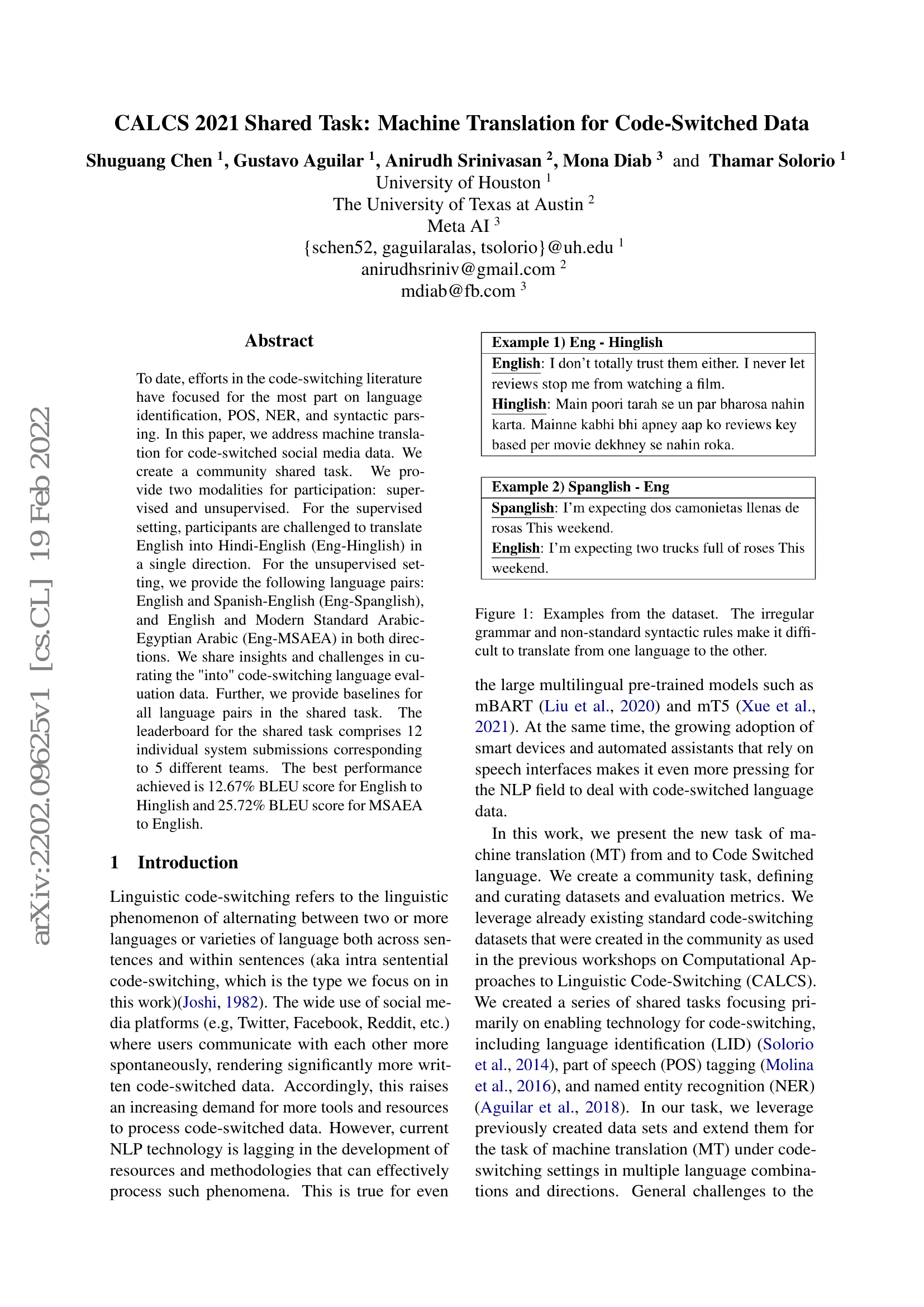

코드 믹스 언어는 글자나 발음에서 두 개 이상의 언어 유형을 결합하는 형태의 언어를 의미한다. 코드 텍스트의 분석은 언어 사용이 일관되지 않고 기존의 단일 언어 기반 접근법을 적용하기 어려우므로 해결이 어렵다. 본 연구에서는 사전 훈련된 단일 언어 기반 트랜스포머 모델이 소량의 코드 믹스 데이터 예시를 통해 코드 믹스 언어의 언어 표현을 적응시킬 수 있도록, 추가적인 단계인 "시아메스 사전 훈련(Siamese Pre-Training)"을 도입하는 새로운 접근법을 제안한다. 제안하는 아키텍처는 인도 언어 감성 분석(Sentiment Analysis for Indian Languages, SAIL) 데이터셋에서 기존 최고 성능을 초과하며, 최대 5.1점의 F1 스코어 향상을 달성하였다. 또한 인디크글루(IndicGLUE) 제품 리뷰 데이터셋에서는 기준 성능을 0.4점 초과하여 최신 기술 수준의 정확도를 달성하였다.