Reptile를 넘어서: 단일 작업 정규화를 위한 그래디언트 간 메타학습된 도트 곱 최대화

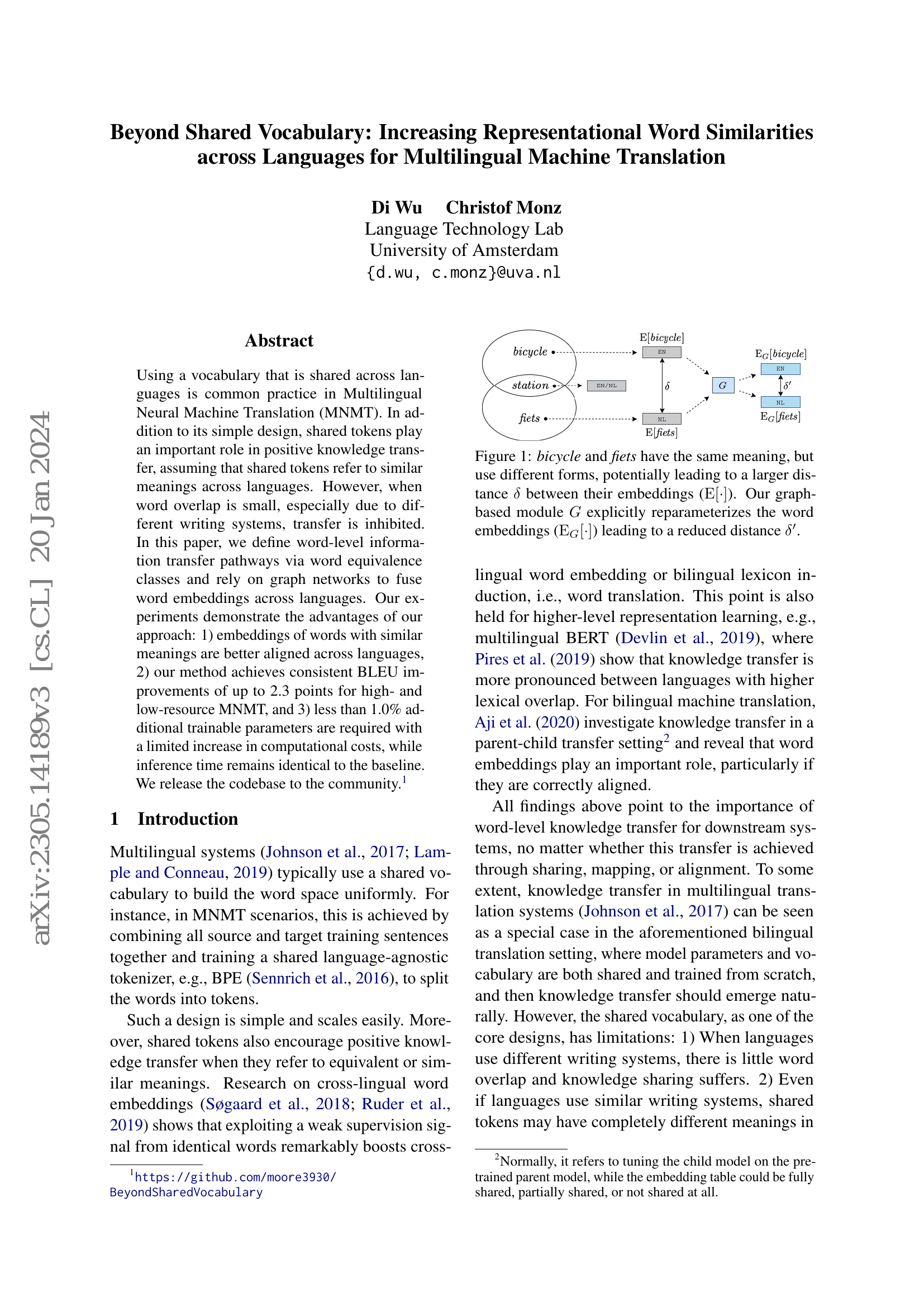

MAML, Reptile, FOMAML과 같은 메타학습 알고리즘은 여러 신경망 모델의 성능을 향상시켜 왔다. 표준 경사 하강법과 이러한 메타학습 접근법의 주요 차이점은, 배치 간 경사 벡터 간의 내적을 최대화하는 경사 성분을 소규모로 포함하고 있다는 점이다. 이는 일반화 성능을 향상시키는 데 기여한다. 기존 연구들은 정렬된 경사 벡터가 일반화와 관련이 있으며, 단일 작업 환경에서 Reptile 알고리즘을 사용하여 일반화를 개선하는 데 성공한 바 있다. 이러한 단일 작업 설정에서의 접근 방식을 영감으로 삼아, 본 논문에서는 경사 벡터의 내적에서 이 경사를 계산하기 위해 유한 차분(first-order) 알고리즘을 제안한다. 이를 통해 해당 성분의 가중치를 표준 경사에 비해 명시적으로 조절할 수 있다. 본 연구에서는 이 경사를 정규화 기법으로 사용하여 서로 다른 배치 간 경사 벡터의 정렬도를 높인다. 유한 차분 근사 방식을 사용함으로써, 단순히 헤시안(Hessian)을 직접 계산할 경우 발생하는 O(n²)의 메모리 사용 문제를 피할 수 있으며, 대규모 모델과 큰 배치 크기에서도 쉽게 적용 가능하다. 제안된 방법은 Gigaword 데이터셋에서 최신 기준(SOTA) 성능을 달성하였으며, SQuAD-v2.0, Quasar-T, NewsQA, 그리고 모든 SuperGLUE 데이터셋에서 BERT, RoBERTa, ELECTRA 등 다양한 모델에 대해 성능 향상을 보였다. 또한 단일 작업 및 다중 작업 환경에서 기존의 Reptile 및 FOMAML 접근법보다 정규화 기법으로 사용했을 때 우수한 성능을 나타냈다. 본 방법은 모델에 독립적(모델 무관)이며, 추가적인 학습 가능한 가중치를 도입하지 않는다.