Command Palette

Search for a command to run...

{Mohamed Omar Linda Liu Xiang Hao Xiaohang Sun Kevin Hsu Jingru Yi Wentao Zhu}

초록

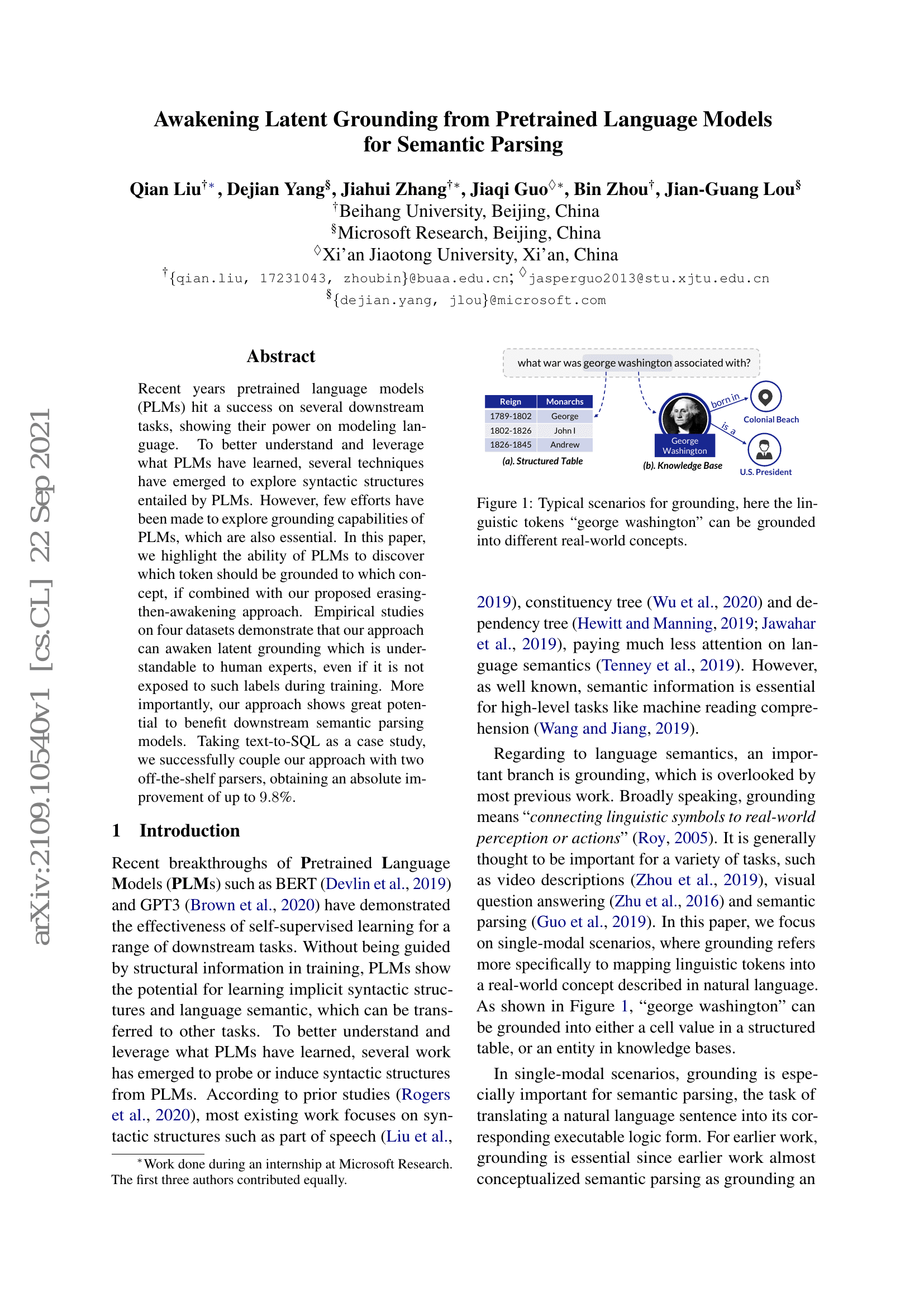

행동 인식은 영상 이해 분야에서 핵심적인 연구 주제이다. 다양한 데이터 소스로부터 효과적으로 학습하기 위해 본 연구에서는 새로운 다중모달 행동 인식 방법론으로 Audio-Video Transformer(AVT)를 제안한다. AVT는 영상과 음성 신호의 조합을 활용하여 행동 인식 정확도를 향상시키며, 영상 트랜스포머가 제공하는 효과적인 시공간 표현을 적극적으로 활용한다. 다중모달 융합을 위해 단순히 교차모달 트랜스포머 내에서 다중모달 토큰을 연결하는 방식은 계산 및 메모리 리소스를 대량 소비하게 되지만, 본 연구에서는 오디오-비디오 볼트넥 트랜스포머를 도입하여 교차모달 복잡도를 줄이는 방식을 제안한다. 또한, 다중모달 트랜스포머의 학습 효율성을 높이기 위해 자율학습 목표를 AVT 학습에 통합하였으며, 이는 오디오-비디오 대조 학습(audio-video contrastive learning), 오디오-비디오 매칭(audio-video matching), 그리고 마스킹된 오디오 및 비디오 학습(masked audio and video learning)을 포함한다. 이를 통해 다양한 오디오 및 비디오 표현을 동일한 다중모달 표현 공간으로 매핑할 수 있다. 더불어 AVT에서 의미 있는 오디오 활동을 학습하기 위해 마스킹된 오디오 세그먼트 손실(masked audio segment loss)을 제안하였다. 공개 데이터셋 3종과 내부 데이터셋 2종에 대한 광범위한 실험 및 아블레이션 연구를 통해 제안된 AVT의 효과성을 일관되게 입증하였다. 구체적으로, 외부 학습 데이터 없이 Kinetics-Sounds 및 Epic-Kitchens-100 데이터셋에서 기존 최고 성능 모델 대비 각각 8%, 1%의 성능 향상을 달성하였으며, VGGSound 데이터셋에서는 비디오 트랜스포머 기반 기존 최고 성능 모델 대비 10%의 성능 향상을 오디오 신호를 활용해 달성하였다. 또한, 기존 최고 성능 다중모달 트랜스포머 대비 FLOPs 기준 1.3배의 효율성 향상을 보이며, Epic-Kitchens-100에서 정확도를 4.2% 향상시켰다. 시각화 결과를 통해 오디오 신호가 보완적이고 구분력 있는 특징을 제공함을 확인하였으며, 본 AVT는 오디오와 비디오의 결합을 통해 행동을 효과적으로 이해할 수 있음을 입증하였다.

벤치마크

| 벤치마크 | 방법론 | 지표 |

|---|---|---|

| action-recognition-on-epic-kitchens-100 | AVT | Action@1: 47.2 Noun@1: 59.3 Verb@1: 70.4 |

| audio-classification-on-vggsound | AVT (Audio-Visual) | Top 1 Accuracy: 63.9 Top 5 Accuracy: 85.0 |

| audio-classification-on-vggsound | AVT (V) | Top 1 Accuracy: 53.2 Top 5 Accuracy: 74.8 |

| multi-modal-classification-on-vgg-sound | AVT | Top-1 Accuracy: 63.9 Top-5 Accuracy: 85.0 |