Command Palette

Search for a command to run...

Zhi Zheng Wee Sun Lee

초록

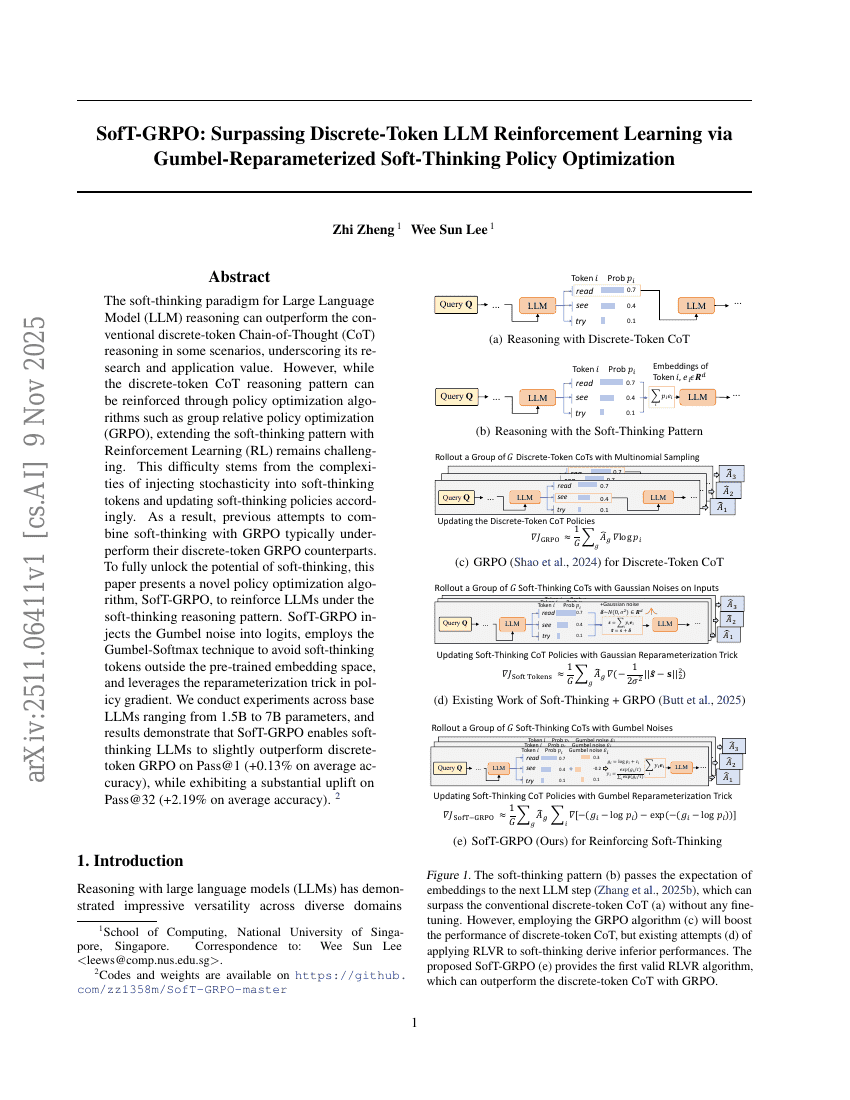

대규모 언어 모델(LLM)의 소프트 사고(soft-thinking) 패러다임은 특정 시나리오에서 전통적인 이산 토큰 사고 체인(Chain-of-Thought, CoT) 패러다임을 초월할 수 있으며, 이는 그 연구적·응용적 가치를 강조한다. 그러나 이산 토큰 CoT 패러다임은 그룹 상대 정책 최적화(GRPO)와 같은 정책 최적화 알고리즘을 통해 강화가 가능하지만, 소프트 사고 패러다임에 강화 학습(Reinforcement Learning, RL)을 적용하는 것은 여전히 도전 과제이다. 이 어려움은 소프트 사고 토큰에 확률적 요소를 도입하고, 이를 기반으로 소프트 사고 정책을 갱신하는 데 발생하는 복잡성에서 기인한다. 결과적으로, 기존의 소프트 사고와 GRPO를 결합한 시도는 일반적으로 이산 토큰 기반 GRPO 대비 성능이 낮았다. 소프트 사고의 잠재력을 완전히 발휘하기 위해 본 논문은 소프트 사고 추론 패러다임 하에서 LLM을 강화할 수 있는 새로운 정책 최적화 알고리즘인 SofT-GRPO를 제안한다. SofT-GRPO는 로짓에 Gumbel 노이즈를 주입하고, Gumbel-Softmax 기법을 활용하여 사전 훈련된 임베딩 공간 밖의 소프트 사고 토큰이 생성되는 것을 방지하며, 정책 기울기(policy gradient) 계산에 재파라미터화 기법(reparameterization trick)을 도입한다. 본 연구는 1.5B에서 7B 파라미터 규모의 베이스 LLM을 대상으로 실험을 수행하였으며, 실험 결과 SofT-GRPO는 소프트 사고 LLM이 Pass@1에서 평균 0.13%의 정확도 향상(+)을 달성함으로써 이산 토큰 기반 GRPO를 약간 상회함을 보였다. 또한 Pass@32에서는 평균 2.19%의 상당한 성능 향상을 기록하였다. 코드 및 모델 가중치는 https://github.com/zz1358m/SofT-GRPO-master 에 공개되어 있다.