Command Palette

Search for a command to run...

Speed Zhu Jianwei Cai Guang Chen Lulu Wu Saiyong Yang Wiggin Zhou

초록

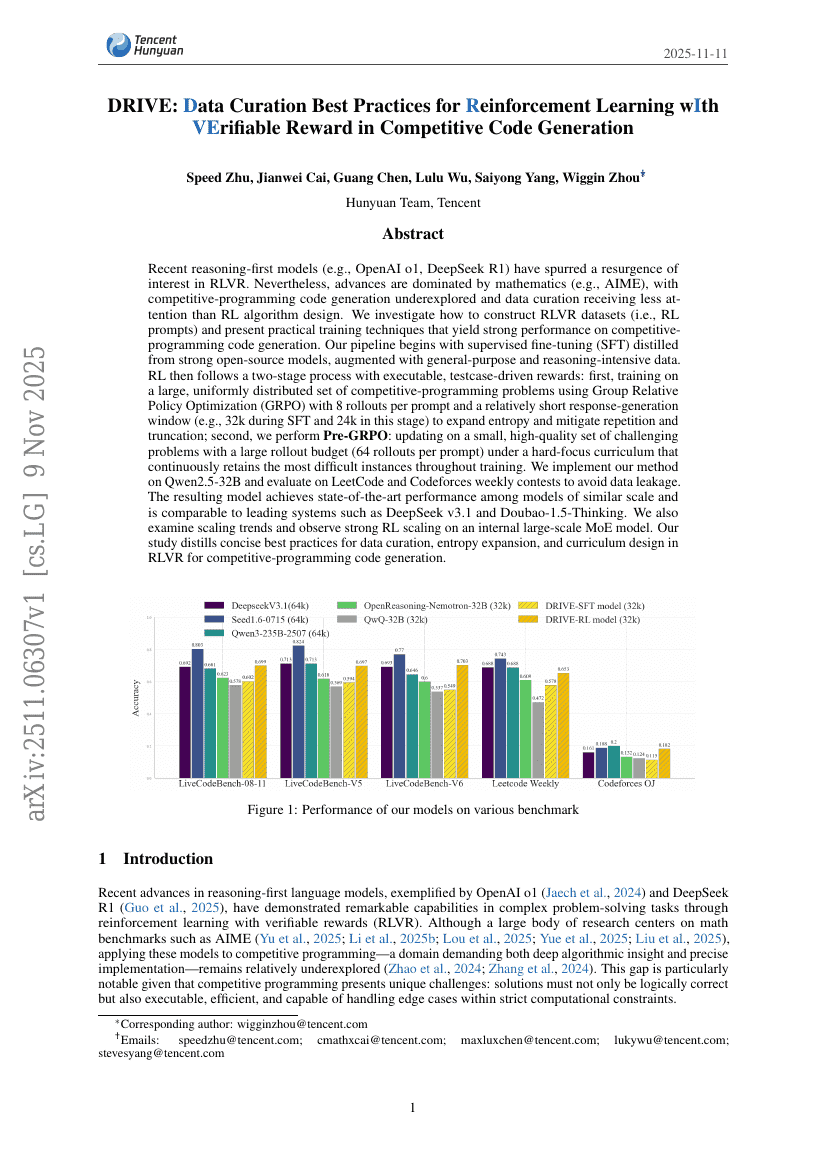

최근의 추론 우선 모델(예: OpenAI o1, DeepSeek R1)의 등장은 RLVR(Reinforcement Learning with Value-based Reward)에 대한 관심을 다시 끌어올렸다. 그러나 기술적 발전은 주로 수학 문제 해결(예: AIME)에 집중되어 있으며, 경쟁적 프로그래밍 코드 생성은 여전히 탐색이 부족한 영역이며, RL 알고리즘 설계에 비해 데이터 정제에 대한 관심이 낮은 편이다. 본 연구는 경쟁적 프로그래밍 코드 생성을 위한 RLVR 데이터셋(즉, RL 프롬프트)을 어떻게 구축할 수 있는지 탐구하고, 실용적인 학습 기법을 제시하여 뛰어난 성능을 달성한다. 제안하는 파이프라인은 강력한 오픈소스 모델로부터 추출한 지도 미세조정(Supervised Fine-Tuning, SFT)을 기반으로 하며, 일반적인 목적과 추론 집약적인 데이터를 추가로 보강한다. 이후 RL 과정은 실행 가능한, 테스트케이스 기반의 보상 구조를 활용한 이단계 프로세스로 구성된다. 첫 번째 단계에서는, 그룹 상대 정책 최적화(Group Relative Policy Optimization, GRPO)를 사용해 경쟁적 프로그래밍 문제의 대규모이고 균일하게 분포된 데이터셋을 학습하며, 프롬프트당 8회의 롤아웃과 비교적 짧은 응답 생성 윈도우(예: SFT 시 32k, 이 단계에서는 24k)를 적용함으로써 엔트로피를 확장하고 반복 및 절단 문제를 완화한다. 두 번째 단계에서는, 난이도 높은 고품질 문제의 소규모 셋을 대상으로 Pre-GRPO를 수행한다. 이 과정은 하드포커스 커리큘럼을 적용하여, 학습 전반에 걸쳐 가장 어려운 문제를 지속적으로 유지하며, 프롬프트당 64회의 롤아웃을 허용하는 대규모 롤아웃 예산을 활용한다. 본 방법은 Qwen2.5-32B 모델에 구현되었으며, 데이터 유출을 방지하기 위해 LeetCode 및 Codeforces 주간 대회 데이터셋을 기반으로 평가되었다. 그 결과, 유사 규모의 모델 중 최고 수준의 성능을 달성하였으며, DeepSeek v3.1 및 Doubao-1.5-Thinking과 경쟁 가능한 성능을 보였다. 또한 스케일링 경향을 분석한 결과, 내부 대규모 MoE 모델에서 강력한 RL 스케일링 효과를 관찰할 수 있었다. 본 연구는 경쟁적 프로그래밍 코드 생성을 위한 RLVR에서의 데이터 정제, 엔트로피 확장, 커리큘럼 설계에 관한 간결한 최적 실천 방안을 정리하였다.