Command Palette

Search for a command to run...

Sen Xu Yi Zhou Wei Wang Jixin Min Zhibin Yin Yingwei Dai Shixi Liu Lianyu Pang Yirong Chen Junlin Zhang

초록

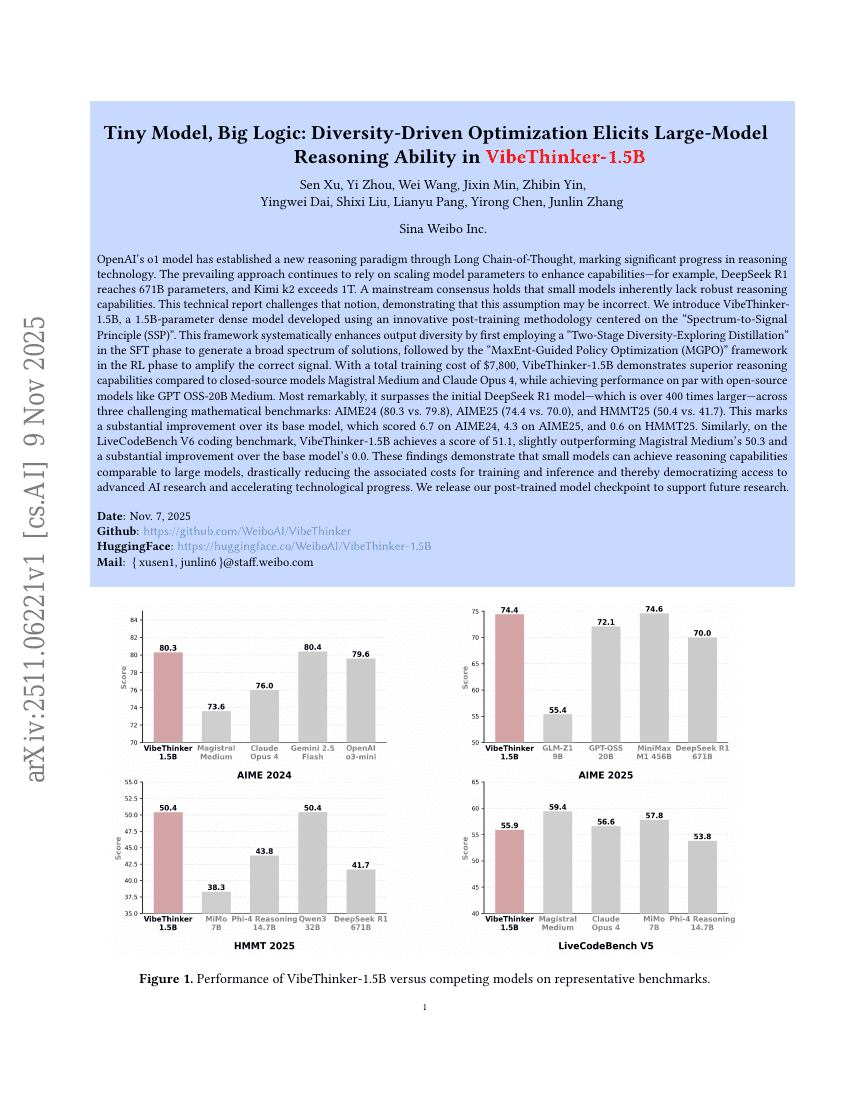

현재까지 널리 받아들여지는 견해는 소형 모델은 본질적으로 강력한 추론 능력을 갖지 못한다는 것이지만, 본 보고서는 스펙트럼-신호 원리(Spectrum-to-Signal Principle, SSP)를 기반으로 개발한 15억 파라미터(dense model)인 VibeThinker-1.5B를 소개한다. 이는 DeepSeek R1(6710억 파라미터), Kimi k2(1조 이상 파라미터)와 같은 모델들에서 관찰되는 파라미터 확장 전략을 도전하는 사례이다. SSP 프레임워크는 먼저 ‘이단계 다양성 탐색 증류(Two-Stage Diversity-Exploring Distillation, SFT)’를 통해 다양한 해결 방안의 스펙트럼을 생성한 후, MaxEnt-가이드 정책 최적화(MaxEnt-Guided Policy Optimization, RL)를 통해 정확한 신호를 강화한다. 총 학습 비용이 단지 7,800달러에 불과한 VibeThinker-1.5B는 Magistral Medium 및 Claude Opus 4와 같은 폐쇄형 모델보다 뛰어난 추론 능력을 보이며, GPT OSS-20B Medium과 같은 오픈소스 모델과도 비슷한 성능을 기록한다. 특히, 400배 이상 큰 규모의 DeepSeek R1보다 세 가지 수학 벤치마크에서 우수한 성능을 보였다. AIME24(80.3 대 79.8), AIME25(74.4 대 70.0), HMMT25(50.4 대 41.7)에서 각각 우세한 점수를 기록했으며, 기반 모델(기본 모델 대비 각각 6.7, 4.3, 0.6)에 비해 상당한 성능 향상을 이뤘다. LiveCodeBench V6에서의 점수는 51.1로, Magistral Medium(50.3)과 기반 모델(0.0)을 모두 상회한다. 이러한 결과는 소형 모델이 대규모 모델과 비교해도 충분한 추론 능력을 달성할 수 있음을 입증하며, 학습 및 추론 비용을 극적으로 절감함으로써 고급 인공지능 연구의 민주화를 가능하게 한다.