Command Palette

Search for a command to run...

초록

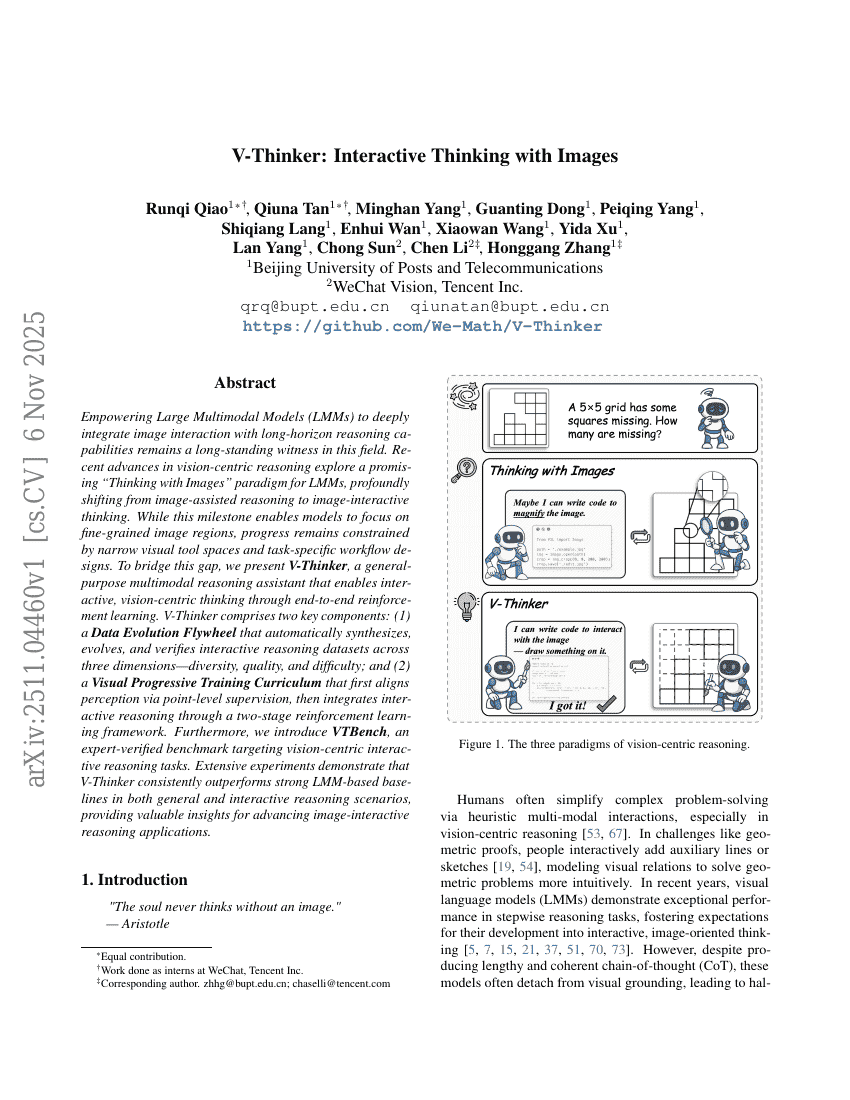

대규모 다중모달 모델(LMMs)이 이미지 상호작용을 장기적 추론 능력과 깊이 있게 통합할 수 있도록 하는 것은 이 분야에서 오랫동안 해결되지 않은 과제였다. 최근의 시각 중심 추론 기술은 LMMs를 위한 '이미지로 사고하기(Thinking with Images)'라는 전망 있는 패러다임을 탐색하며, 이미지 보조 추론에서 이미지 상호작용 기반 사고로의 전환을 의미한다. 이 중요한 진전은 모델이 이미지의 세부 영역에 집중할 수 있게 했지만, 여전히 제한된 시각 도구 공간과 태스크별 워크플로우 설계로 인해 발전이 제한되고 있다. 이러한 격차를 메우기 위해, 우리는 엔드투엔드 강화학습을 통해 상호작용적이고 시각 중심의 사고를 가능하게 하는 일반적인 다중모달 추론 보조자인 V-Thinker를 제안한다. V-Thinker는 두 가지 핵심 구성 요소로 구성된다: (1) 다양성, 품질, 난이도 세 가지 차원에서 자동으로 데이터를 생성하고 진화시키며 검증하는 '데이터 진화 플라이휠(Data Evolution Flywheel)'; (2) 점 수준의 감독을 통해 인지 능력을 초기화한 후, 이중 단계 강화학습 프레임워크를 통해 상호작용적 추론을 통합하는 '시각적 점진적 훈련 커리큘럼(Visual Progressive Training Curriculum)'. 또한, 시각 중심의 상호작용 추론 태스크를 전문가가 검증한 기준으로 삼는 VTBench를 도입한다. 광범위한 실험을 통해 V-Thinker가 일반적 추론 및 상호작용 추론 시나리오 모두에서 강력한 LMM 기반 기준 모델들을 일관되게 능가함을 입증하였으며, 이미지 기반 상호작용 추론 응용 기술의 발전에 중요한 통찰을 제공한다.