Command Palette

Search for a command to run...

초록

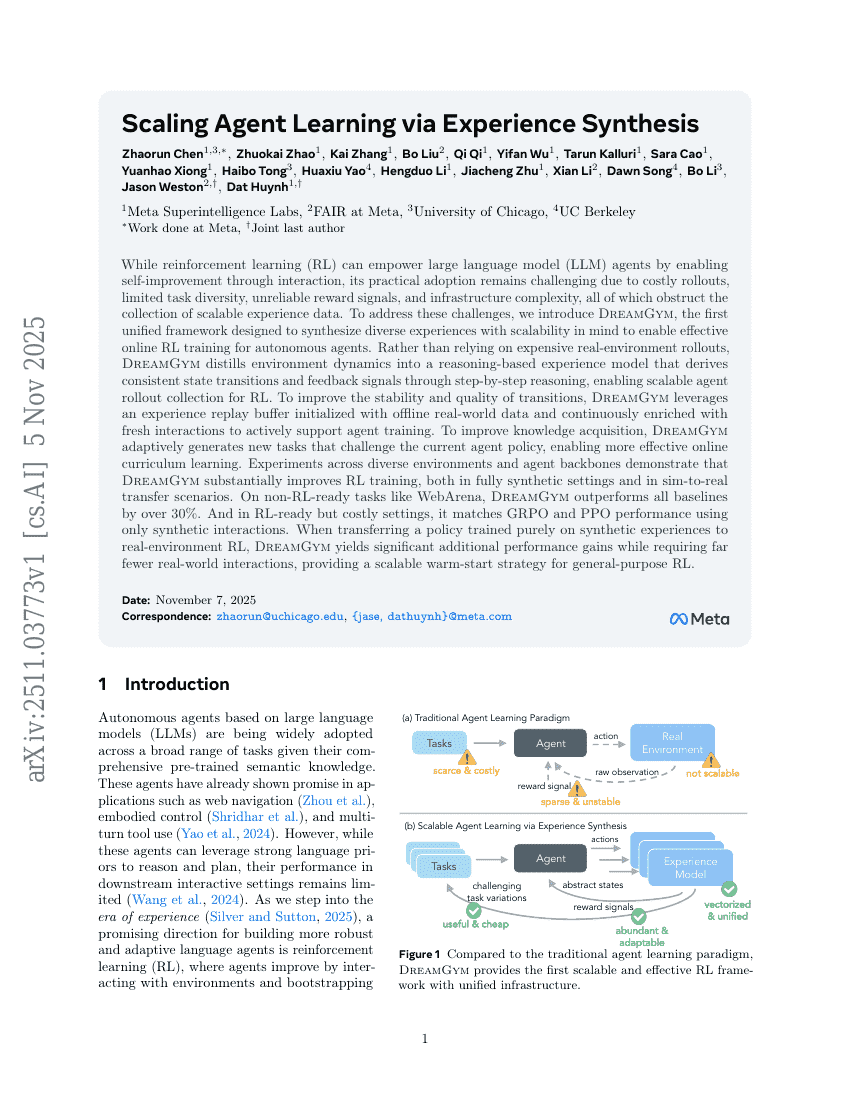

강화학습(RL)은 대규모 언어 모델(LLM) 에이전트가 상호작용을 통해 자율적으로 개선할 수 있도록 함으로써 그 능력을 강화할 수 있다. 그러나 높은 비용의 롤아웃, 제한된 작업 다양성, 신뢰할 수 없는 보상 신호, 인프라의 복잡성 등으로 인해 실용적 도입이 여전히 어려운 상황이다. 이러한 문제들은 확장 가능한 경험 데이터 수집을 방해한다. 이러한 과제를 해결하기 위해, 우리는 자율 에이전트를 위한 효과적인 온라인 강화학습 훈련을 가능하게 하기 위해 다각적 경험을 합성하고 확장성에 주목한 최초의 통합 프레임워크인 DreamGym을 제안한다. 실환경에서의 비용이 큰 롤아웃에 의존하는 대신, DreamGym은 환경의 동역학을 추출하여 추론 기반의 경험 모델로 구현한다. 이 모델은 단계적 추론을 통해 일관된 상태 전이와 피드백 신호를 도출함으로써, 강화학습을 위한 확장 가능한 에이전트 롤아웃 수집을 가능하게 한다. 전이의 안정성과 품질을 향상시키기 위해, DreamGym은 오프라인 실세계 데이터로 초기화된 경험 재생 버퍼를 활용하며, 지속적으로 새로운 상호작용 데이터로 업데이트함으로써 에이전트 훈련을 적극적으로 지원한다. 지식 습득을 향상시키기 위해, DreamGym은 현재 에이전트 정책을 도전할 수 있는 새로운 작업을 적응적으로 생성함으로써, 보다 효과적인 온라인 커리큘럼 학습을 가능하게 한다. 다양한 환경과 에이전트 백본을 대상으로 한 실험 결과, DreamGym은 완전히 합성된 환경에서뿐만 아니라 시뮬레이션에서 실제 환경으로의 전이(Sim-to-Real) 시나리오에서도 강화학습 훈련을 크게 향상시킴을 입증했다. WebArena와 같은 RL 준비가 되지 않은 작업에서는 모든 기준 모델을 30% 이상 초과하는 성능을 달성했다. 또한, RL에 적합하나 비용이 큰 환경에서는 합성 상호작용만을 사용해 GRPO와 PPO의 성능을 근사함을 보였다. 합성 경험만으로 훈련된 정책을 실제 환경의 강화학습에 전이할 경우, DreamGym은 훨씬 적은 실세계 상호작용으로도 상당한 성능 향상을 제공하며, 일반적인 강화학습을 위한 확장 가능한 웜스타트 전략을 제시한다.