Command Palette

Search for a command to run...

Qing Zong Jiayu Liu Tianshi Zheng Chunyang Li Baixuan Xu Haochen Shi Weiqi Wang Zhaowei Wang Chunkit Chan Yangqiu Song

초록

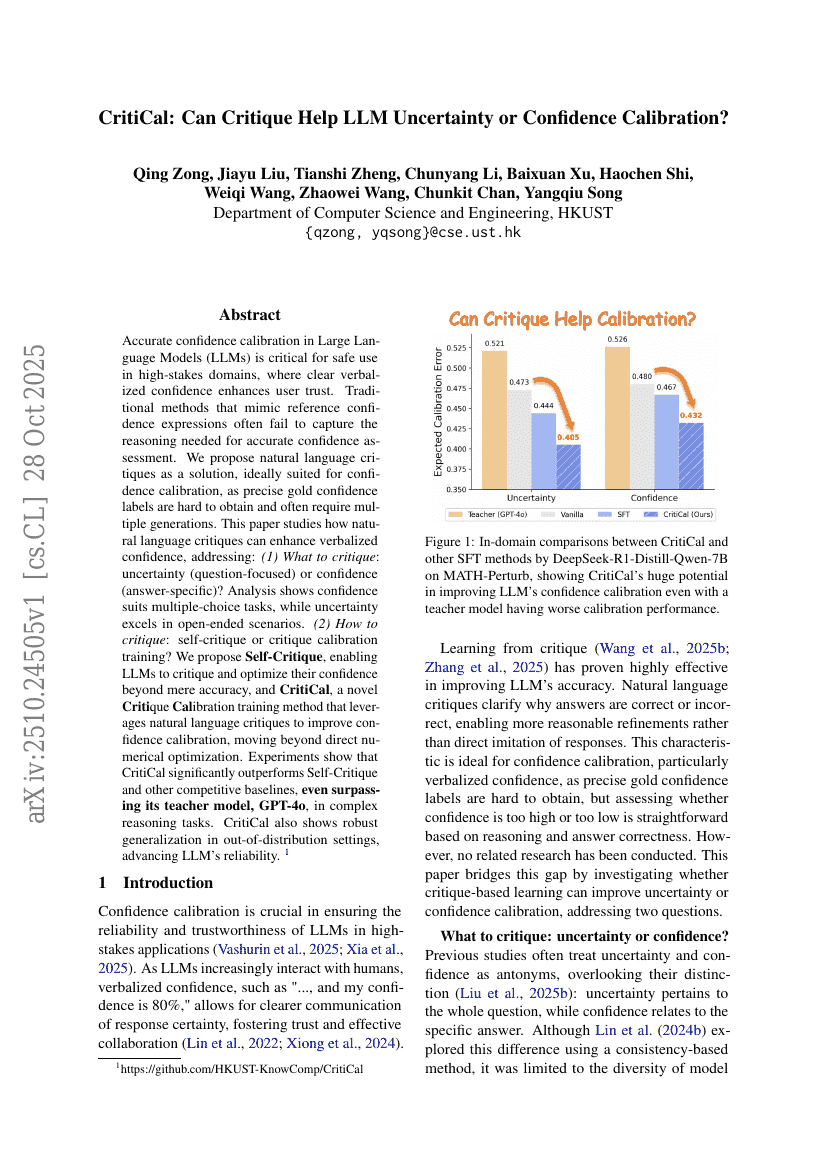

대규모 언어 모델(LLM)에서 정확한 신뢰도 보정은 신뢰성이 중요한 고위험 분야에서의 안전한 활용에 필수적이며, 명확한 언어적 표현을 통한 신뢰도 제시는 사용자의 신뢰를 높이는 데 기여한다. 기존의 참조 신뢰도 표현을 모방하는 방법들은 정확한 신뢰도 평가에 필요한 추론을 포착하지 못하는 경우가 많다. 본 연구에서는 자연어 비판(natural language critiques)을 해결책으로 제안한다. 정밀한 참 신뢰도 레이블을 확보하는 것은 어렵고, 종종 여러 차례 생성이 필요하기 때문에, 자연어 비판은 신뢰도 보정에 특히 적합하다. 본 논문은 자연어 비판이 언어화된 신뢰도를 어떻게 향상시킬 수 있는지 탐구하며, 다음과 같은 문제를 다룬다. (1) 무엇을 비판할 것인가? 질문 중심의 불확실성(uncertainty)을, 아니면 답변 중심의 신뢰도(confidence)를 비판할 것인가? 분석 결과, 신뢰도는 다중 선택형 과제에 적합한 반면, 불확실성은 개방형 시나리오에서 더 우수한 성능을 보인다. (2) 어떻게 비판할 것인가? 자기 비판(self-critique)인지, 아니면 비판 보정 학습(critique calibration training)인가? 우리는 LLM이 단순한 정확도를 넘어서 자신의 신뢰도를 비판하고 최적화할 수 있도록 하는 Self-Critique를 제안하며, 자연어 비판을 활용하여 신뢰도 보정을 향상시키는 새로운 비판 보정 학습 방법인 CritiCal을 제안한다. CritiCal은 직접적인 수치 최적화를 넘어서는 접근 방식을 취한다. 실험 결과 CritiCal은 Self-Critique 및 기타 경쟁적 기준 모델보다 유의미하게 우수하며, 복잡한 추론 과제에서는 오히려 교사 모델인 GPT-4o를 초월하는 성능을 보였다. 또한 CritiCal은 분포 외(out-of-distribution) 설정에서도 강건한 일반화 능력을 보이며, LLM의 신뢰성 향상에 기여한다.