Command Palette

Search for a command to run...

초록

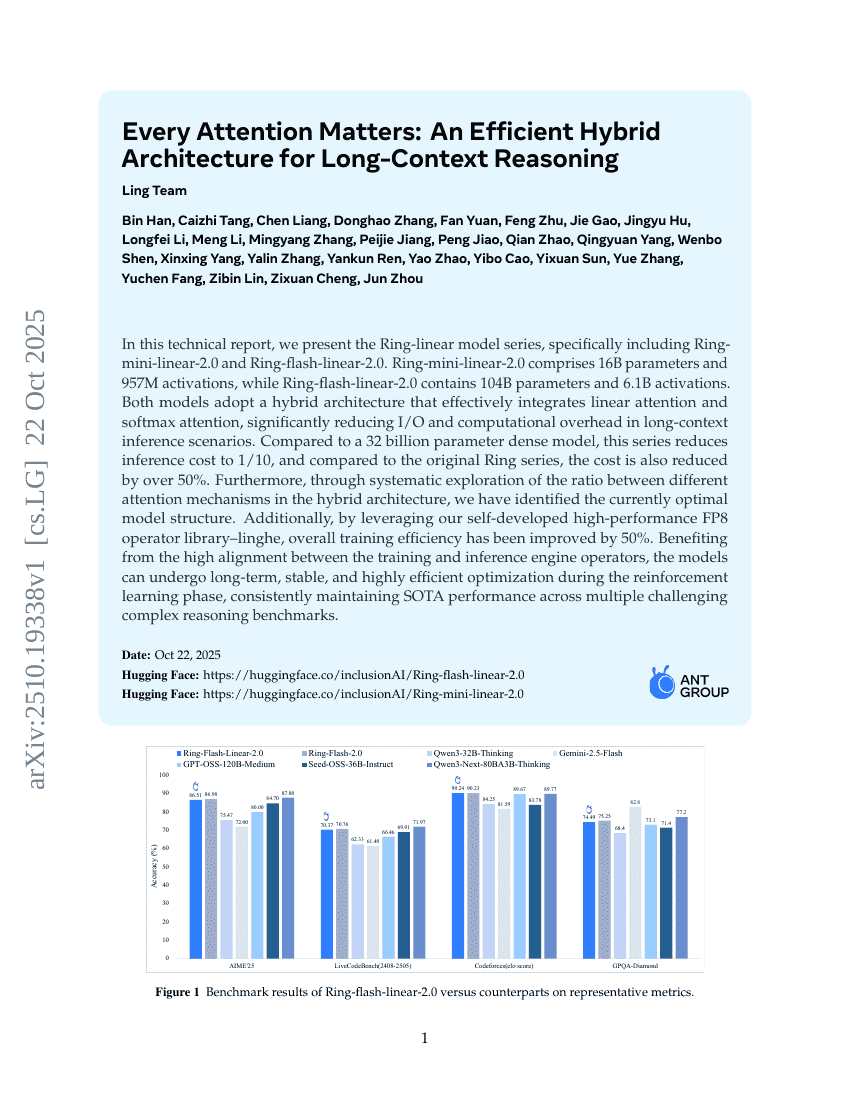

이 기술 보고서에서는 Ring-linear 모델 시리즈를 제시한다. 구체적으로 Ring-mini-linear-2.0과 Ring-flash-linear-2.0이 포함된다. Ring-mini-linear-2.0은 160억 파라미터와 9.57억 활성화 값을 가지며, Ring-flash-linear-2.0은 1,040억 파라미터와 61억 활성화 값을 갖는다. 두 모델 모두 선형 어텐션과 소프트맥스 어텐션을 효과적으로 통합한 하이브리드 아키텍처를 채택하여, 긴 컨텍스트 추론 환경에서 I/O 및 계산 오버헤드를 크게 감소시킨다. 320억 파라미터를 가진 밀도 높은 모델과 비교했을 때, 이 시리즈는 추론 비용을 1/10로 줄였으며, 기존 Ring 시리즈와 비교해도 비용이 50% 이상 감소했다. 더불어, 하이브리드 아키텍처 내에서 다양한 어텐션 메커니즘 간 비율을 체계적으로 탐색함으로써 현재 최적의 모델 구조를 도출하였다. 또한 자체 개발한 고성능 FP8 연산자 라이브러리 'linghe'를 활용함으로써, 전반적인 학습 효율이 50% 향상되었다. 훈련과 추론 엔진 연산자 간 높은 일치성 덕분에, 강화 학습 단계에서 모델은 장기간에 걸쳐 안정적이고 고도로 효율적인 최적화를 수행할 수 있으며, 여러 도전적인 복잡한 추론 벤치마크에서 지속적으로 최고 수준(SOTA)의 성능을 유지할 수 있다.