Command Palette

Search for a command to run...

Boyang Zheng Nanye Ma Shengbang Tong Saining Xie

초록

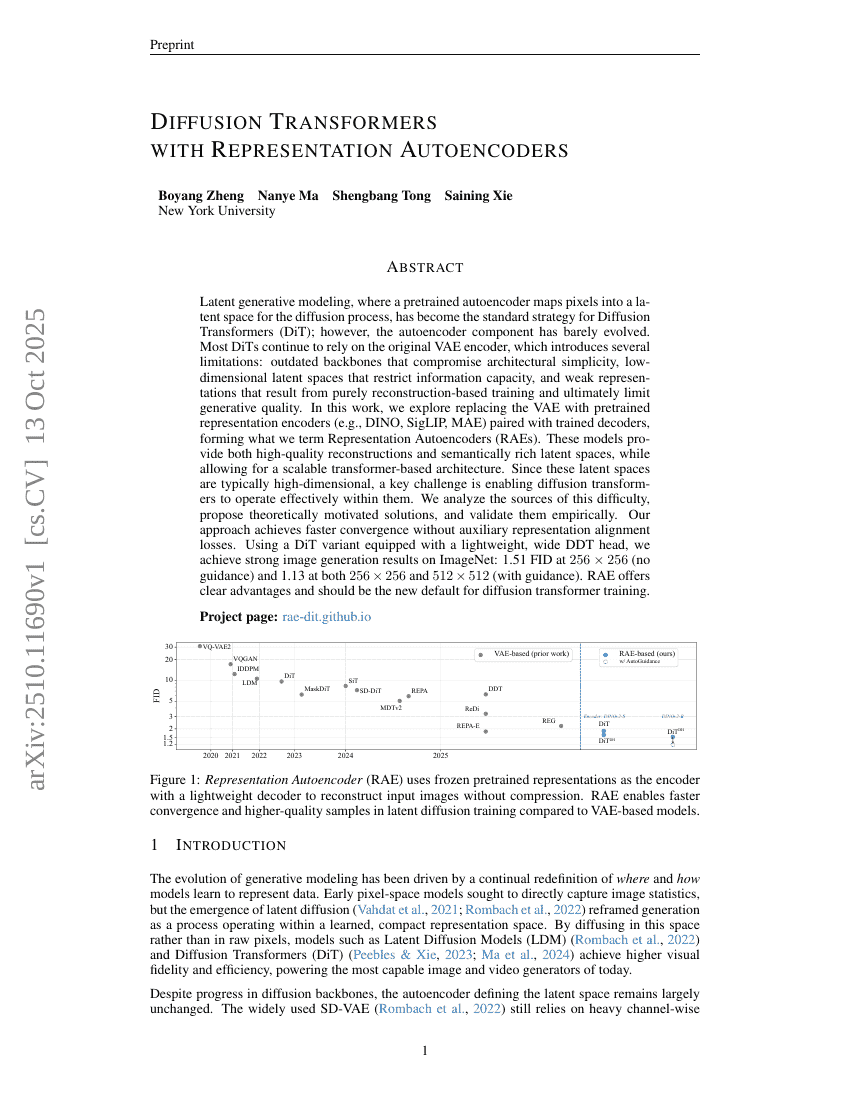

잠재적 생성 모델링( latent generative modeling)은 사전 훈련된 오토인코더가 픽셀을 잠재 공간으로 매핑하여 확산 과정(diffusion process)에 활용하는 방식으로, 확산 트랜스포머(Diffusion Transformers, DiT)의 표준 전략이 되었다. 그러나 오토인코더 구성 요소는 거의 진화하지 않았다. 대부분의 DiT는 여전히 원래의 VAE 인코더에 의존하며, 이로 인해 여러 한계가 발생한다. 즉, 아키텍처의 단순성을 해치는 구식 백본(backend), 정보 용량을 제한하는 저차원의 잠재 공간, 순수 재구성 기반 훈련에 의해 발생하는 약한 표현 능력 등이 있으며, 이는 결국 생성 품질을 제한한다. 본 연구에서는 VAE 대신 사전 훈련된 표현 인코더(DINO, SigLIP, MAE 등)와 훈련된 디코더를 조합하여 ‘표현 오토인코더(Representation Autoencoders, RAE)’를 제안한다. 이러한 모델은 높은 품질의 재구성과 의미적으로 � богrich한 잠재 공간을 동시에 제공하며, 확장 가능한 트랜스포머 기반 아키텍처를 가능하게 한다. 그러나 이러한 잠재 공간은 일반적으로 고차원이므로, 확산 트랜스포머가 이들 공간 내에서 효과적으로 작동하도록 하는 것이 핵심 과제이다. 본 연구에서는 이 어려움의 원인을 분석하고, 이론적으로 타당한 해결책을 제안하며, 실험적으로 검증한다. 제안하는 방법은 보조적인 표현 정렬 손실( representation alignment loss) 없이도 빠른 수렴을 달성한다. 경량화된 넓은 DDT 헤드를 탑재한 DiT 변형 모델을 사용하여 ImageNet에서 강력한 이미지 생성 성능을 달성하였으며, 256×256 해상도에서 지도 없이 1.51의 FID를 기록하였고, 지도가 있는 경우 256×256 및 512×512 해상도 모두에서 1.13의 FID를 달성하였다. RAE는 명확한 장점을 제공하며, 확산 트랜스포머 훈련의 새로운 표준이 되어야 할 것이다.