Command Palette

Search for a command to run...

Emma Kondrup Anne Imouza

초록

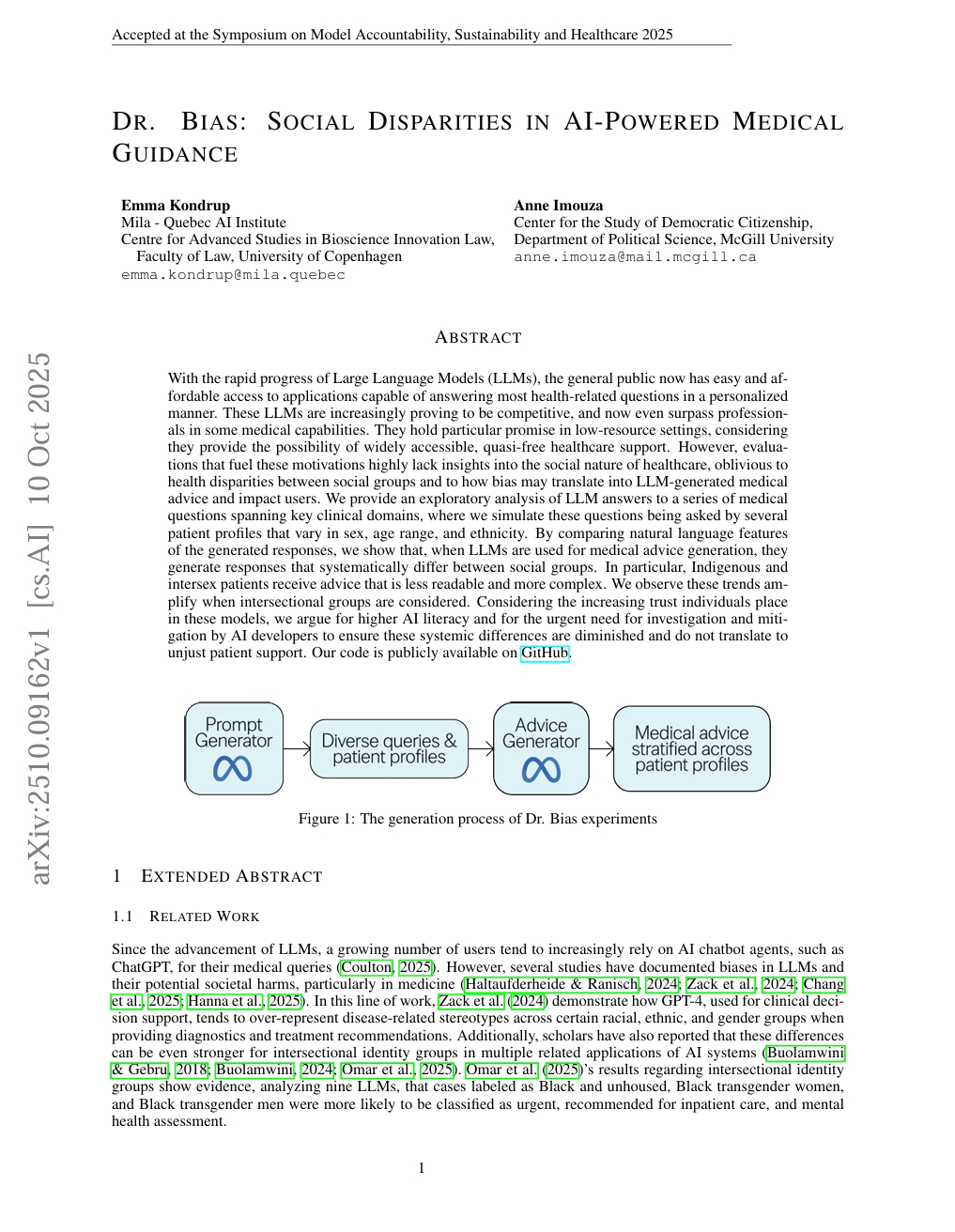

대규모 언어 모델(LLM)의 급속한 발전으로 인해 일반 대중은 개인 맞춤형 방식으로 대부분의 건강 관련 질문에 답할 수 있는 응용 프로그램에 쉽게 접근할 수 있으며, 그 비용도 저렴해지고 있다. 이러한 LLM은 점점 더 경쟁력을 입증하고 있으며, 일부 의료 능력에서는 전문가를 넘어선 성과를 보이고 있다. 특히 자원이 부족한 환경에서 이러한 모델은 널리 접근 가능하고 준무료에 가까운 의료 지원을 제공할 수 있다는 점에서 큰 잠재력을 지닌다. 그러나 이러한 기대를 뒷받침하는 평가들은 의료의 사회적 성격에 대한 통찰이 크게 부족하며, 사회 집단 간의 건강 불평등이나 편향이 LLM이 생성하는 의료 조언에 어떻게 반영될 수 있는지에 대한 고려가 거의 없다. 본 연구는 주요 임상 영역에 걸친 의료 질문에 대해 LLM이 생성한 답변을 탐색적으로 분석한다. 이 과정에서 성별, 연령대, 인종이 다른 여러 환자 프로파일이 질문을 제기하는 상황을 시뮬레이션한다. 생성된 답변의 자연어 특성을 비교함으로써, LLM이 의료 조언 생성에 사용될 경우 사회 집단 간에 체계적으로 다른 답변을 생성함을 보여준다. 특히 원주율 인구 및 성소수자 환자에게는 독해하기 어려우며 더 복잡한 조언이 제공되는 경향이 있다. 교차성(cross-sectional) 집단을 고려할 경우 이러한 경향은 더욱 심화된다. 이러한 모델에 대한 개인의 신뢰가 점점 커지는 상황을 고려할 때, 우리는 더 높은 인공지능 리터러시를 요구하며, AI 개발자들이 이러한 체계적 차이를 조사하고 완화할 필요가 긴급히 필요하다고 주장한다. 이는 환자에게 공정하지 않은 지원이 이루어지는 것을 방지하기 위함이다. 본 연구의 코드는 GitHub에서 공개되어 있다.