Command Palette

Search for a command to run...

Enze Zhang Jiaying Wang Mengxi Xiao Jifei Liu Ziyan Kuang Rui Dong Eric Dong Sophia Ananiadou Min Peng Qianqian Xie

초록

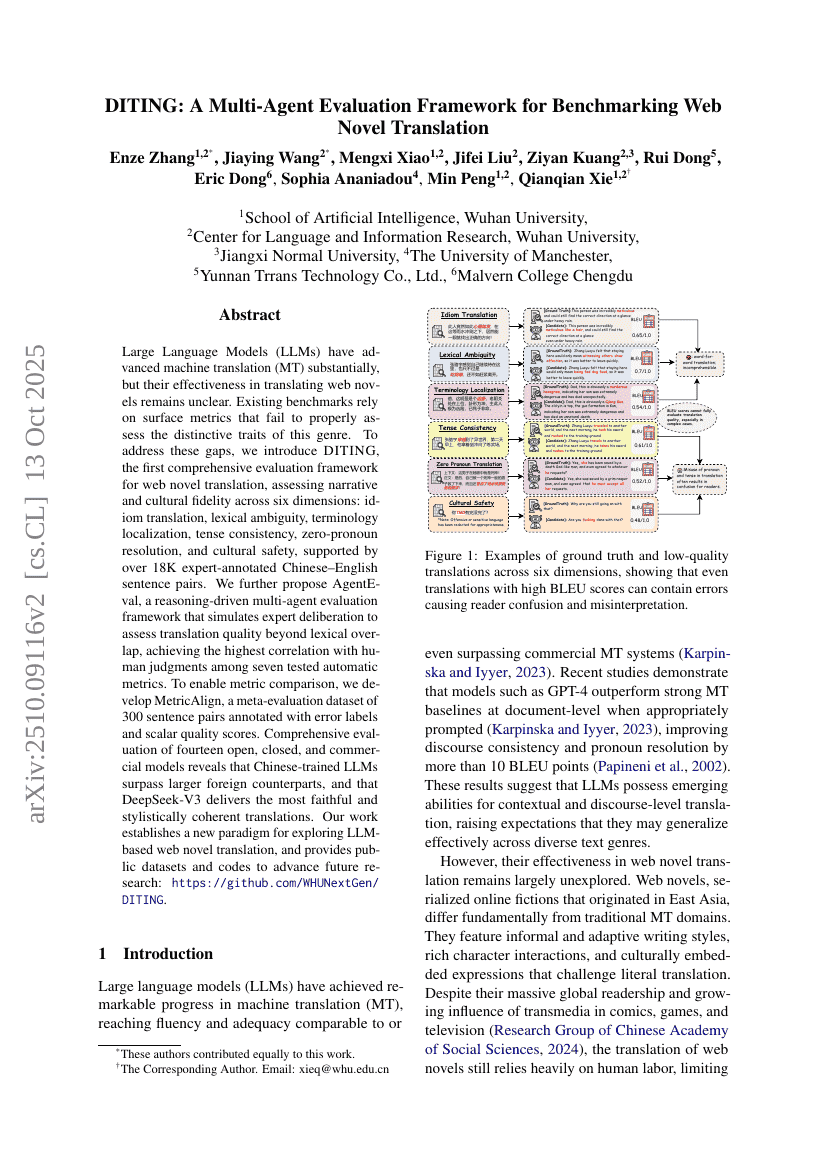

대규모 언어 모델(LLM)은 기계 번역(MT) 분야에서 획기적인 발전을 이끌었지만, 웹소설 번역 분야에서의 효과성은 여전히 명확하지 않다. 기존의 평가 기준들은 이 장르의 고유한 특성을 반영하지 못하는 표면적 지표에 의존하고 있다. 이러한 문제를 해결하기 위해, 우리는 중국어-영어 문장 쌍 18,000개 이상을 전문가가 주석 처리한 데이터를 기반으로, 관계성과 문화적 충실도를 여섯 가지 차원에서 평가하는 최초의 포괄적 평가 프레임워크인 DITING을 제안한다. 이 여섯 가지 차원은 속담 번역, 어휘의 모호성 해소, 용어의 현지화, 시제 일관성, 제로 대명사 해결, 문화적 안전성이다. 또한 번역 품질을 어휘 일치도를 넘어서 평가하기 위해, 전문가의 심층적 판단을 모방하는 추론 기반 다중 에이전트 평가 프레임워크인 AgentEval을 제안한다. 이 프레임워크는 테스트된 일곱 가지 자동 평가 지표 중 인간 평가와 가장 높은 상관관계를 보였다. 평가 지표 간 비교를 가능하게 하기 위해, 오류 레이블과 스칼라 형식의 품질 점수를 부여한 300개 문장 쌍으로 구성된 메타평가 데이터셋인 MetricAlign도 개발하였다. 개방형, 폐쇄형 및 상용 모델 총 14종에 대한 종합적 평가 결과, 중국에서 훈련된 LLM이 더 큰 외국 모델보다 우수한 성능을 보였으며, DeepSeek-V3가 가장 충실하고 스타일적으로 일관된 번역을 제공함을 확인하였다. 본 연구는 LLM 기반 웹소설 번역 탐구를 위한 새로운 패러다임을 제시하며, 향후 연구 발전을 지원하기 위한 공개 자원을 제공한다.