Command Palette

Search for a command to run...

초록

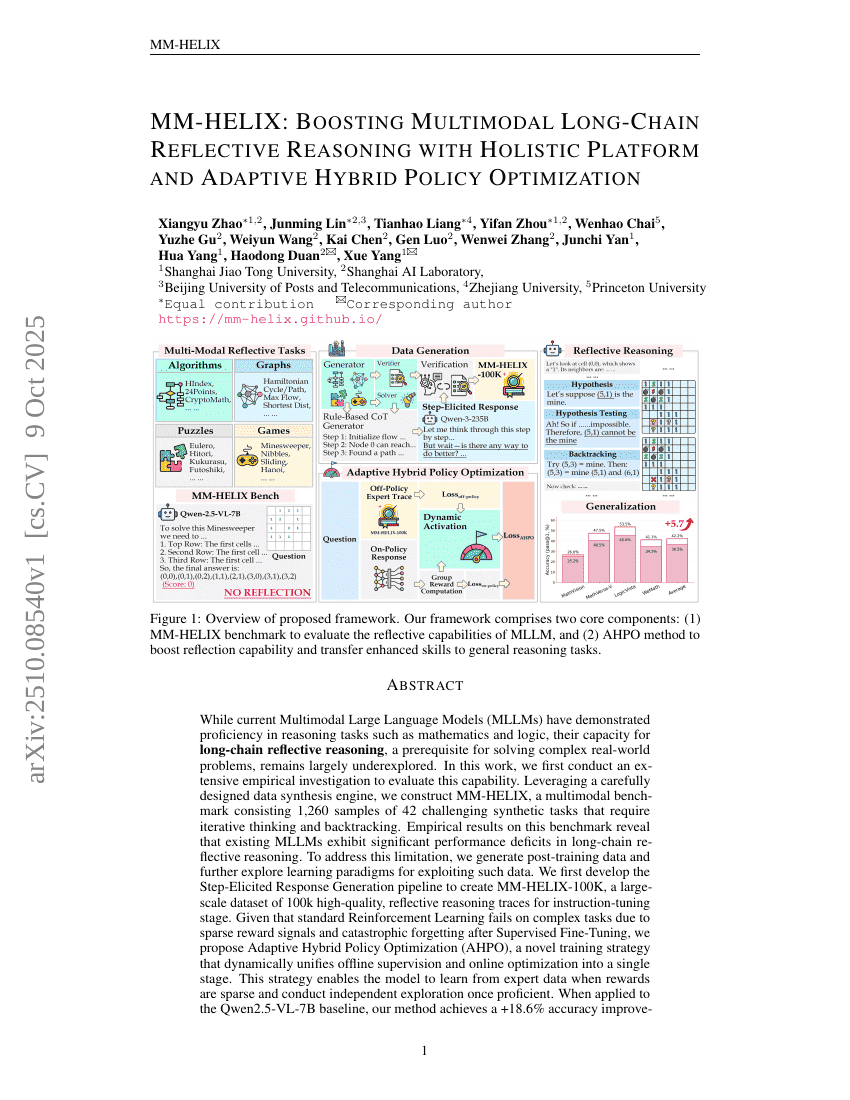

현재의 다중모달 대규모 언어 모델(Multimodal Large Language Models, MLLMs)은 수학 및 논리와 같은 추론 과제에서 뛰어난 성능을 보여주고 있으나, 복잡한 실세계 문제를 해결하기 위한 전제 조건인 장쇄 반성적 추론(long-chain reflective reasoning) 능력에 대한 연구는 여전히 부족한 실정이다. 본 연구에서는 이를 평가하기 위해 광범위한 실증적 조사를 수행한다. 정교하게 설계된 데이터 합성 엔진을 활용하여, 반복적 사고와 되돌아보기(backtracking)를 요구하는 42개의 도전적인 합성 과제를 포함한 1,260개의 샘플로 구성된 다중모달 벤치마크인 MM-HELIX를 구축한다. 이 벤치마크에서의 실증 결과는 기존 MLLMs가 장쇄 반성적 추론에서 심각한 성능 저하를 보임을 시사한다. 이러한 한계를 극복하기 위해, 사후 훈련 데이터를 생성하고, 그러한 데이터를 효과적으로 활용할 수 있는 학습 패러다임을 탐구한다. 먼저, 지시어 훈련 단계를 위한 고품질의 반성적 추론 트레이스 10만 개를 포함하는 대규모 데이터셋 MM-HELIX-100K를 생성하기 위해 ‘스텝 유도 응답 생성(Step-Elicited Response Generation)’ 파이프라인을 개발한다. 표준 강화학습은 감독 미세조정 이후의 치명적인 망각(catastrophic forgetting)과 복잡한 과제에서 희박한 보상 신호로 인해 성능이 저하되는 문제를 겪는다. 이를 해결하기 위해, 오프라인 지도 학습과 온라인 최적화를 동적으로 통합하는 단일 단계로 운영하는 새로운 훈련 전략인 적응형 하이브리드 정책 최적화(Adaptive Hybrid Policy Optimization, AHPO)를 제안한다. 이 전략은 보상 신호가 희박할 때 전문가 데이터로부터 학습할 수 있도록 하며, 모델이 충분히 숙련된 이후에는 독립적인 탐색을 수행할 수 있도록 한다. Qwen2.5-VL-7B 기준 모델에 적용한 결과, MM-HELIX 벤치마크에서 정확도가 +18.6% 향상되었으며, 일반 수학 및 논리 과제에서 평균 +5.7%의 성능 향상을 보이며 강력한 일반화 능력을 입증하였다. 본 연구는 MLLMs에서 반성적 추론이 효과적으로 학습되고 일반화될 수 있음을 보여주며, 더 강력한 MLLMs 개발을 위한 길을 열었다.