비디오-LMM 후기훈련: 대규모 다중모달 모델을 활용한 비디오 추론에 대한 심층 분석

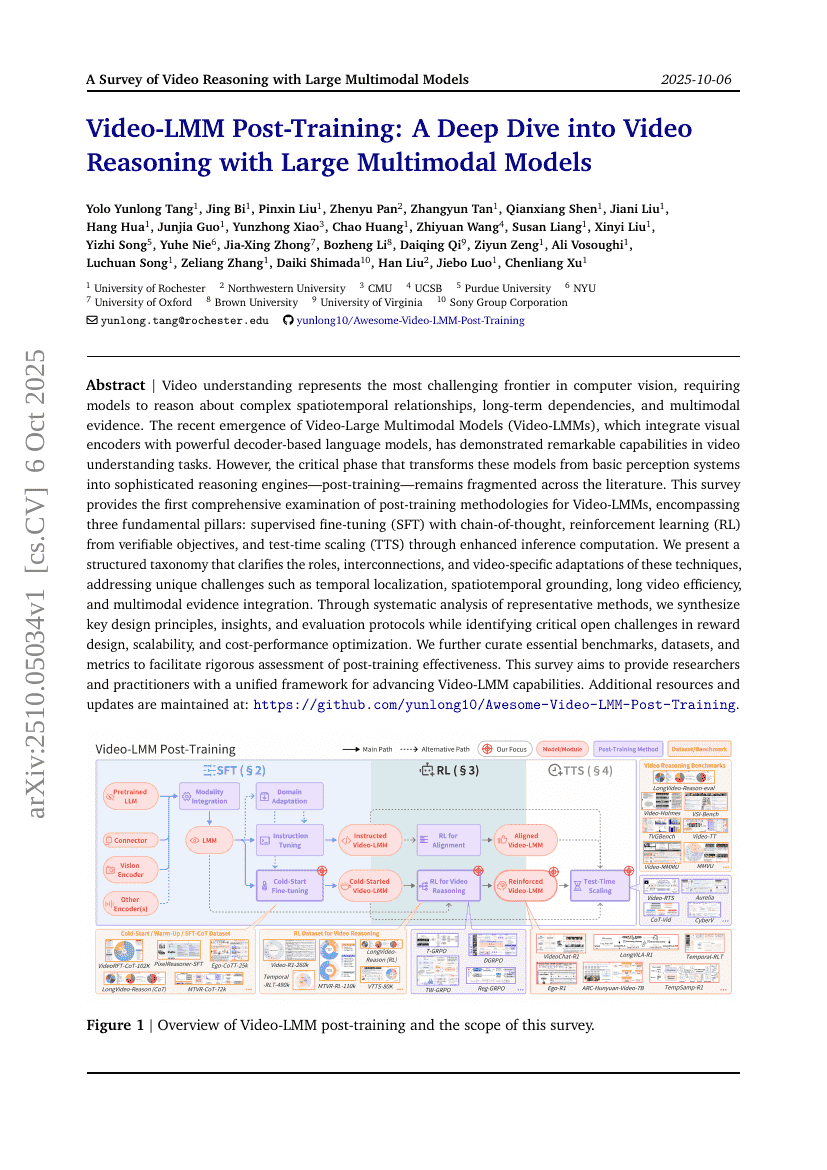

비디오 이해는 컴퓨터 비전 분야에서 가장 도전적인 연구 영역으로, 복잡한 시공간 관계, 장기적 의존성, 다중 모달 증거를 통합적으로 이해하고 추론해야 하는 요구를 포함한다. 최근 시각적 인코더와 강력한 디코더 기반 언어 모델을 통합한 비디오 대규모 다중모달 모델(Video-Large Multimodal Models, Video-LMMs)이 등장하면서, 비디오 이해 과제에서 놀라운 성능을 보여주고 있다. 그러나 이러한 모델을 단순한 인지 시스템에서 고도화된 추론 엔진으로 전환하는 핵심 단계인 사후 훈련(post-training)은 기존 문헌에서 여전히 분산되고 통합되지 않은 상태이다. 본 조사에서는 Video-LMMs의 사후 훈련 방법론에 대해 최초로 종합적인 분석을 제공하며, 세 가지 핵심 요소를 포함한다: 사고의 흐름(Chain-of-Thought)을 활용한 감독 기반 미세조정(Supervised Fine-Tuning, SFT), 검증 가능한 목표로부터의 강화학습(Reinforcement Learning, RL), 그리고 향상된 추론 계산을 통한 테스트 시각적 확장(Test-Time Scaling, TTS). 우리는 이러한 기법들의 역할, 상호 연결성, 비디오 특화된 적응 방식을 명확히 정리한 체계적인 분류 체계를 제시하며, 시간적 위치 추정(Temporal Localization), 시공간 기반(Visual Grounding), 긴 비디오 처리 효율성, 다중 모달 증거 통합 등 고유한 과제들을 다룬다. 주요 대표적 방법들을 체계적으로 분석함으로써, 핵심 설계 원칙, 통찰, 평가 프로토콜을 종합하고, 보상 설계, 확장성, 비용-성능 최적화 측면에서 중요한 미해결 과제들을 도출한다. 또한 사후 훈련 효과를 철저히 평가할 수 있도록 핵심 벤치마크, 데이터셋, 평가 지표를 체계적으로 정리하였다. 본 조사는 연구자와 실무자들이 Video-LMM의 능력을 지속적으로 향상시키기 위한 통합적인 프레임워크를 제공하는 것을 목표로 한다. 추가 자료 및 최신 정보는 아래 링크에서 지속적으로 업데이트된다:https://github.com/yunlong10/Awesome-Video-LMM-Post-Training