Command Palette

Search for a command to run...

Tianyu Fu Zihan Min Hanling Zhang Jichao Yan Guohao Dai Wanli Ouyang Yu Wang

초록

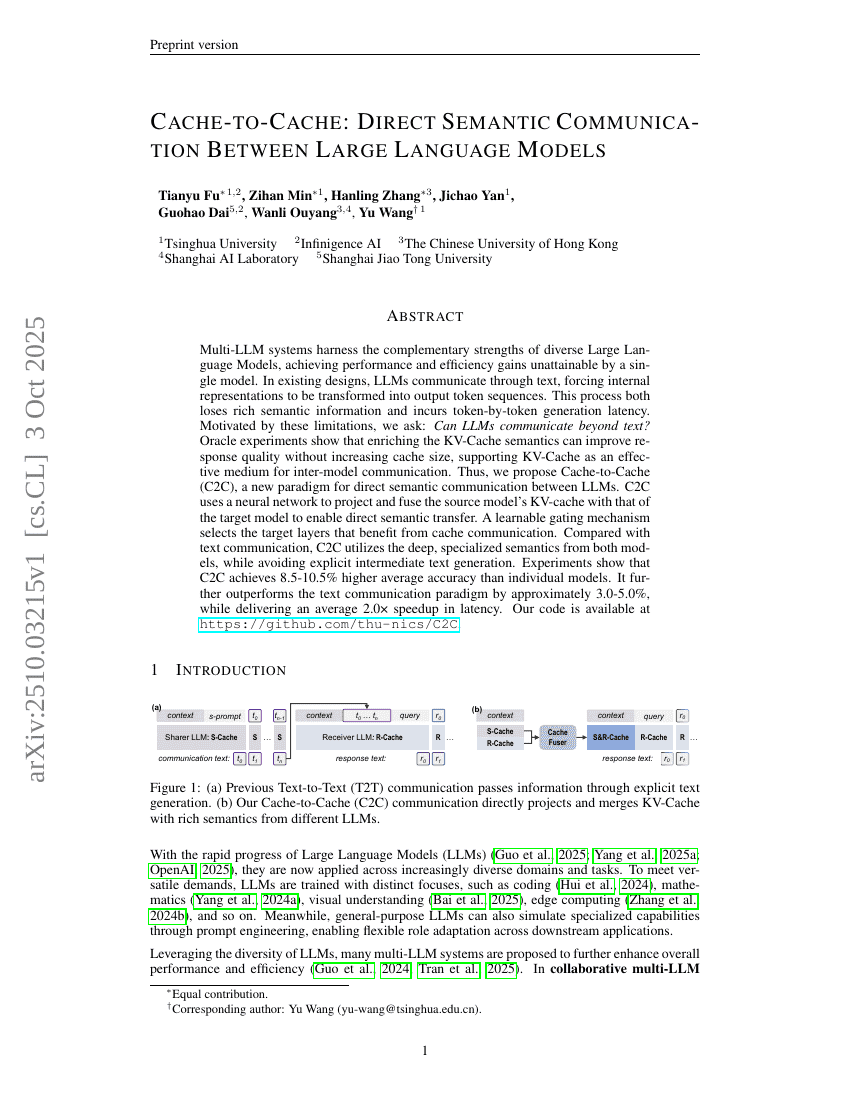

다중 대규모 언어 모델(Multi-LLM) 시스템은 다양한 대규모 언어 모델(LLM)의 상호보완적 강점을 활용하여, 단일 모델로는 달성할 수 없는 성능 및 효율성 향상을 실현한다. 기존 설계에서는 LLM 간 통신이 텍스트를 통해 이루어지며, 이로 인해 내부 표현이 출력 토큰 시퀀스로 변환되어야 한다. 이 과정은 � бог rich한 의미 정보의 손실을 초래할 뿐만 아니라, 토큰 단위 생성 지연(latency)을 유발한다. 이러한 한계에 착안하여 우리는 다음과 같은 질문을 제기한다: LLM은 텍스트를 넘어서 다른 방식으로 소통할 수 있는가? 오라클 실험을 통해 KV-Cache의 의미적 표현을 풍부하게 함으로써 캐시 크기를 증가시키지 않으면서도 응답 품질을 향상시킬 수 있음을 확인하였으며, 이는 KV-Cache가 모델 간 통신에 효과적인 매개체가 될 수 있음을 뒷받침한다. 이를 바탕으로 우리는 LLM 간 직접적인 의미 소통을 가능하게 하는 새로운 패러다임인 '캐시-투-캐시(Cache-to-Cache, C2C)'를 제안한다. C2C는 신경망을 활용해 소스 모델의 KV-Cache를 타겟 모델의 KV-Cache와 투사하고 융합함으로써 직접적인 의미 전달을 실현한다. 학습 가능한 게이팅 메커니즘을 통해 통신이 유익한 타겟 레이어를 자동 선택한다. 기존의 텍스트 기반 통신 방식과 비교해 C2C는 양 모델의 깊이 있고 전문화된 의미 정보를 효율적으로 활용하면서도 중간 텍스트 생성 과정을 명시적으로 피한다. 실험 결과, C2C는 개별 모델보다 평균 정확도에서 8.5~10.5% 향상되었으며, 텍스트 기반 통신 방식보다 약 3.0~5.0% 높은 성능을 기록하면서도 평균 2.0배의 지연 시간 감소를 달성하였다. 관련 코드는 https://github.com/thu-nics/C2C 에 공개되어 있다.