Command Palette

Search for a command to run...

초록

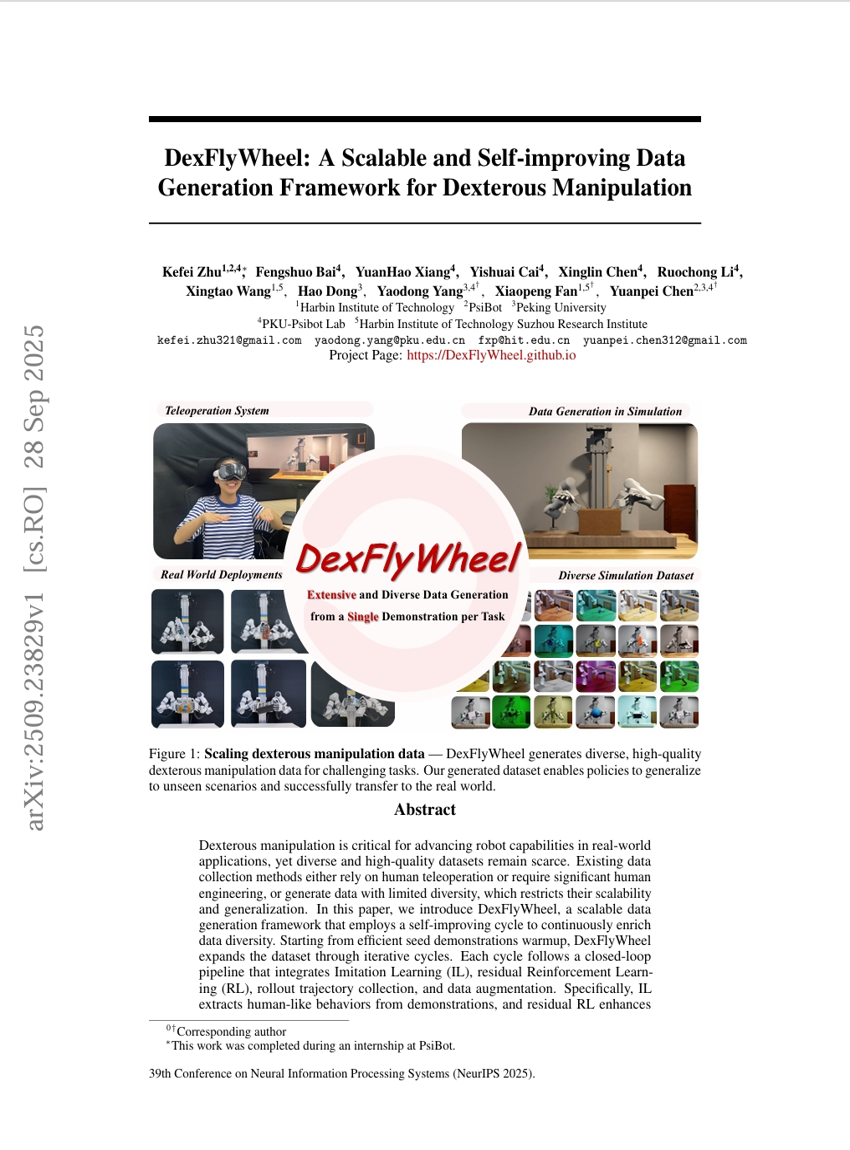

다재다능한 조작 능력은 로봇이 실제 환경에서의 응용을 발전시키는 데 핵심적인 요소이지만, 다양한 고품질 데이터셋은 여전히 부족한 실정이다. 기존의 데이터 수집 방법은 인간의 원격 조작에 의존하거나 상당한 인간의 엔지니어링을 필요로 하며, 또는 다양성이 제한된 데이터를 생성하기 때문에 확장성과 일반화 능력에 한계가 있다. 본 논문에서는 자가 개선 주기(bootstrapping cycle)를 활용하여 데이터 다양성을 지속적으로 풍부화하는 확장 가능한 데이터 생성 프레임워크인 DexFlyWheel을 제안한다. 효율적인 시드(Seed) 시연 데이터를 기반으로 시작하여, DexFlyWheel은 반복적인 주기적 과정을 통해 데이터셋을 확장한다. 각 주기는 이식 학습(Imitation Learning, IL), 잔여 강화 학습(Residual Reinforcement Learning, RL), 전개 경로(rollout trajectory) 수집, 그리고 데이터 증강을 통합한 폐쇄형 루프 파이프라인을 따르며, 이는 반복적으로 데이터를 개선하는 자가 개선형 데이터 플라이휠 효과를 유도한다. 구체적으로, IL은 시연 데이터로부터 인간과 유사한 행동을 추출하고, 잔여 RL은 정책의 일반화 능력을 향상시킨다. 학습된 정책은 시뮬레이션 환경에서 경로를 생성하며, 다양한 환경 조건과 공간 구성을 통해 데이터를 추가로 증강한 후 다음 주기로 피드백된다. 반복적인 반복 과정을 거치면서, 다양한 시나리오를 포괄하는 데이터셋이 생성되며, 이는 정책 성능의 확장에 기여한다. 실험 결과, DexFlyWheel은 네 가지 도전적인 과제에서 2,000개 이상의 다양한 시연 데이터를 생성함을 입증하였다. 본 연구에서 생성한 데이터셋으로 훈련된 정책은 도전 과제 테스트 세트에서 평균 성공률 81.9%를 달성하였으며, 디지털 트윈을 통해 실제 환경으로의 전이도 성공적으로 수행되어 이중 암 리프트 과제에서 78.3%의 성공률을 기록하였다.