Command Palette

Search for a command to run...

초록

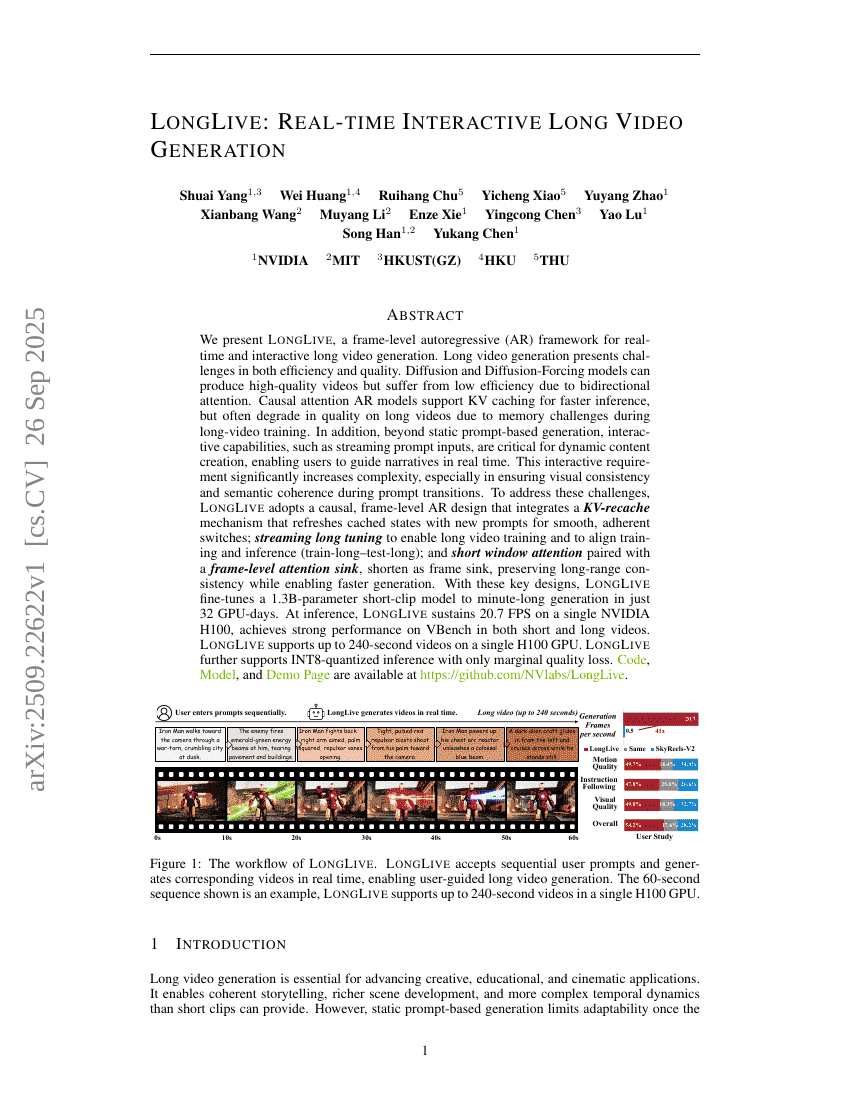

우리는 실시간 및 상호작용 가능한 장시간 영상 생성을 위한 프레임 단위 자동회귀(AR) 프레임워크인 LongLive를 제안한다. 장시간 영상 생성은 효율성과 품질 측면에서 모두 도전 과제를 안고 있다. 확산(.Diffusion) 및 확산-강제(Forcing) 모델은 높은 품질의 영상을 생성할 수 있지만, 양방향 어텐션(attention)으로 인해 효율성이 낮다는 한계가 있다. 반면, 인과적(-causal) 어텐션을 채택한 AR 모델은 키-값(KV) 캐싱을 지원해 추론 속도를 높일 수 있으나, 장시간 영상 학습 중 메모리 문제로 인해 품질이 저하되는 경향이 있다. 더불어, 정적 프롬프트 기반 생성을 넘어서, 스트리밍 방식의 프롬프트 입력과 같은 상호작용 기능은 동적인 콘텐츠 생성에 필수적이다. 사용자가 실시간으로 내러티브를 안내할 수 있도록 하여 창작의 유연성을 높인다. 그러나 이러한 상호작용 요구는 특히 프롬프트 전환 시 시각적 일관성과 의미적 흐름의 유지라는 측면에서 복잡성을 크게 증가시킨다.이러한 문제를 해결하기 위해 LongLive는 인과적 프레임 단위 AR 아키텍처를 채택하며, 새로운 프롬프트에 따라 캐시된 상태를 재갱신하는 KV-재캐싱(KV-recache) 메커니즘을 도입해 매끄럽고 일관된 전환을 가능하게 한다. 또한, 장시간 영상 학습을 지원하는 스트리밍 긴 조정(streaming long tuning) 기법을 통해 학습과 추론 간 일관성을 보장하며(학습-긴-추론-긴), 프레임 단위 어텐션 싱크(frame-level attention sink)와 짧은 윈도우 어텐션(short window attention)을 결합함으로써, 장거리 일관성을 유지하면서도 빠른 생성이 가능하도록 설계되었다. 이를 통해 프레임 싱크(frame sink)는 장기적인 시각적 흐름을 효과적으로 보존한다.이러한 핵심 설계를 바탕으로, LongLive는 13억 파라미터의 단일 클립 모델을 32개 GPU-일(GPU-days) 내에 분 단위의 장시간 영상 생성에 맞게 미세조정(fine-tune)할 수 있다. 추론 시에는 단일 NVIDIA H100 GPU에서 20.7 FPS를 유지하며, 짧은 영상과 긴 영상 모두에서 VBench 평가 지표에서 뛰어난 성능을 보였다. LongLive는 단일 H100 GPU에서 최대 240초 길이의 영상 생성을 지원하며, 정밀도 손실이 거의 없는 수준에서 INT8 양자화 추론도 가능하다.