Command Palette

Search for a command to run...

Nicolas Boizard Hippolyte Gisserot-Boukhlef Kevin El-Haddad Céline Hudelot Pierre Colombo

초록

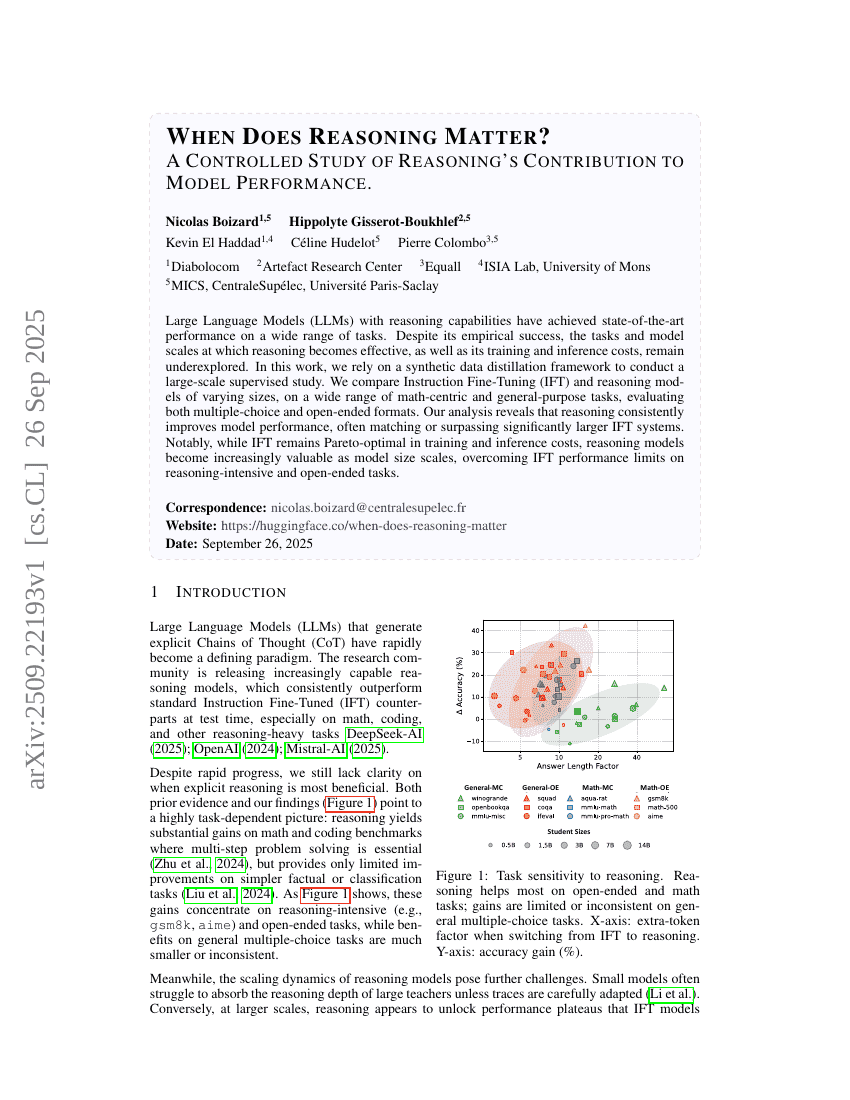

이해 능력을 갖춘 대규모 언어 모델(Large Language Models, LLMs)은 다양한 과제에서 최첨단 성능을 달성하고 있다. 비록 실험적으로 성공을 거두었지만, 추론이 효과를 발휘하는 과제 유형과 모델 규모, 그리고 학습 및 추론 비용에 대한 이해는 여전히 부족한 상태이다. 본 연구에서는 합성 데이터 정제(synthetic data distillation) 프레임워크를 활용하여 대규모 지도 학습 연구를 수행한다. 다양한 수학 중심 및 일반 목적 과제에 대해, 크기가 다른 지시어 미세조정(Instruction Fine-Tuning, IFT) 모델과 추론 모델을 비교 분석하며, 다지선다형과 개방형 형식을 모두 평가한다. 분석 결과, 추론 능력이 모델 성능을 일관되게 향상시키며, 종종 훨씬 더 큰 크기의 IFT 시스템을 능가하거나 근사함을 확인하였다. 특히, IFT는 학습 및 추론 비용 측면에서 여전히 파레토 최적(Pareto-optimal)을 유지하지만, 모델 규모가 커질수록 추론 모델의 가치가 점점 더 높아지며, 추론 중심 및 개방형 과제에서 IFT의 성능 한계를 극복하는 것으로 나타났다.