Command Palette

Search for a command to run...

초록

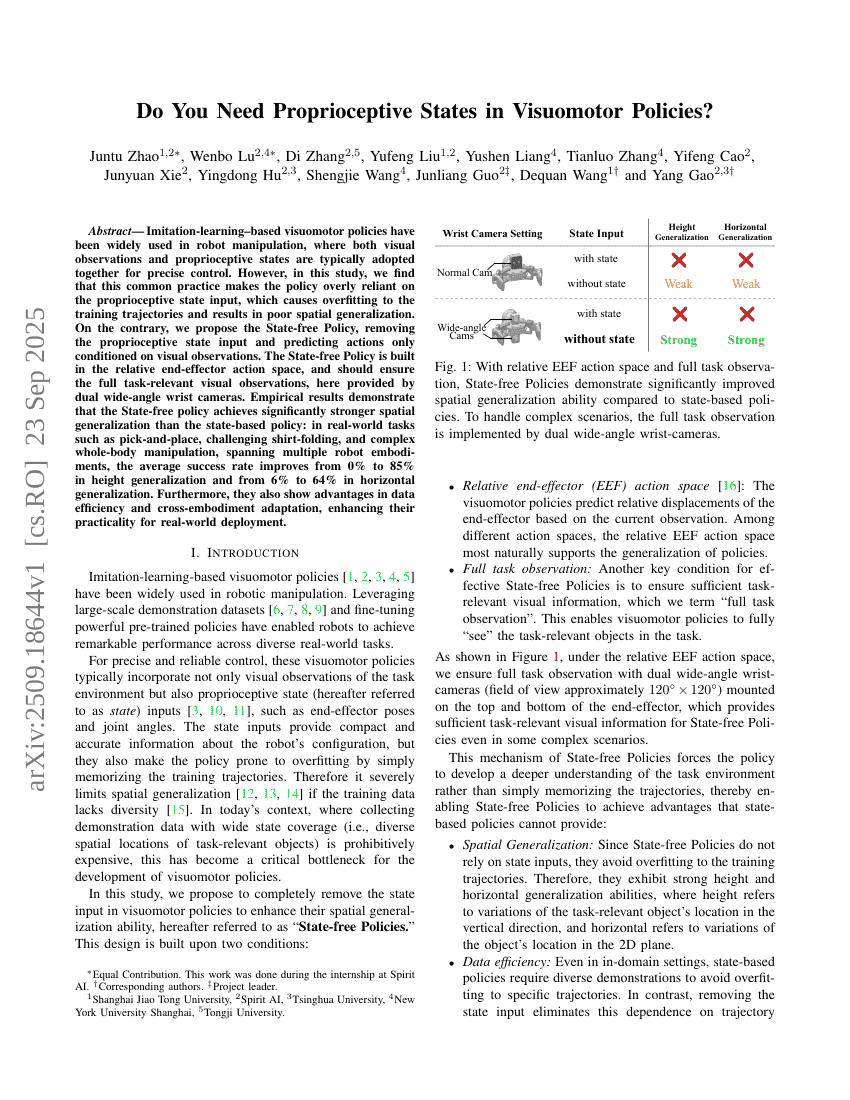

시각-운동 정책(Visuomotor policy)에 기반한 모사 학습(Imitation learning)은 로봇 조작 분야에서 널리 활용되고 있으며, 정밀한 제어를 위해 시각 관측값과 체내 감각 상태(proprioceptive state)를 함께 사용하는 것이 일반적이다. 그러나 본 연구에서는 이러한 일반적인 접근 방식이 정책(policy)이 체내 감각 상태 입력에 과도하게 의존하게 만들며, 이로 인해 학습 트랙토리에 과적합(overfitting)이 발생하고 공간적 일반화 성능이 저하된다는 점을 발견하였다. 반면에, 본 연구에서는 체내 감각 상태 입력을 제거하고 행동(action)을 오직 시각 관측값에 조건부로 예측하는 '상태 없는 정책(State-free Policy)'을 제안한다. 상태 없는 정책은 상대적 엔드 에프렉터 행동 공간(relative end-effector action space)에서 구축되며, 작업에 필요한 모든 시각 정보가 충분히 제공되어야 하며, 본 연구에서는 이 정보를 이중 광각 손목 카메라(dual wide-angle wrist cameras)를 통해 제공한다. 실험 결과에 따르면, 상태 없는 정책은 상태 기반 정책에 비해 공간적 일반화 성능이 크게 우수함을 입증하였다. 실제 환경에서의 작업, 예를 들어 피킹 앤 플레이스(pick-and-place), 어려운 셔츠 접기(shirt-folding), 복합적인 전신 조작(whole-body manipulation) 등 다양한 로봇 구현체에 걸쳐 평균 성공률이 높이 일반화에서 0%에서 85%로, 수평 일반화에서 6%에서 64%로 향상되었다. 또한, 데이터 효율성과 구현체 간 적응성(cross-embodiment adaptation)에서도 우수한 성능을 보였으며, 실세계 적용을 위한 실용성 또한 향상시켰다.