Command Palette

Search for a command to run...

Chuan Fang Heng Li Yixun Liang Jia Zheng Yongsen Mao Yuan Liu Rui Tang Zihan Zhou Ping Tan

초록

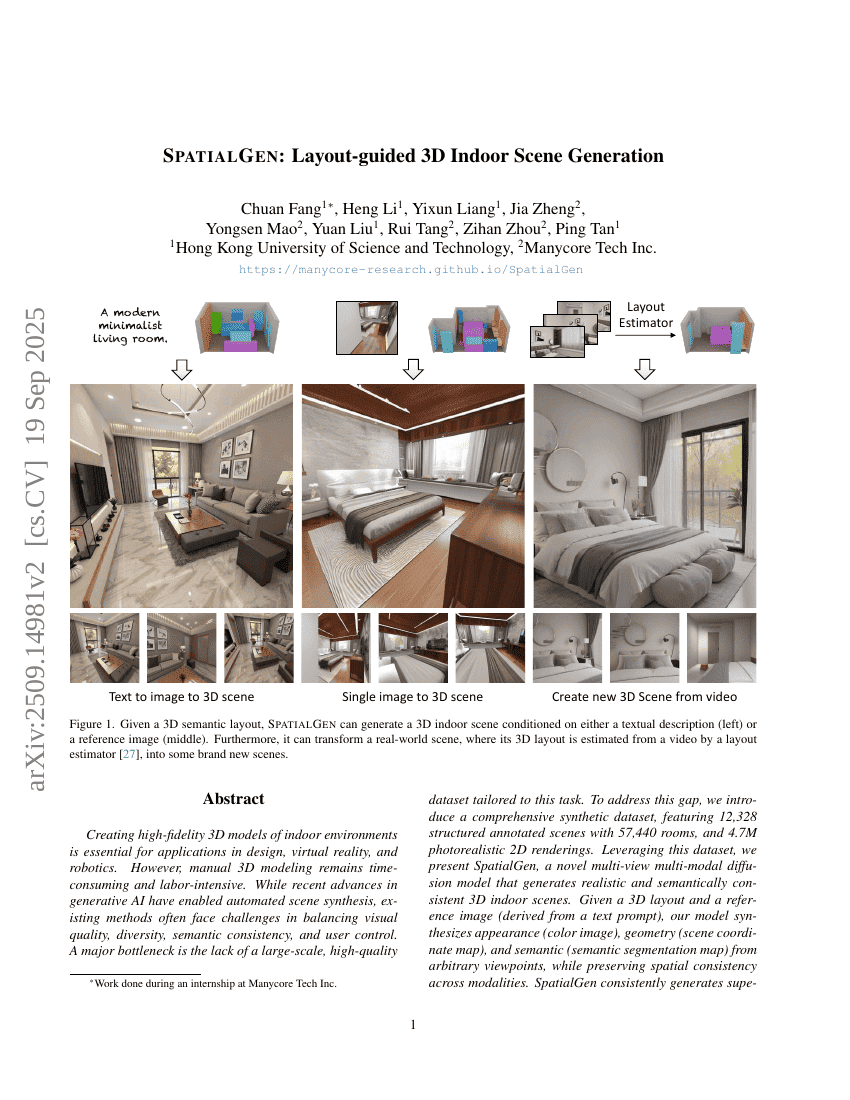

실내 환경의 고해상도 3D 모델을 생성하는 것은 설계, 가상현실, 로봇 공학 등 다양한 분야에서 필수적인 과제이다. 그러나 수작업을 통한 3D 모델링은 여전히 시간과 인력이 많이 소요되는 작업이다. 최근 생성형 AI의 발전으로 자동화된 장면 합성 기술이 가능해졌지만, 기존 방법들은 시각적 품질, 다양성, 의미론적 일관성, 사용자 제어성 간의 균형을 유지하는 데 어려움을 겪고 있다. 이 문제의 주요 장벽은 해당 작업에 특화된 대규모이고 고품질의 데이터셋이 부족한 점이다. 이러한 격차를 보완하기 위해, 12,328개의 구조화된 레이블링된 장면(57,440개의 실내 공간 포함)과 470만 장의 사진 수준의 실사적 2D 렌더링을 포함하는 포괄적인 합성 데이터셋을 제안한다. 이 데이터셋을 기반으로, 공간 일관성을 유지하면서 임의의 시점에서 외관(색상 이미지), 기하학(장면 좌표 맵), 의미론(의미 분할 맵)을 동시에 생성할 수 있는 새로운 다시고점 다중모달 확산 모델인 SpatialGen을 제시한다. 3D 레이아웃과 참조 이미지(텍스트 프롬프트에서 유도된)를 입력으로 받으면, 모델은 다양한 시점에서 현실감 있고 의미론적으로 일관된 3D 실내 장면을 합성한다. 실험 결과, 기존 방법들에 비해 SpatialGen은 일관되게 우수한 성능을 보였다. 본 연구에서는 데이터와 모델을 오픈소스로 공개하여 연구 공동체의 역량을 강화하고, 실내 장면 이해 및 생성 분야의 발전을 촉진하고자 한다.