SAIL-VL2 기술 보고서

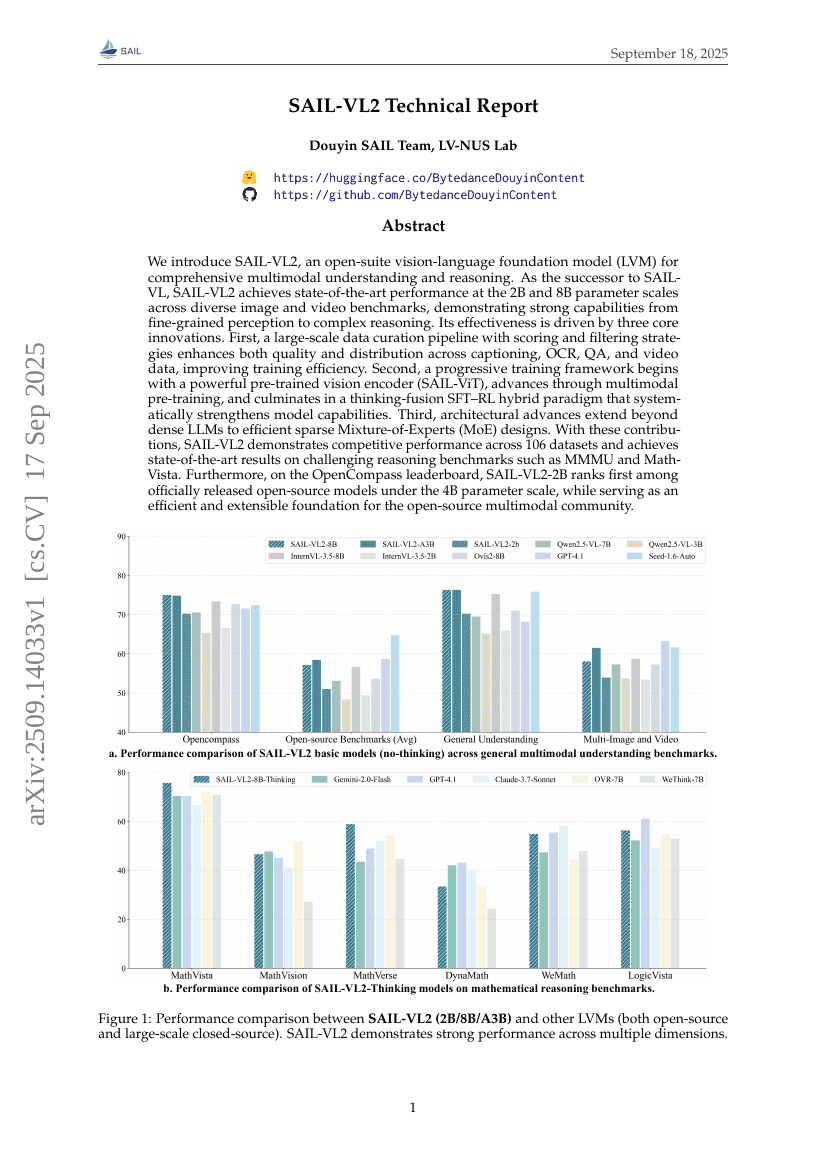

우리는 종합적인 다중모달 이해 및 추론을 위한 오픈형 시각-언어 기초 모델(SAIL-VL2)을 소개한다. SAIL-VL의 후속 모델인 SAIL-VL2는 다양한 이미지 및 영상 벤치마크에서 2B 및 8B 파라미터 규모에서 최고 수준의 성능을 달성하며, 세부적인 인지에서 복잡한 추론에 이르기까지 강력한 능력을 입증한다. 이 모델의 효과성을 이끄는 세 가지 핵심 혁신이 있다. 첫째, 캡션 생성, OCR, 질의응답(QA), 영상 데이터 등 다양한 데이터 유형에 대해 점수 산정 및 필터링 전략을 적용한 대규모 데이터 정제 파이프라인을 도입하여 데이터의 품질과 분포를 향상시켰으며, 이는 훈련 효율성을 높이는 데 기여한다. 둘째, 강력한 사전 훈련된 시각 인코더(SAIL-ViT)로 시작하여 다중모달 사전 훈련을 거치고, 마지막으로 사고 융합(SFT-RL 하이브리드) 파라다임으로 이어지는 점진적 훈련 프레임워크를 도입함으로써 모델의 능력을 체계적으로 강화한다. 셋째, 밀집형 대규모 언어 모델(LLM)을 넘어서 효율적인 희소형 전문가 혼합(Mixture-of-Experts, MoE) 아키텍처 설계를 도입하여 성능과 효율성을 동시에 확보한다. 이러한 기여를 바탕으로 SAIL-VL2는 106개의 데이터셋에서 경쟁력 있는 성능을 보이며, MMMU 및 MathVista와 같은 도전적인 추론 벤치마크에서도 최고 수준의 성과를 기록한다. 더불어 OpenCompass 랭킹에서 SAIL-VL2-2B는 공식적으로 발표된 4B 파라미터 규모 내에서 가장 높은 순위를 기록하며, 오픈소스 다중모달 커뮤니티를 위한 효율적이고 확장 가능한 기초 모델로서의 역할을 수행하고 있다.