Command Palette

Search for a command to run...

초록

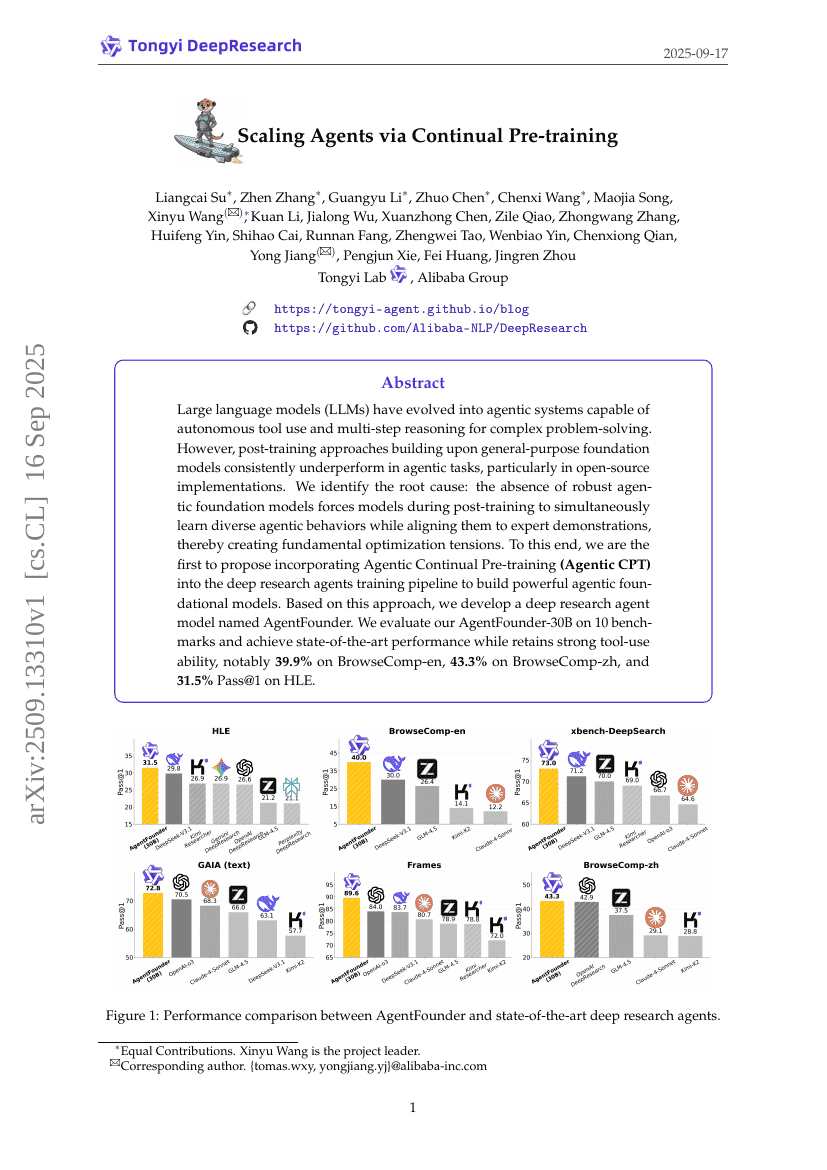

대규모 언어 모델(LLM)은 복잡한 문제 해결을 위한 자율적인 도구 사용과 다단계 추론이 가능한 에이전트 시스템으로 진화해왔다. 그러나 일반 목적의 기초 모델을 기반으로 하는 사후 훈련 방식은 에이전트 작업에서 지속적으로 성능이 부족한 편이며, 특히 오픈소스 구현에서 두드러진다. 본 연구에서는 그 근본 원인을 다음과 같이 규명한다: 견고한 에이전트 기초 모델의 부재로 인해 사후 훈련 과정에서 모델은 다양한 에이전트 행동을 동시에 학습하면서 전문가의 시범 데이터에 맞추는 작업을 수행하게 되어, 근본적인 최적화 갈등이 발생한다. 이를 해결하기 위해 우리는 처음으로 ‘에이전트 지속적 사전 훈련(Agentic Continual Pre-training, Agentic CPT)’을 심층 연구 에이전트 훈련 파이프라인에 통합하여 강력한 에이전트 기초 모델을 구축하는 방안을 제안한다. 본 연구 방법을 기반으로, 우리는 심층 연구 에이전트 모델인 AgentFounder를 개발하였다. 다양한 평가 기준 10개에서 AgentFounder-30B를 평가한 결과, 최신 기술 수준의 성능을 달성하면서도 강력한 도구 사용 능력을 유지하였으며, 특히 BrowseComp-en에서 39.9%, BrowseComp-zh에서 43.3%, HLE의 Pass@1에서 31.5%의 성능을 기록하였다.