LazyDrag: 다중 모달 확산 트랜스포머에서 명시적 대응을 통한 안정적인 드래그 기반 편집 가능하게 하기

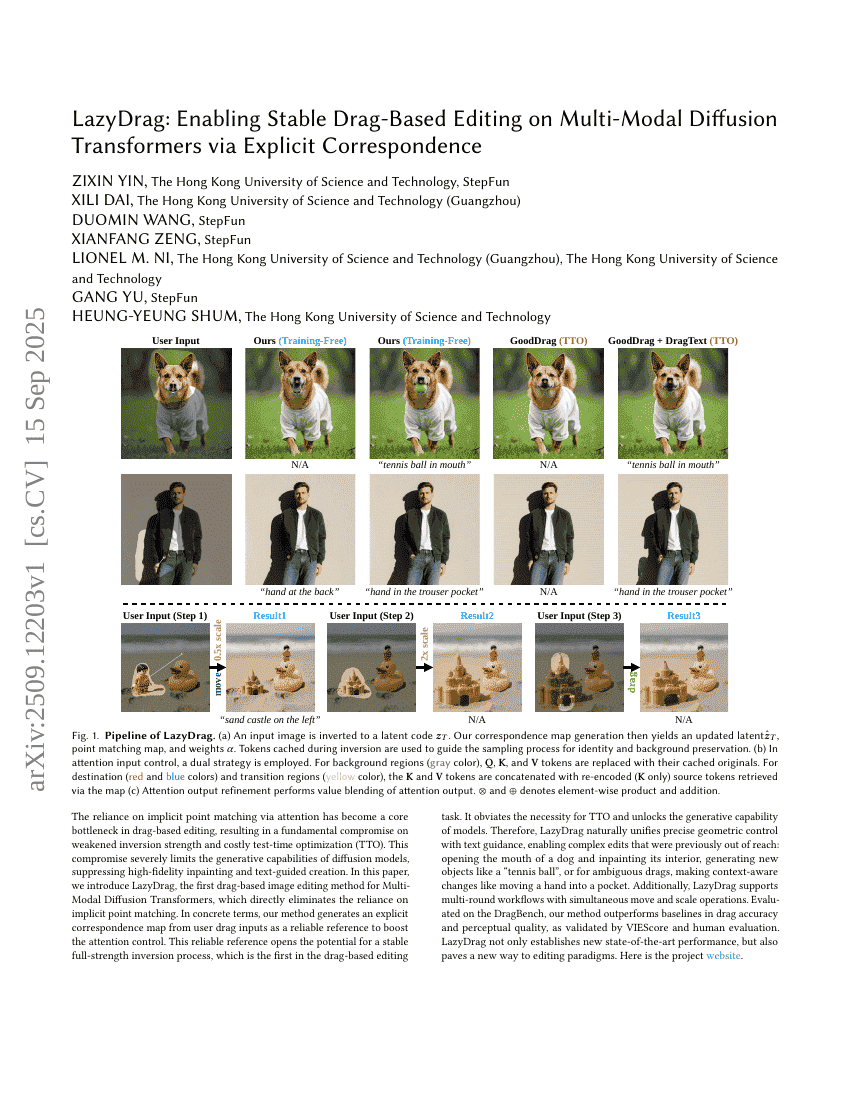

주의 깊게 드래그하는 방식의 이미지 편집 기술에서 어텐션을 통한 암묵적 점 매칭에 대한 의존은 핵심적인 성능 저하 요인이 되었으며, 이는 복원 강도의 약화와 고비용의 테스트 시점 최적화(Test-Time Optimization, TTO)라는 본질적인 타협을 초래한다. 이러한 타협은 확산 모델의 생성 능력을 심각하게 제한하며, 높은 정밀도의 이미지 보정(inpainting) 및 텍스트 기반 생성 기능을 억제한다. 본 논문에서는 다중 모달 확산 트랜스포머(Multi-Modal Diffusion Transformers)를 대상으로 한 최초의 드래그 기반 이미지 편집 방법인 LazyDrag을 제안한다. 이 방법은 암묵적 점 매칭에 대한 의존을 직접적으로 제거한다. 구체적으로, 사용자 드래그 입력으로부터 명시적인 대응 맵(explicit correspondence map)을 생성하여 어텐션 제어를 강화하는 신뢰할 수 있는 참조 자료로 활용한다. 이러한 신뢰할 수 있는 참조 자료는 드래그 기반 편집 작업에서 처음으로 안정적인 전력 최대화 복원 과정을 가능하게 하며, TTO의 필요성을 제거하고 모델의 생성 능력을 해방한다. 따라서 LazyDrag은 정밀한 기하학적 제어와 텍스트 가이드라인을 자연스럽게 통합하여, 이전에는 불가능했던 복잡한 편집을 가능하게 한다: 개의 입을 열고 내부를 보정하거나, "테니스 공"과 같은 새로운 객체를 생성하거나, 모호한 드래그에 대해서는 손을 주머니 안으로 옮기는 등 맥락 인식 기반의 변화를 수행할 수 있다. 더불어 LazyDrag는 동시에 이동과 확대를 수행할 수 있는 다회차 워크플로우를 지원한다. DragBench 기준으로 평가한 결과, VIEScore 및 사용자 평가를 통해 확인된 바와 같이, 본 방법은 기존 베이스라인 대비 드래그 정확도와 지각적 품질에서 뛰어난 성능을 보였다. LazyDrag은 단순히 새로운 최고 성능(SOTA)을 달성하는 것을 넘어서, 이미지 편집 패러다임에 새로운 길을 열었다.