Command Palette

Search for a command to run...

Jiahao Chen Zhiyuan Huang Yurou Liu Bing Su

초록

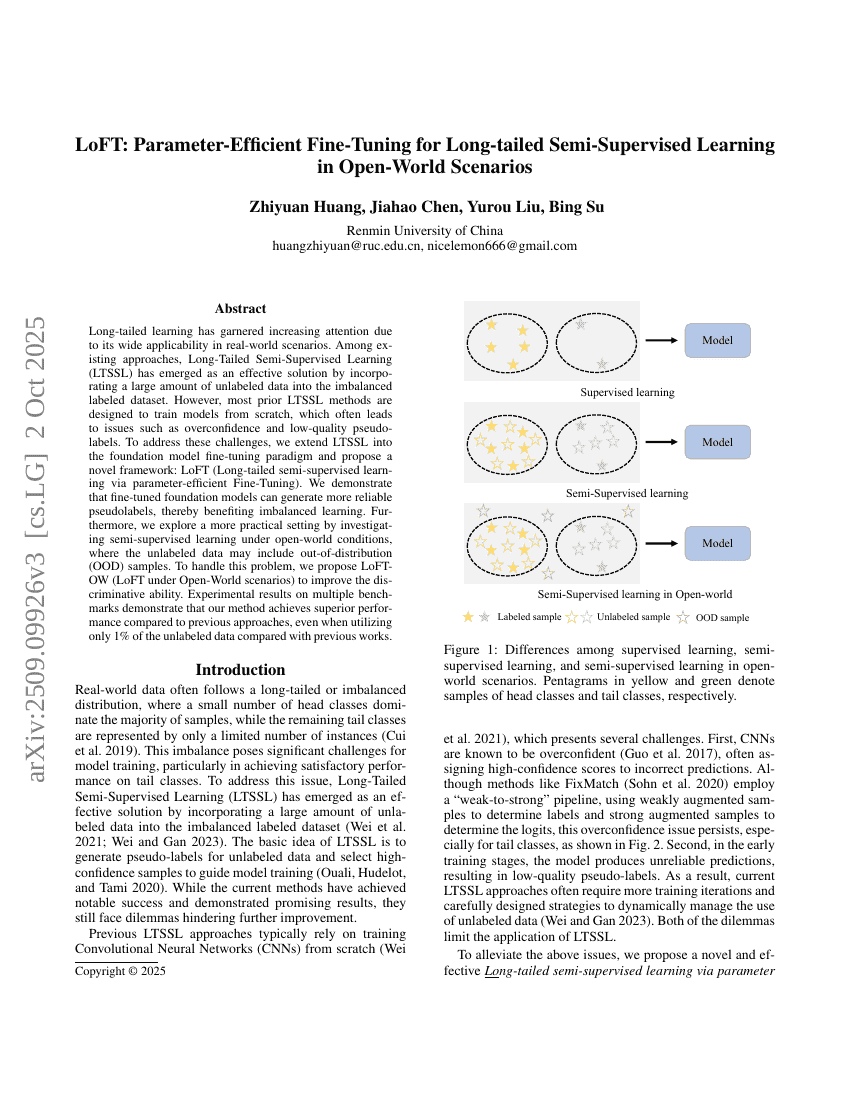

장꼬리 학습(long-tailed learning)은 현실 세계의 다양한 시나리오에 광범위하게 적용 가능하다는 점에서 점차 주목받고 있다. 기존의 접근 방식 중에서, 장꼬리 반감독 학습(Long-Tailed Semi-Supervised Learning, LTSSL)은 불균형한 레이블 데이터셋에 대량의 레이블이 없는 데이터를 통합함으로써 효과적인 해결책으로 부상하고 있다. 그러나 기존의 대부분의 LTSSL 기법은 모델을 처음부터 학습하는 데 초점이 맞춰져 있어, 과도한 자신감(overconfidence)과 낮은 품질의 가상 레이블(pseudo-labels) 등의 문제를 야기하는 경우가 많다. 이러한 문제를 해결하기 위해, 본 연구는 LTSSL을 기반 모델(foundation model)의 미세조정(fine-tuning) 패러다임으로 확장하고, 새로운 프레임워크인 LoFT(LoFT: Long-tailed semi-supervised learning via parameter-efficient Fine-Tuning)를 제안한다. 우리는 미세조정된 기반 모델이 더 신뢰할 수 있는 가상 레이블을 생성할 수 있음을 입증함으로써, 불균형 학습에 긍정적인 영향을 미친다는 점을 보여준다. 더 나아가, 레이블이 없는 데이터에 분포 외(out-of-distribution, OOD) 샘플이 포함될 수 있는 개방형 환경(open-world)에서의 반감독 학습이라는 보다 실용적인 설정을 탐구한다. 이 문제를 해결하기 위해, LoFT-OW(LoFT under Open-World scenarios)를 제안하여 모델의 구분 능력을 향상시킨다. 여러 벤치마크에서의 실험 결과를 통해, 기존 방법과 비교해 본 방법이 뛰어난 성능을 보임을 입증하였으며, 특히 이전 연구 대비 레이블이 없는 데이터의 1%만을 사용하는 조건에서도 뛰어난 결과를 달성함을 확인하였다.