Command Palette

Search for a command to run...

Zikang Guo Benfeng Xu Chiwei Zhu Wentao Hong Xiaorui Wang Zhendong Mao

초록

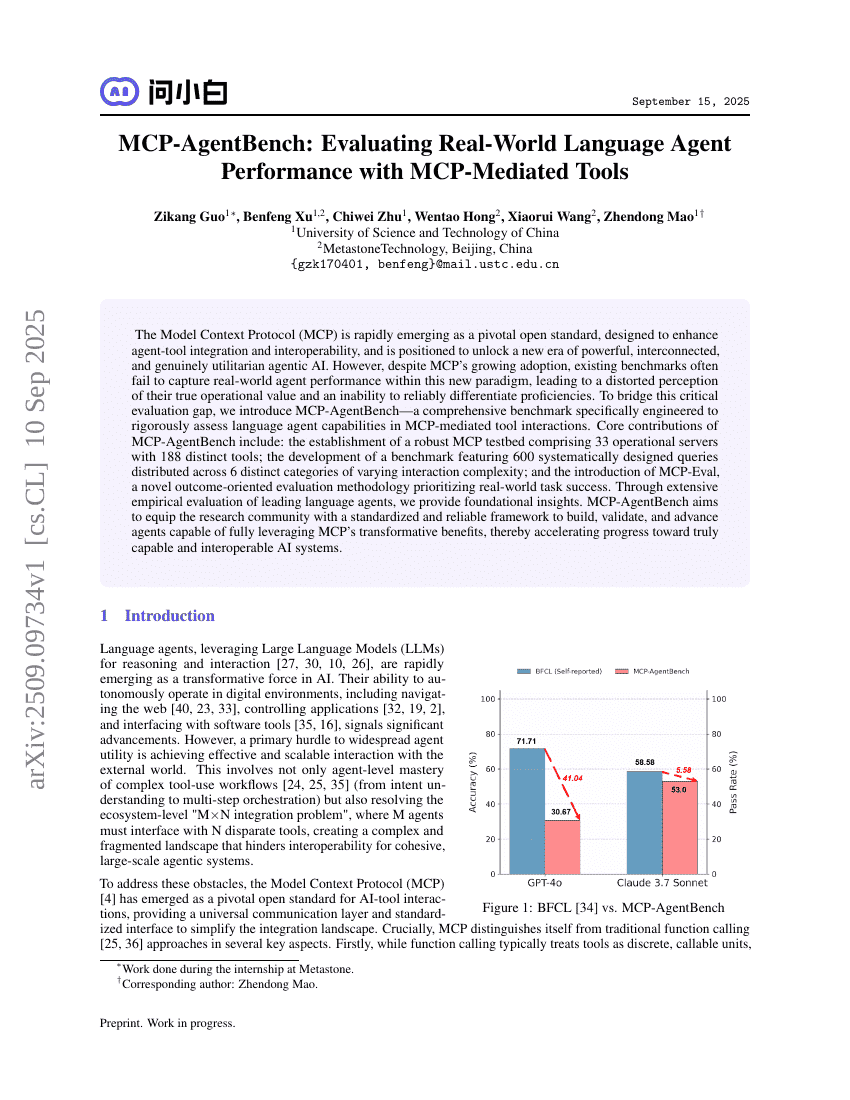

모델 컨텍스트 프로토콜(Model Context Protocol, MCP)은 에이전트-도구 통합과 상호운용성을 향상시키기 위해 설계된 핵심 오픈 표준으로 빠르게 부상하고 있으며, 강력하고 연결된, 진정으로 실용적인 에이전트형 AI의 새로운 시대를 여는 데 기여할 것으로 기대된다. 그러나 MCP의 채택이 확대되면서도 기존의 평가 기준들은 이 새로운 패러다임 내에서 에이전트의 실제 성능을 충분히 반영하지 못해, 그 진정한 운영적 가치에 대한 왜곡된 인식을 초래하고, 실력 차이를 신뢰성 있게 구분할 수 없는 상황이 발생하고 있다. 이러한 중요한 평가 격차를 메우기 위해, 우리는 MCP 기반 도구 상호작용 환경에서 언어형 에이전트의 능력을 체계적으로 평가할 수 있도록 설계된 종합적 벤치마크인 MCP-AgentBench를 제안한다. MCP-AgentBench의 주요 기여는 다음과 같다: 33개의 작동 서버와 188개의 다양한 도구로 구성된 견고한 MCP 테스트베드 구축; 6개의 상이한 상호작용 복잡도를 가진 범주에 걸쳐 체계적으로 설계된 600개의 질의를 포함한 벤치마크 개발; 그리고 실제 세계의 작업 성공을 우선시하는 결과 지향적 평가 방법론인 MCP-Eval의 도입. 주요 언어형 에이전트에 대한 광범위한 실험적 평가를 통해, 본 연구는 기초적인 통찰을 제시한다. MCP-AgentBench는 연구 공동체가 MCP의 변혁적 이점을 극대화할 수 있는 에이전트를 개발하고, 검증하며, 발전시킬 수 있도록 표준화되고 신뢰할 수 있는 평가 프레임워크를 제공함으로써, 진정으로 기능적이고 상호운용 가능한 AI 시스템 구현을 가속화하는 데 기여할 것이다.