Command Palette

Search for a command to run...

Mohsen Gholami Ahmad Rezaei Zhou Weimin Yong Zhang Mohammad Akbari

초록

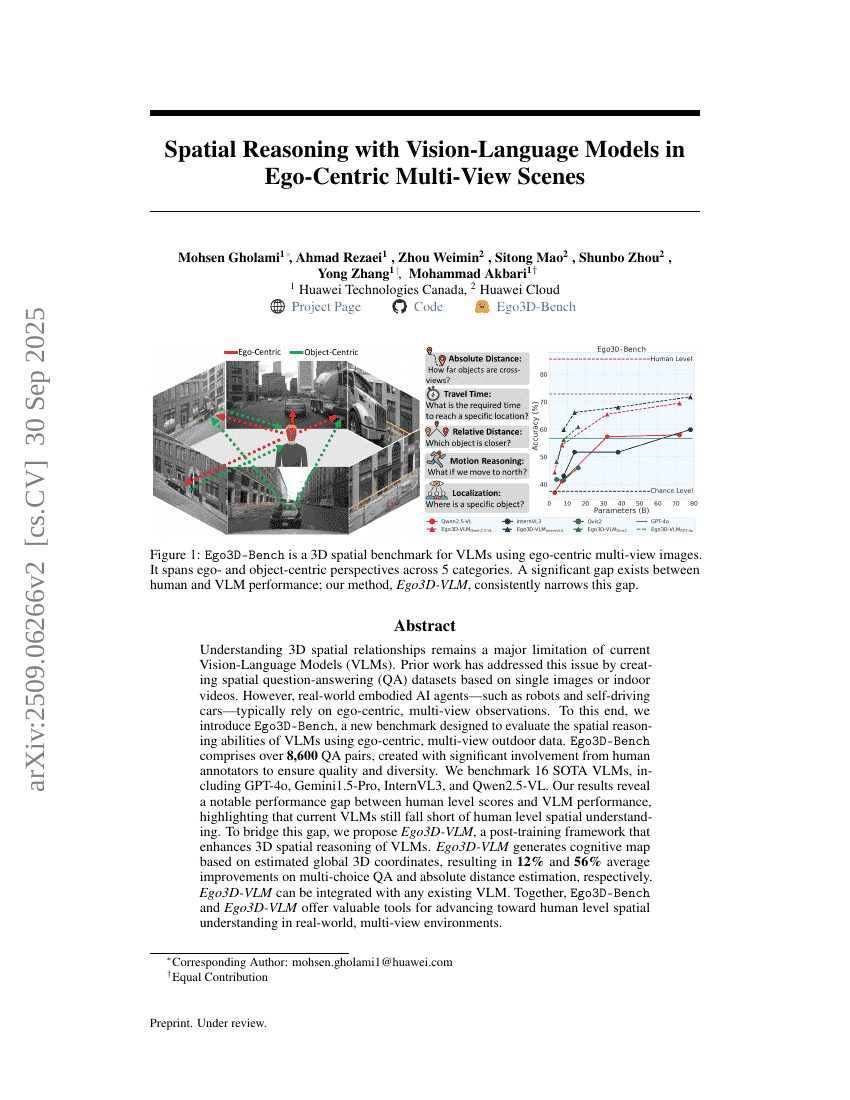

3D 공간적 관계를 이해하는 것은 현재의 시각-언어 모델(Vision-Language Models, VLMs)의 주요한 한계로 남아 있다. 기존 연구들은 단일 이미지 또는 실내 영상 기반의 공간적 질문-응답(QA) 데이터셋을 구축함으로써 이 문제를 다루어 왔다. 그러나 로봇이나 자율주행차와 같은 실제 환경에서 작동하는 몸체화된 AI 에이전트는 일반적으로 주관적(이고)이고 다중 시점의 관측에 의존한다. 이를 고려하여, 본 연구는 주관적이고 다중 시점의 실외 데이터를 활용하여 VLM의 공간적 추론 능력을 평가할 수 있도록 설계된 새로운 벤치마크인 Ego3D-Bench를 제안한다. Ego3D-Bench는 품질과 다양성을 보장하기 위해 인류의 광범위한 참여를 통해 생성된 8,600개 이상의 QA 쌍을 포함하고 있다. 우리는 GPT-4o, Gemini1.5-Pro, InternVL3, Qwen2.5-VL을 포함한 16개의 최신 VLM들을 평가하였으며, 그 결과 인간 수준 점수와 VLM의 성능 사이에 뚜렷한 격차가 있음을 확인하였다. 이는 현재의 VLM이 인간 수준의 공간적 이해에 여전히 부족함을 시사한다. 이러한 격차를 메우기 위해, 본 연구는 VLM의 3D 공간적 추론 능력을 향상시키는 후학습 프레임워크인 Ego3D-VLM을 제안한다. Ego3D-VLM은 추정된 전역 3D 좌표를 기반으로 인지 지도(cognitive map)를 생성하며, 다중 선택형 QA에서 평균 12% 향상, 절대 거리 추정에서 평균 56% 향상의 성과를 달성한다. Ego3D-VLM은 모듈형 구조를 지니고 있어 기존의 어떤 VLM과도 간편하게 통합이 가능하다. Ego3D-Bench와 Ego3D-VLM은 실세계의 다중 시점 환경에서 인간 수준의 공간적 이해를 향한 발전을 위한 유용한 도구를 제공한다.