Command Palette

Search for a command to run...

Daniel P. W. Ellis Eduardo Fonseca Ron J. Weiss Kevin Wilson Scott Wisdom et al

초록

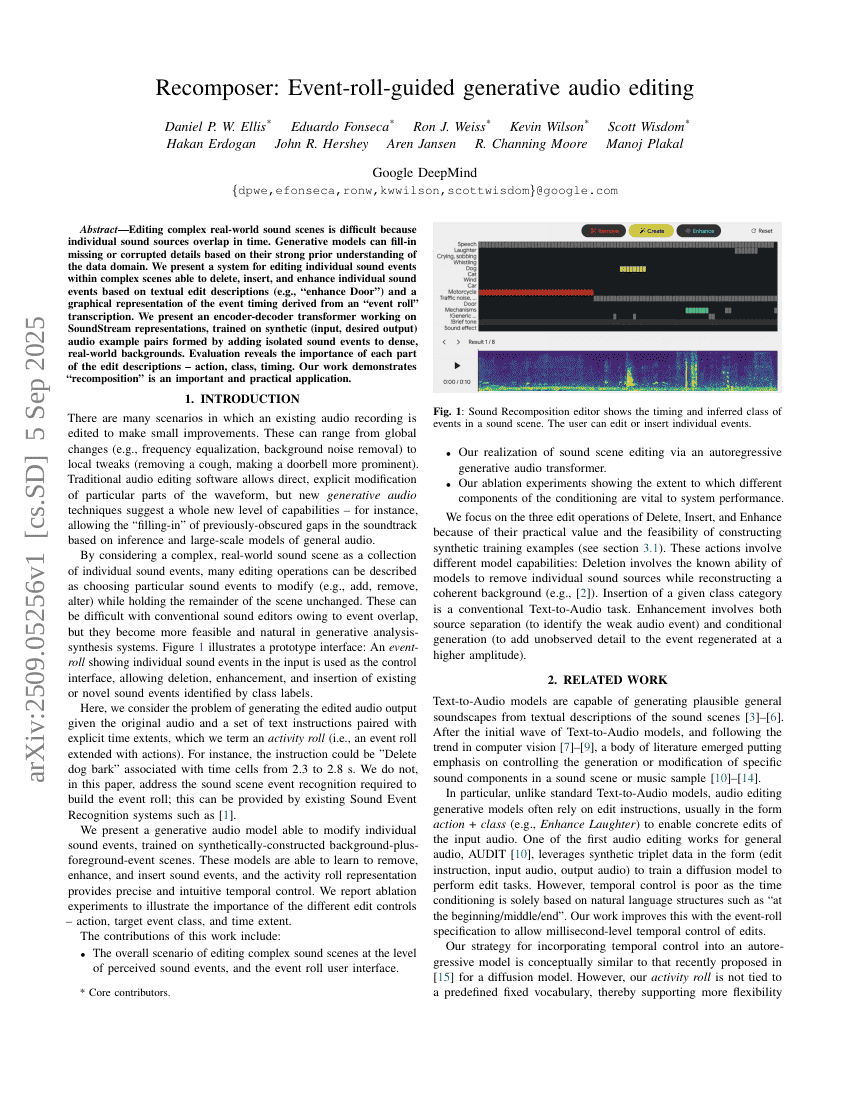

복잡한 실제 사운드 장면의 편집은 개별 사운드 소스가 시간적으로 겹치기 때문에 어려움이 있다. 생성형 모델은 데이터 도메인에 대한 강력한 사전 지식을 바탕으로 누락되거나 손상된 세부 정보를 보완할 수 있다. 본 연구에서는 텍스트 기반 편집 설명(예: "문 소리 강조")과 '이벤트 롤(Event roll)' 전사에서 유도된 이벤트 타이밍의 그래픽적 표현을 활용하여, 복잡한 장면 내 개별 사운드 이벤트를 삭제, 삽입, 강조할 수 있는 시스템을 제안한다. 제안하는 시스템은 SoundStream 표현을 기반으로 하는 인코더-디코더형 트랜스포머 아키텍처로 구성되며, 고밀도의 실제 배경에 고립된 사운드 이벤트를 추가하여 생성한 합성된 입력-목표 출력 오디오 쌍을 기반으로 훈련된다. 평가 결과는 편집 설명의 각 요소—행동, 클래스, 타이밍—의 중요성을 입증한다. 본 연구는 '재구성(recomposition)'이 중요한 실용적 응용 사례임을 보여준다.