Command Palette

Search for a command to run...

Aysenur Kocak Shuo Yang Bardh Prenkaj Gjergji Kasneci

초록

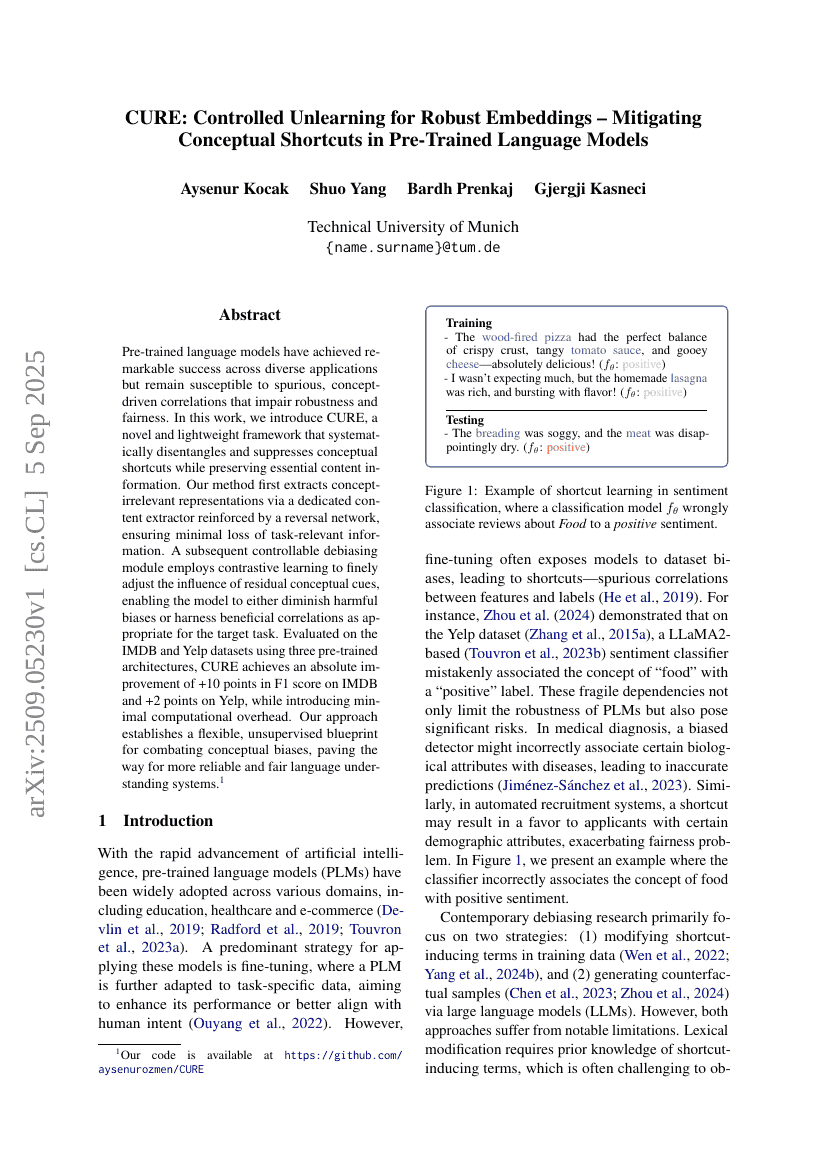

사전 훈련된 언어 모델은 다양한 응용 분야에서 놀라운 성과를 거두었으나, 모델의 견고성과 공정성에 악영향을 미치는 부정확한 개념 중심의 상관관계에 취약한 문제가 있다. 본 연구에서는 개념적 단순화 경로를 체계적으로 분리하고 억제하면서도 핵심적인 내용 정보를 유지하는 새로운 경량 프레임워크 CURE를 제안한다. 제안된 방법은 먼저 역방향 네트워크를 통해 강화된 전용 콘텐츠 추출기(-content extractor)를 활용하여 개념에 무관한 표현을 추출함으로써, 작업에 관련된 정보 손실을 최소화한다. 이후, 조절 가능한 편향 제거 모듈이 대조 학습(contrastive learning)을 활용해 잔여 개념적 신호의 영향을 정밀하게 조정함으로써, 목적 작업에 따라 유해한 편향을 감소시키거나 유익한 상관관계를 활용할 수 있도록 한다. 세 가지 사전 훈련된 아키텍처를 사용하여 IMDB 및 Yelp 데이터셋에서 평가한 결과, CURE는 IMDB에서 F1 점수 기준으로 +10점의 절대적 개선을, Yelp에서는 +2점의 개선을 달성하였으며, 계산 오버헤드는 극도로 낮게 유지하였다. 본 연구는 개념적 편향에 대응하기 위한 유연하고 비지도(unsupervised)의 설계 원리를 제시하며, 더욱 신뢰성 있고 공정한 언어 이해 시스템의 발전을 위한 기반을 마련한다.