Command Palette

Search for a command to run...

Mao Zheng Zheng Li Bingxin Qu Mingyang Song Yang Du Mingrui Sun Di Wang

초록

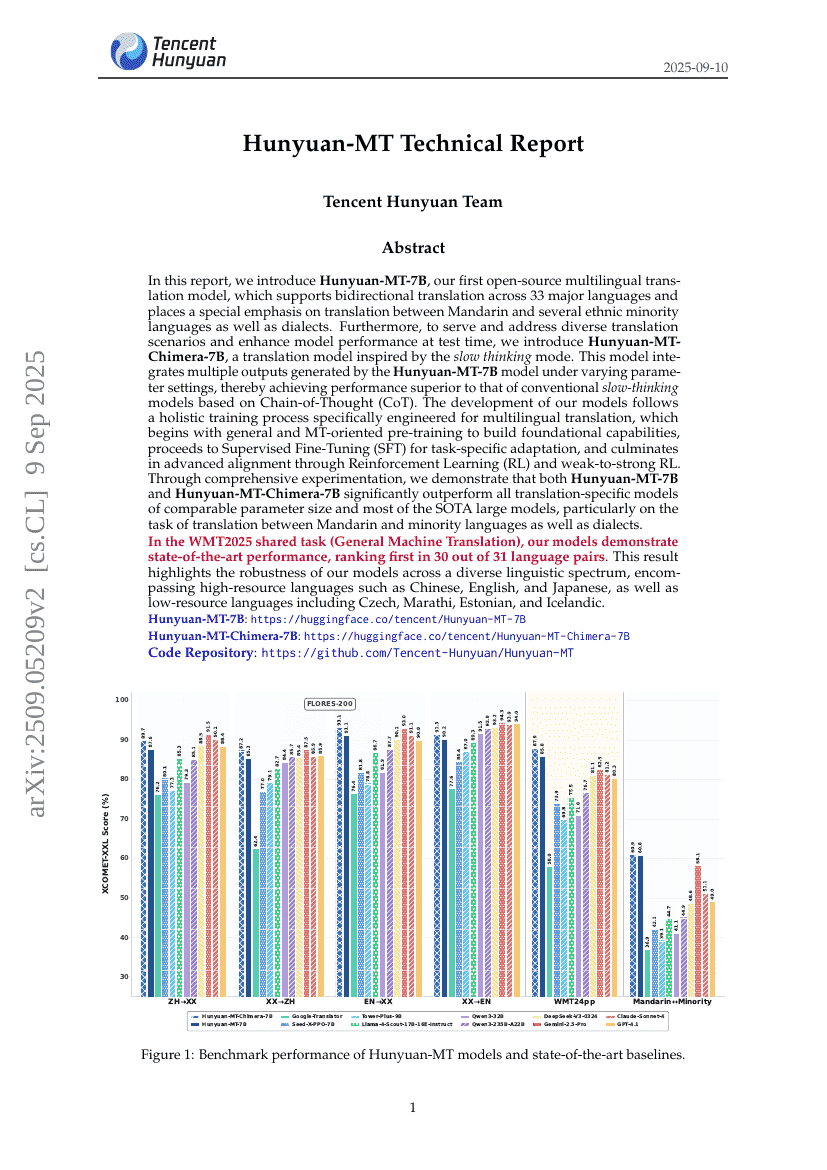

이 보고서에서는 33개 주요 언어 간 양방향 번역을 지원하며, 특히 중국어(표준어)와 여러 소수민족 언어 및 방언 간 번역에 특별한 중점을 두고 있는, 저희가 처음으로 공개한 다국어 번역 모델인 Hunyuan-MT-7B를 소개한다. 또한 다양한 번역 시나리오를 수용하고 테스트 시 성능을 향상시키기 위해, ‘느린 사고 모드’를 영감으로 삼은 번역 모델인 Hunyuan-MT-Chimera-7B를 제안한다. 이 모델은 다양한 파라미터 설정 하에서 Hunyuan-MT-7B 모델이 생성한 다수의 출력을 통합함으로써, 기존의 사고 체인(Chain-of-Thought, CoT) 기반의 전통적 ‘느린 사고’ 모델보다 뛰어난 성능을 달성한다. 본 모델들의 개발은 다국어 번역에 특화된 종합적인 훈련 프로세스를 따르며, 먼저 일반적인 사전 훈련과 번역 중심 사전 훈련을 통해 기초 능력을 구축하고, 이후 작업에 특화된 적응을 위한 감독 학습 미세조정(Supervised Fine-Tuning, SFT)을 수행한 후, 강화학습(Reinforcement Learning, RL) 및 약한 모델에서 강한 모델로의 진화를 위한 약한-강한 RL(weak-to-strong RL)을 통한 고도의 일치 조정을 완료한다. 광범위한 실험을 통해, Hunyuan-MT-7B 및 Hunyuan-MT-Chimera-7B가 동급 파라미터 규모의 모든 전용 번역 모델과 대부분의 최첨단 대규모 모델을 상회함을 입증하였으며, 특히 중국어와 소수민족 언어 및 방언 간 번역 과제에서 두드러진 성능을 보였다. WMT2025 공동 과제(일반 기계 번역)에서 본 모델들은 31개 언어 쌍 중 30개에서 최고 성능을 기록하며, 중국어, 영어, 일본어와 같은 고자원 언어뿐 아니라 체코어, 마라티어, 에스토니아어, 아이슬란드어와 같은 저자원 언어까지 포함하는 다양한 언어 체계에서 뛰어난 강건성을 입증하였다.