Command Palette

Search for a command to run...

초록

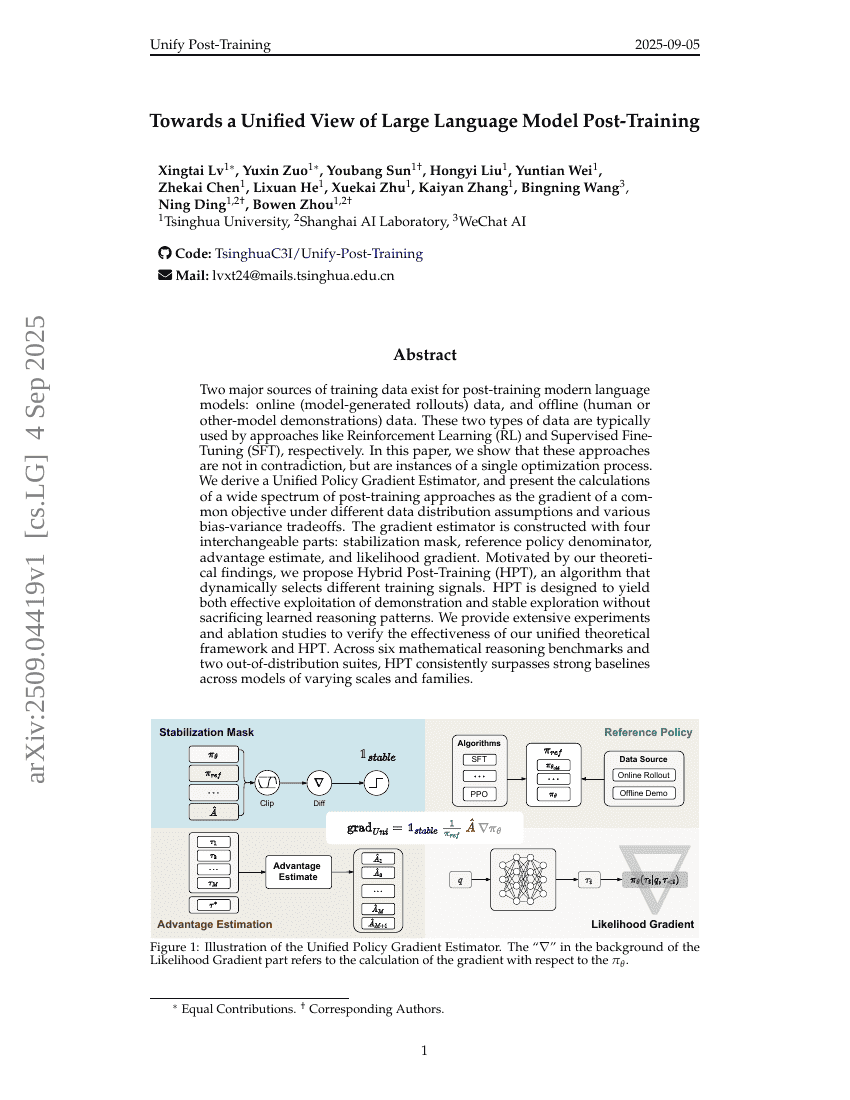

현대 언어 모델의 후기 훈련을 위한 두 가지 주요 데이터 소스가 존재한다. 하나는 온라인(모델 생성 롤아웃 데이터) 데이터이고, 다른 하나는 오프라인(인간 또는 다른 모델의 시범 예제) 데이터이다. 이러한 두 유형의 데이터는 일반적으로 강화학습(RL)과 지도 미세조정(SFT)과 같은 접근 방식에서 각각 사용된다. 본 논문에서는 이러한 접근 방식이 서로 모순되는 것이 아니라, 단일 최적화 과정의 다양한 사례임을 보여준다. 우리는 통합 정책 기울기 추정기(Unified Policy Gradient Estimator)를 도출하였으며, 다양한 데이터 분포 가정과 다양한 편향-분산 트레이드오프 상황에서 동일한 목적 함수의 기울기로서 다양한 후기 훈련 접근 방식의 계산을 제시한다. 이 기울기 추정기는 네 가지 교체 가능한 구성 요소로 구성된다: 안정화 마스크, 기준 정책 분모, 이득 추정치, 그리고 가능도 기울기. 본 연구의 이론적 발견을 바탕으로, 다양한 훈련 신호를 동적으로 선택하는 하이브리드 후기 훈련(Hybrid Post-Training, HPT) 알고리즘을 제안한다. HPT는 시범 데이터의 효과적인 활용과 안정적인 탐색을 동시에 달성하면서도 학습된 추론 패턴을 손상시키지 않도록 설계되었다. 제안된 통합 이론적 프레임워크와 HPT의 효과성을 검증하기 위해 광범위한 실험 및 제거 실험(ablation studies)을 수행하였다. 다양한 규모와 계열을 가진 모델을 대상으로 한 6개의 수학적 추론 벤치마크 및 2개의 분포 외(Out-of-Distribution) 세트에서 HPT는 일관되게 강력한 기준 모델들을 상회하였다.