Command Palette

Search for a command to run...

Shuzhou Yang Xiaoyu Li Xiaodong Cun Guangzhi Wang Lingen Li Ying Shan Jian Zhang

초록

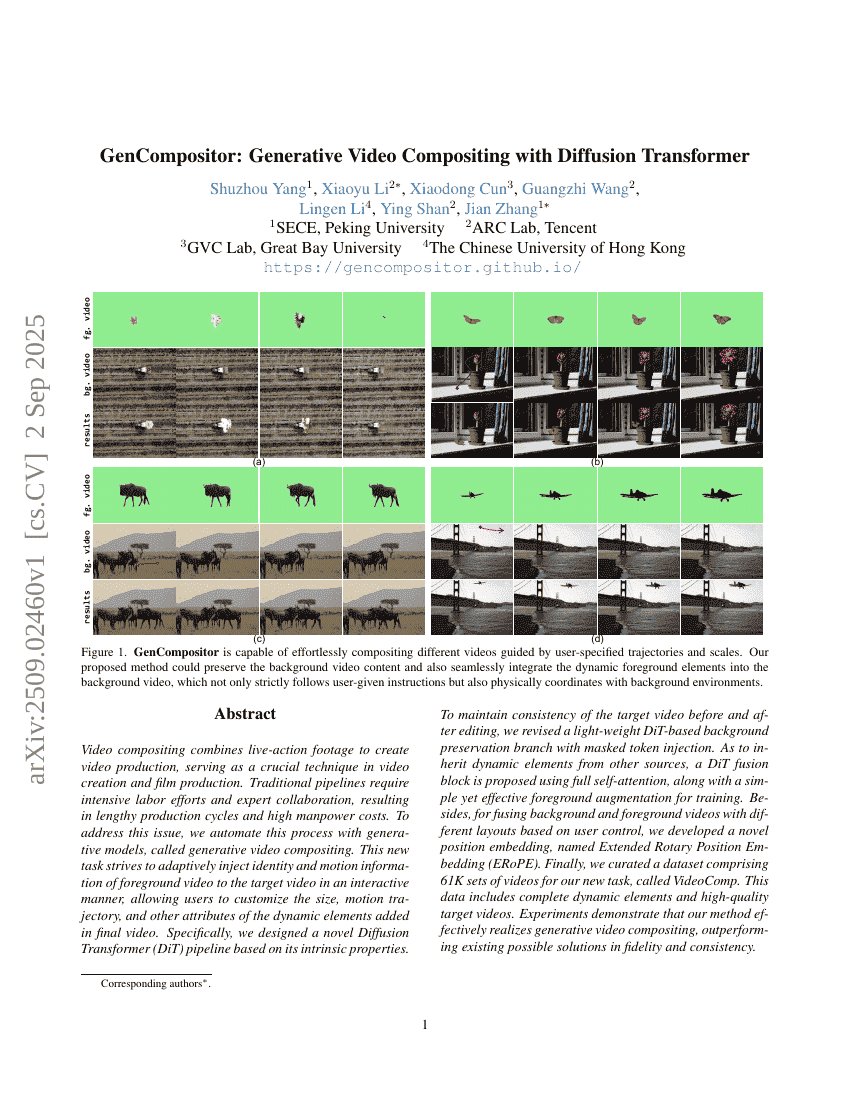

비디오 컴포지팅은 실사 영상을 결합하여 영상 제작을 가능하게 하는 기술로, 영상 제작 및 영화 제작에서 핵심적인 역할을 한다. 기존의 작업 흐름은 인력에 대한 높은 요구와 전문가 간의 협업을 필요로 하여 제작 주기가 길고 인건비가 상당히 발생하는 문제가 있었다. 이에 대응하기 위해 우리는 생성 모델을 활용하여 이 과정을 자동화한 새로운 접근법, 즉 생성형 비디오 컴포지팅(generative video compositing)을 제안한다. 본 작업은 사용자가 상호작용적으로 전경 영상의 정체성(identity)과 운동 정보를 목표 영상에 적응적으로 삽입할 수 있도록 하여, 최종 영상에 추가되는 동적 요소의 크기, 운동 궤적 등 다양한 속성을 사용자 맞춤형으로 설정할 수 있도록 한다. 구체적으로, 생성 모델의 본질적 특성을 기반으로 한 새로운 디퓨전 트랜스포머(Diffusion Transformer, DiT) 파이프라인을 설계하였다. 편집 전후의 목표 영상 일관성을 유지하기 위해, 마스크된 토큰 주입을 활용한 경량 DiT 기반의 배경 보존 브랜치를 제안하였다. 또한, 다른 소스로부터 동적 요소를 계승할 수 있도록, 전체 자기 주의(self-attention) 구조를 사용하는 DiT 융합 블록과 함께, 학습에 효과적인 전경 증강 기법을 도입하였다. 더불어, 사용자 제어 기반으로 레이아웃이 다른 배경 및 전경 영상 간의 융합을 가능하게 하기 위해, 새로운 위치 임베딩 기법인 확장된 회전 위치 임베딩(Extended Rotary Position Embedding, ERoPE)을 개발하였다. 마지막으로, 본 연구의 새로운 작업을 위한 데이터셋을 구축하였으며, 이를 VideoComp라 명명하였다. 이 데이터셋은 총 61,000개의 영상 쌍으로 구성되어 있으며, 완전한 동적 요소와 고화질의 목표 영상이 포함되어 있다. 실험 결과, 제안한 방법이 기존 가능한 솔루션들에 비해 품질과 일관성 측면에서 뛰어난 성능을 보임을 입증하였다.