Command Palette

Search for a command to run...

Zetong Zhou Dongping Chen Zixian Ma Zhihan Hu Mingyang Fu Sinan Wang Yao Wan Zhou Zhao Ranjay Krishna

초록

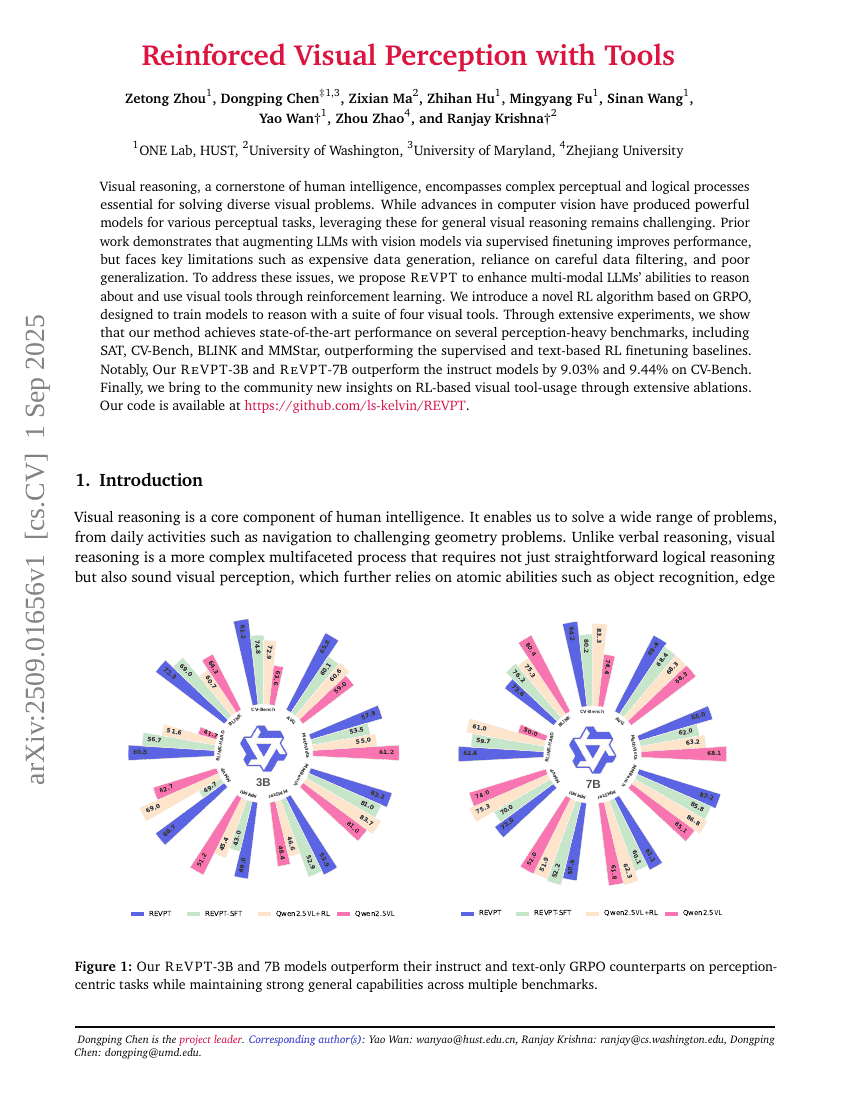

시각적 추론은 인간 지능의 핵심 요소로, 다양한 시각적 문제를 해결하는 데 필수적인 복잡한 인지적 및 논리적 과정을 포함한다. 컴퓨터 비전 분야의 발전은 여러 인지적 과제에 대해 강력한 모델을 도출해냈지만, 이러한 모델을 일반적인 시각적 추론에 효과적으로 활용하는 것은 여전히 도전 과제이다. 기존 연구들은 감독적 미세조정을 통해 대규모 언어 모델(Large Language Models, LLM)에 시각 모델을 통합함으로써 성능을 향상시킬 수 있음을 보여주었으나, 데이터 생성 비용이 높고, 정교한 데이터 필터링에 의존하며 일반화 성능이 낮다는 주요 한계를 지닌다. 이러한 문제를 해결하기 위해, 우리는 강화학습(Reinforcement Learning, RL)을 활용하여 다모달 LLM이 시각 도구를 추론하고 활용하는 능력을 향상시키는 새로운 방법인 ReVPT를 제안한다. 본 연구에서는 네 가지 시각 도구를 활용한 추론을 학습할 수 있도록 설계된 새로운 RL 알고리즘을 도입하였으며, 이는 GRPO(Gradient-based Reward Policy Optimization) 기반의 아키텍처를 기반으로 한다. 광범위한 실험을 통해 제안하는 방법이 SAT, CV-Bench, BLINK, MMStar 등 시각 인식 중심의 여러 벤치마크에서 최고 수준의 성능을 달성함을 입증하였으며, 감독 학습 및 텍스트 기반 강화학습 기반 미세조정 기법과 비교해 크게 우수한 성능을 보였다. 특히, ReVPT-3B와 ReVPT-7B는 CV-Bench에서 지시 기반 모델(Instruction-tuned models)보다 각각 9.03%, 9.44% 높은 성능을 기록하였다. 마지막으로, 광범위한 아블레이션 실험을 통해 강화학습 기반 시각 도구 사용에 관한 새로운 통찰을 공동체에 제공한다. 본 연구의 코드는 https://github.com/ls-kelvin/REVPT 에 공개되어 있다.