Command Palette

Search for a command to run...

Mohammad Zbeeb Hasan Abed Al Kader Hammoud Bernard Ghanem

초록

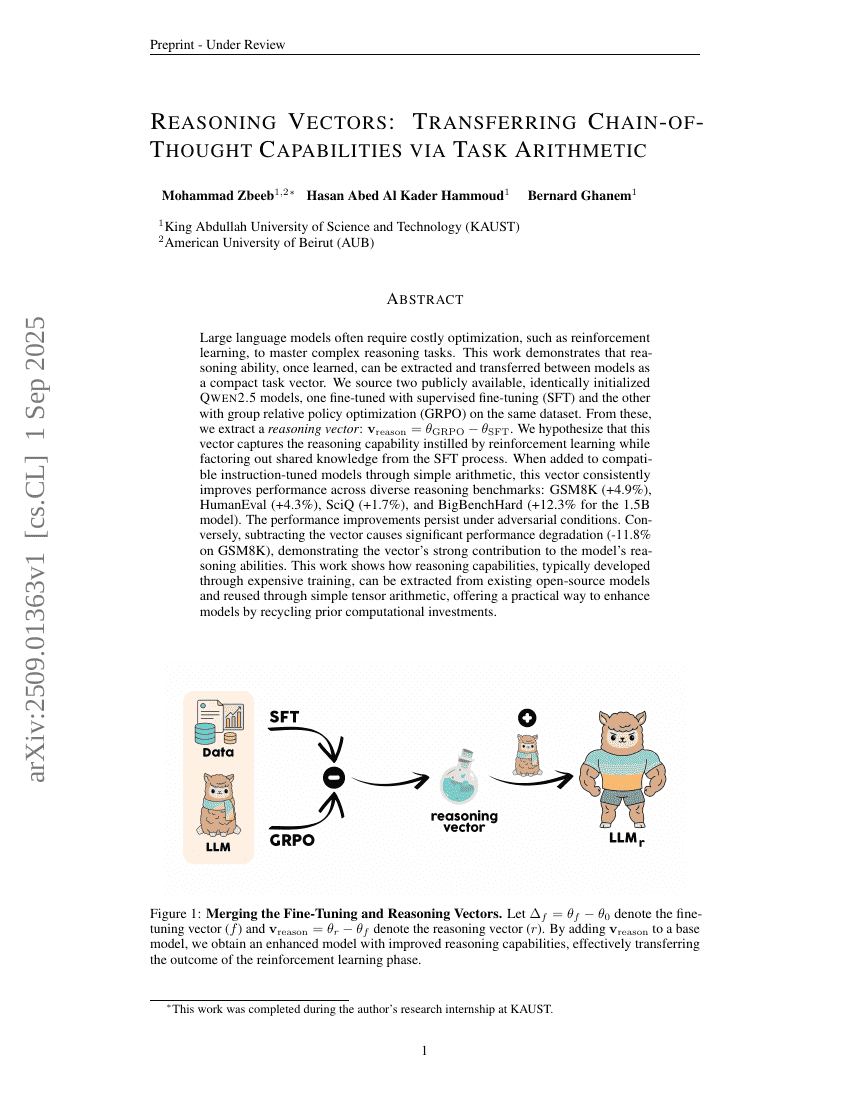

대규모 언어 모델은 복잡한 추론 작업을 습득하기 위해 비용이 많이 드는 최적화 기법, 예를 들어 강화학습을 필요로 하는 경우가 많다. 본 연구는 이미 학습된 추론 능력이 추출되어 모델 간에 효율적으로 전이될 수 있음을 보여주며, 이를 작고 컴팩트한 작업 벡터로 표현할 수 있음을 제시한다. 우리는 동일하게 초기화된 두 개의 공개된 Qwen2.5 모델을 활용하였으며, 동일한 데이터셋에서 하나는 감독적 미세조정(SFT)으로, 다른 하나는 그룹 상대적 정책 최적화(GRPO)로 미세조정하였다. 이 두 모델로부터 추론 벡터를 추출한다: ( v_{\text{reason}} = \theta_{\text{GRPO}} - \theta_{\text{SFT}} ). 우리는 이 벡터가 강화학습을 통해 부여된 추론 능력을 포착하고, SFT 과정에서 공유되는 지식을 제거함으로써 순수한 추론 능력만을 담고 있다고 가정한다. 이 벡터를 간단한 산술 연산을 통해 호환되는 지시어 조정 모델에 추가하면, 다양한 추론 벤치마크에서 일관되게 성능 향상이 나타난다. 구체적으로 GSM8K(+4.9%), HumanEval(+4.3%), SciQ(+1.7%), 그리고 BigBenchHard(1.5B 모델 기준 +12.3%)에서 성능이 향상된다. 이 성능 향상은 악의적인 환경에서도 지속되며, 반대로 이 벡터를 제거하면 성능이 크게 저하되며(GSM8K 기준 -11.8%), 이는 해당 벡터가 모델의 추론 능력에 핵심적인 기여를 한다는 것을 입증한다. 본 연구는 일반적으로 비용이 많이 드는 학습 과정을 통해 개발되는 추론 능력을 기존 오픈소스 모델에서 추출하여, 단순한 텐서 산술을 통해 재사용할 수 있음을 보여주며, 과거에 투자된 계산 자원을 효율적으로 재활용함으로써 모델 성능을 향상시키는 실용적인 방법을 제시한다.