Command Palette

Search for a command to run...

초록

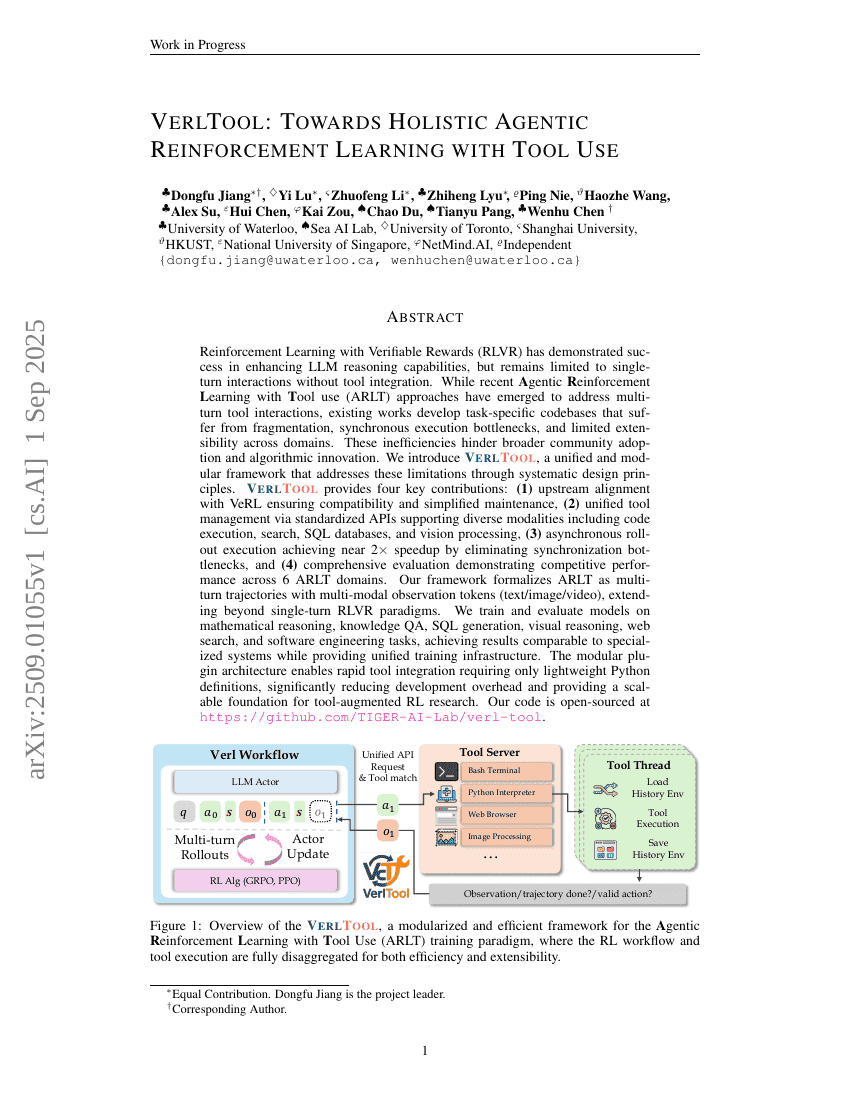

검증 가능한 보상과 함께한 강화학습(RLVR, Reinforcement Learning with Verifiable Rewards)은 대규모 언어 모델(LLM)의 추론 능력을 향상시키는 데 성공을 거두었으나, 도구 통합 없이 단일 턴 상호작용에 국한되어 있다. 최근에는 다중 턴 도구 상호작용을 해결하기 위해 도구 사용을 포함한 에이전트 기반 강화학습(ARLT, Agentic Reinforcement Learning with Tool use) 접근법이 등장하였으나, 기존 연구들은 각각의 작업에 특화된 코드베이스를 개발함으로써 분산화, 동기화 실행의 성능 저하, 그리고 다양한 분야 간 확장성의 한계를 겪고 있다. 이러한 비효율성은 더 넓은 공동체의 채택과 알고리즘 혁신을 저해하고 있다. 본 연구에서는 체계적인 설계 원칙을 통해 이러한 한계를 해결하는 통합적이고 모듈화된 프레임워크인 VerlTool을 제안한다. VerlTool은 다음과 같은 네 가지 주요 기여를 한다: (1) VeRL과의 상류 일치를 통해 호환성과 유지보수의 단순화를 보장하며, (2) 표준화된 API를 통한 통합적 도구 관리로 코드 실행, 검색, SQL 데이터베이스, 시각 처리 등 다양한 모달리티를 지원하며, (3) 비동기적 롤아웃 실행을 통해 동기화 병목 현상을 제거하여 거의 2배의 속도 향상을 달성하며, (4) 6개의 ARLT 영역에서 경쟁력 있는 성능을 보여주는 포괄적인 평가를 수행한다. 본 프레임워크는 텍스트/이미지/동영상 등 다중 모달 관측 토큰을 포함하는 다중 턴 트래잭터리로 ARLT를 공식화함으로써 단일 턴 RLVR 패러다임을 넘어선다. 우리는 수학적 추론, 지식 기반 질의응답(QA), SQL 생성, 시각적 추론, 웹 검색, 소프트웨어 공학 등 다양한 과제에서 모델을 훈련 및 평가하였으며, 전문 시스템과 비교해도 유사한 성능을 달성하면서도 통합된 훈련 인프라를 제공한다. 모듈형 플러그인 아키텍처는 가벼운 Python 정의만으로도 도구를 신속하게 통합할 수 있게 하여 개발 부담을 크게 줄이고, 도구 증강형 강화학습 연구를 위한 확장 가능한 기반을 제공한다. 본 연구의 코드는 https://github.com/TIGER-AI-Lab/verl-tool 에서 오픈소스로 공개된다.