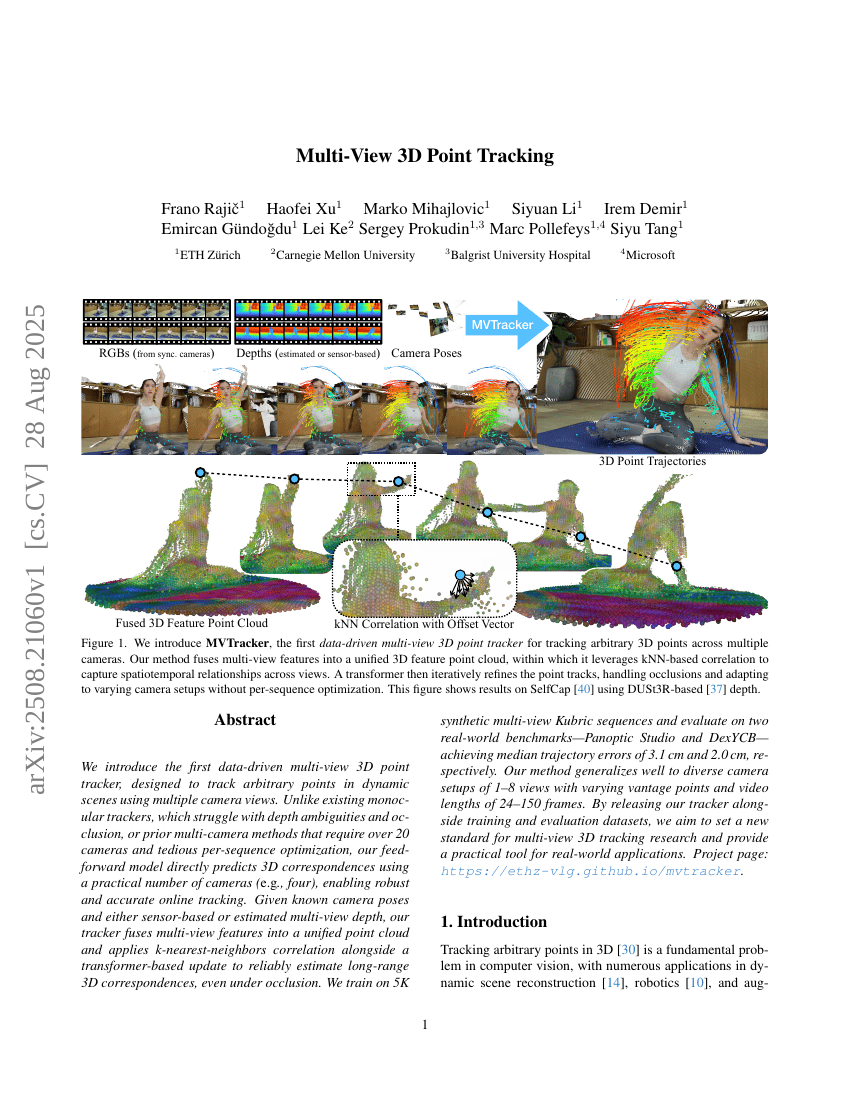

다중 시점 3차원 점 추적

우리는 다중 카메라 시각을 활용하여 동적 장면에서 임의의 점을 추적할 수 있도록 설계된 최초의 데이터 기반 다중 시점 3D 점 추적기(Multi-view 3D Point Tracker)를 소개한다. 기존의 단일 카메라 기반 추적기들은 깊이에 대한 모호성과 가림 현상으로 인해 성능이 제한되는 반면, 기존의 다중 카메라 방법은 20대 이상의 카메라를 요구하고 시퀀스별로 복잡한 최적화 과정이 필요하다는 점에서 현실성에 결함이 있었다. 본 연구에서 제안하는 전방향(Feed-forward) 모델은 실용적인 수준의 카메라 수(예: 4대)만으로도 3D 대응점을 직접 예측함으로써, 강인하고 정확한 온라인 추적을 가능하게 한다. 알려진 카메라 자세와 센서 기반 또는 추정된 다중 시점 깊이 정보를 기반으로, 본 추적기는 다중 시점 특징을 통합된 포인트 클라우드로 융합하고, k-최근접 이웃(KNN) 상관관계와 트랜스포머 기반 업데이트를 결합하여, 가림 상황에서도 장거리 3D 대응점을 신뢰성 있게 추정한다. 본 모델은 5,000개의 합성 다중 시점 Kubric 시퀀스를 활용하여 학습하였으며, 실제 환경에서 평가하기 위해 Panoptic Studio 및 DexYCB 두 가지 벤치마크를 사용하여 각각 3.1cm, 2.0cm의 중앙 트랙 오차(Median Trajectory Error)를 달성하였다. 제안된 방법은 1~8개의 시점, 다양한 관점 및 24~150 프레임 길이의 다양한 카메라 설정에 대해 우수한 일반화 성능을 보였다. 본 추적기와 함께 학습 및 평가용 데이터셋을 공개함으로써, 다중 시점 3D 추적 연구 분야에 새로운 기준을 제시하고 실제 응용에 활용 가능한 실용적 도구를 제공하고자 한다. 프로젝트 페이지는 다음 URL에서 확인할 수 있다.